机器之心报道 机器之心编辑部性能比 GPT-4 强很多。

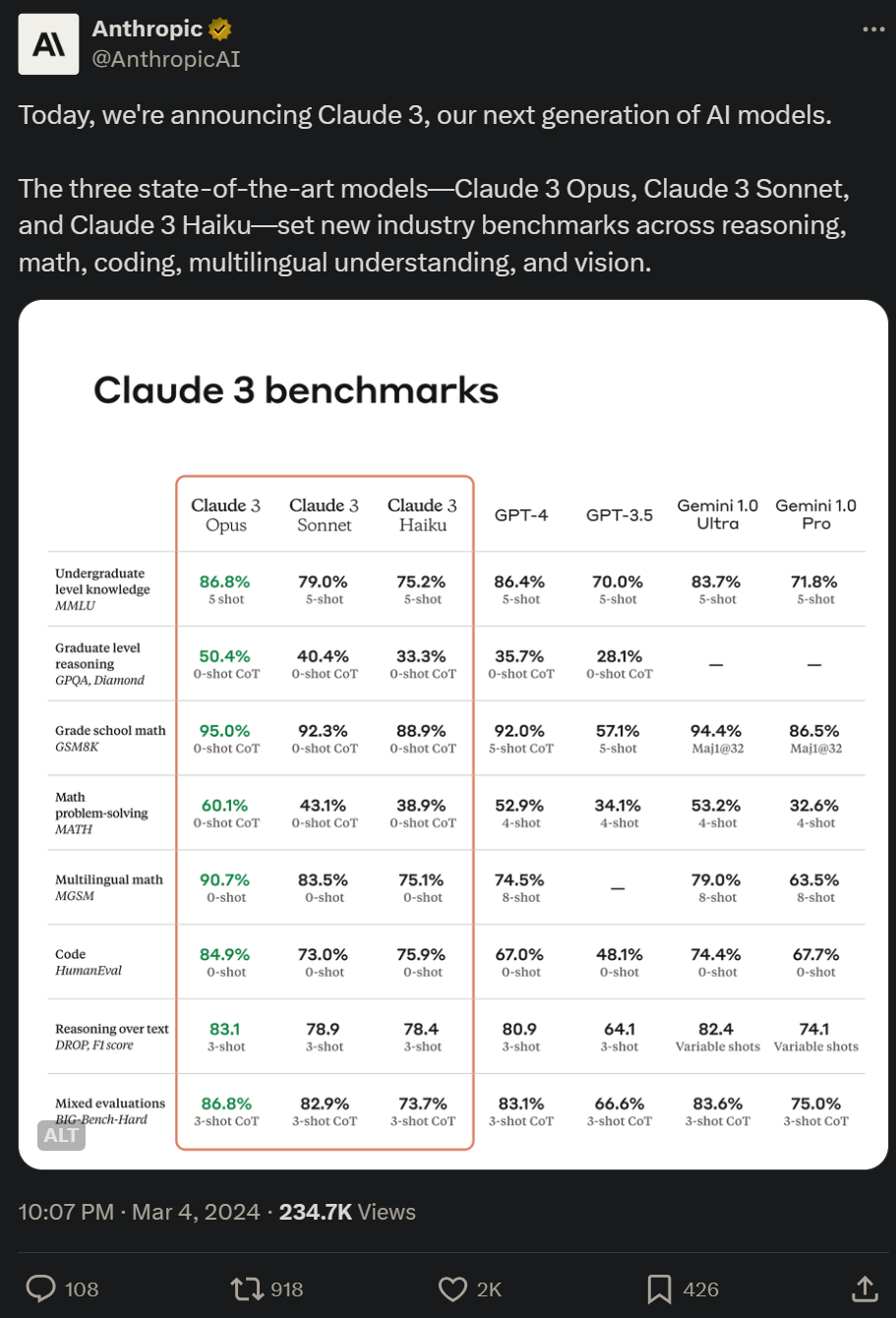

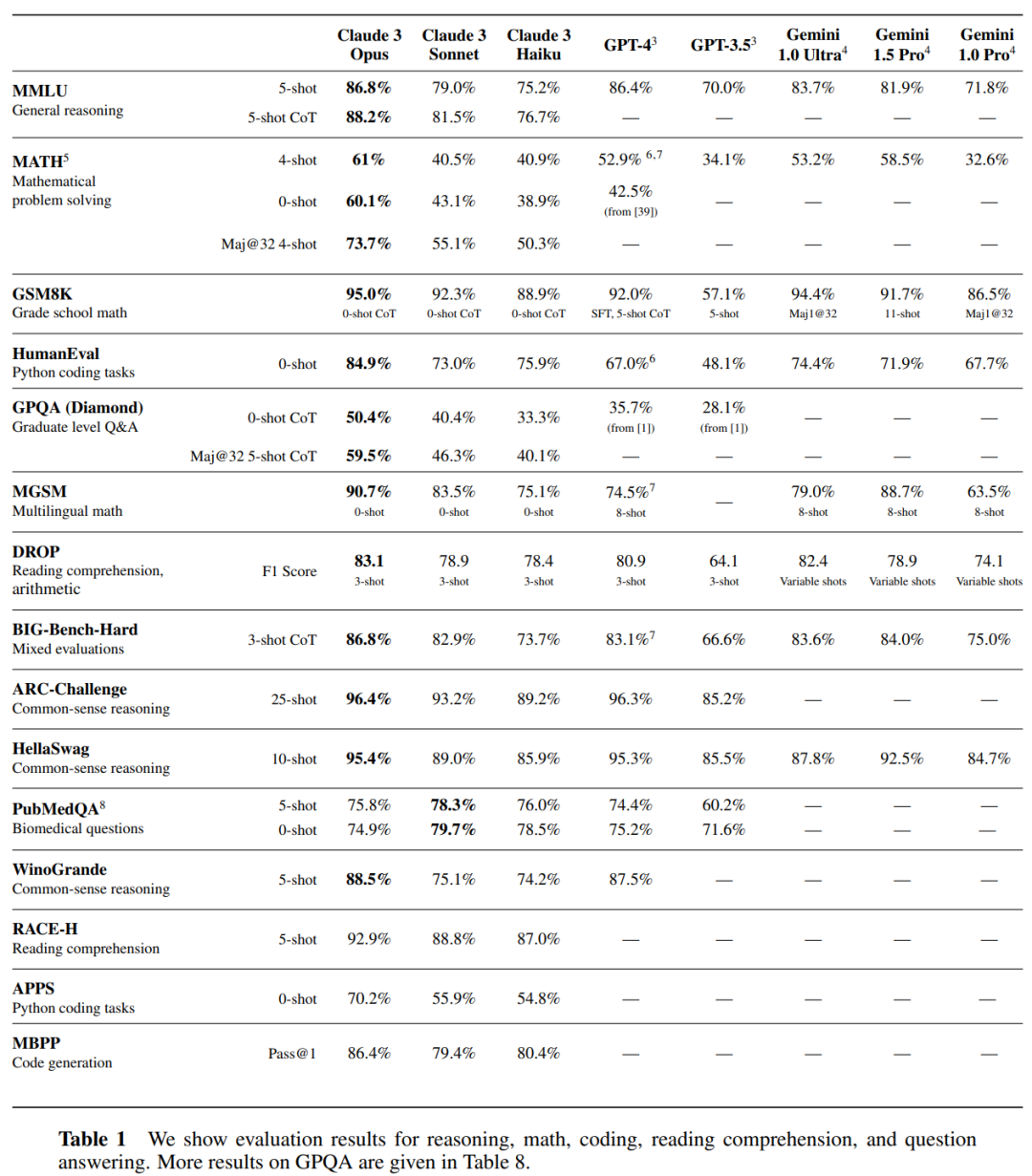

大模型的纯文本方向,已经卷到头了? 昨晚,OpenAI 最大的竞争对手 Anthropic 发布了新一代 AI 大模型系列 ——Claude 3。 该系列包含三个模型,按能力由弱到强排列分别是 Claude 3 Haiku、Claude 3 Sonnet 和 Claude 3 Opus。其中,能力最强的 Opus 在多项基准测试中得分都超过了 GPT-4 和 Gemini 1.0 Ultra,在数学、编程、多语言理解、视觉等多个维度树立了新的行业基准。 Anthropic 表示,Claude 3 Opus 拥有人类本科生水平的知识。

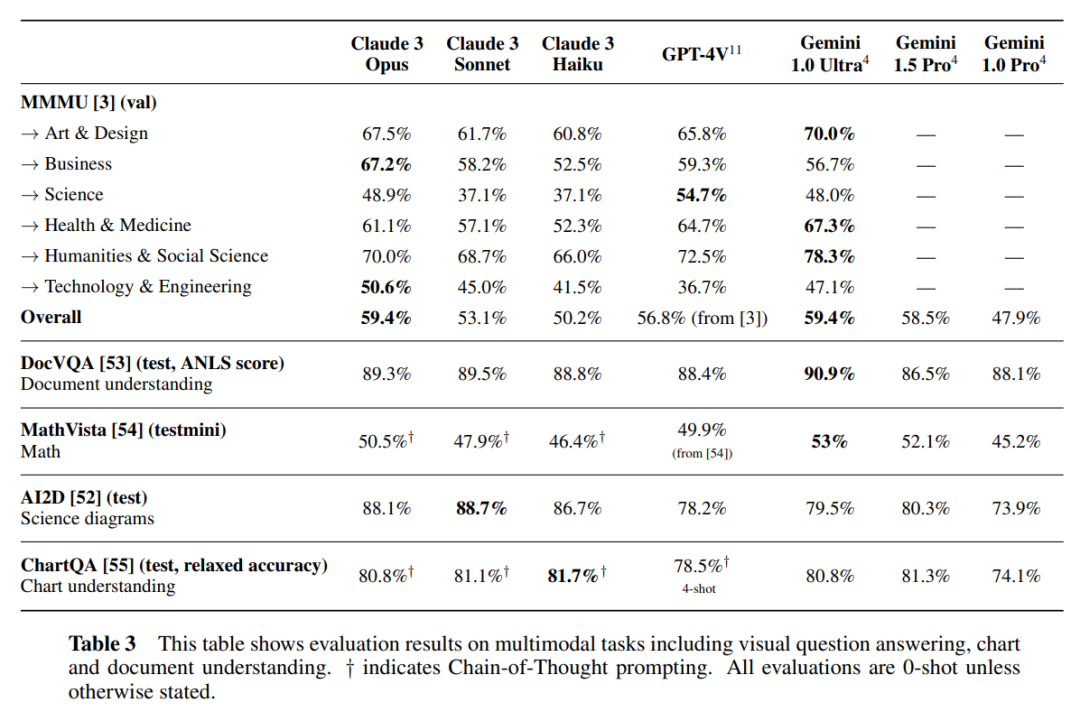

在新模型发布后,Claude 首次带来了对多模态能力的支持(Opus 版本的 MMMU 得分为 59.4%,超过 GPT-4V,与 Gemini 1.0 Ultra 持平)。用户现在可以上传照片、图表、文档和其他类型的非结构化数据,让 AI 进行分析和解答。

此外,这三个模型也延续了 Claude 系列模型的传统强项 —— 长上下文窗口。其初始阶段支持 200K token 上下文窗口,不过,Anthropic 表示,三者都支持 100 万 token 的上下文输入(向特定客户开放),这大约是英文版《白鲸》或《哈利・波特与死亡圣器》的长度。 不过,在定价上,能力最强的 Claude 3 也比 GPT-4 Turbo 要贵得多:GPT-4 Turbo 每百万 token 输入 / 输出收费为 10/30 美元 ;而 Claude 3 Opus 为 15/75 美元。

Opus 和 Sonnet 现可在 claude.ai 和 Claude API 中使用,Haiku 也将于不久后推出。亚马逊云科技也第一时间宣布新模型登陆了 Amazon Bedrock。以下是 Anthropic 发布的官方 demo:

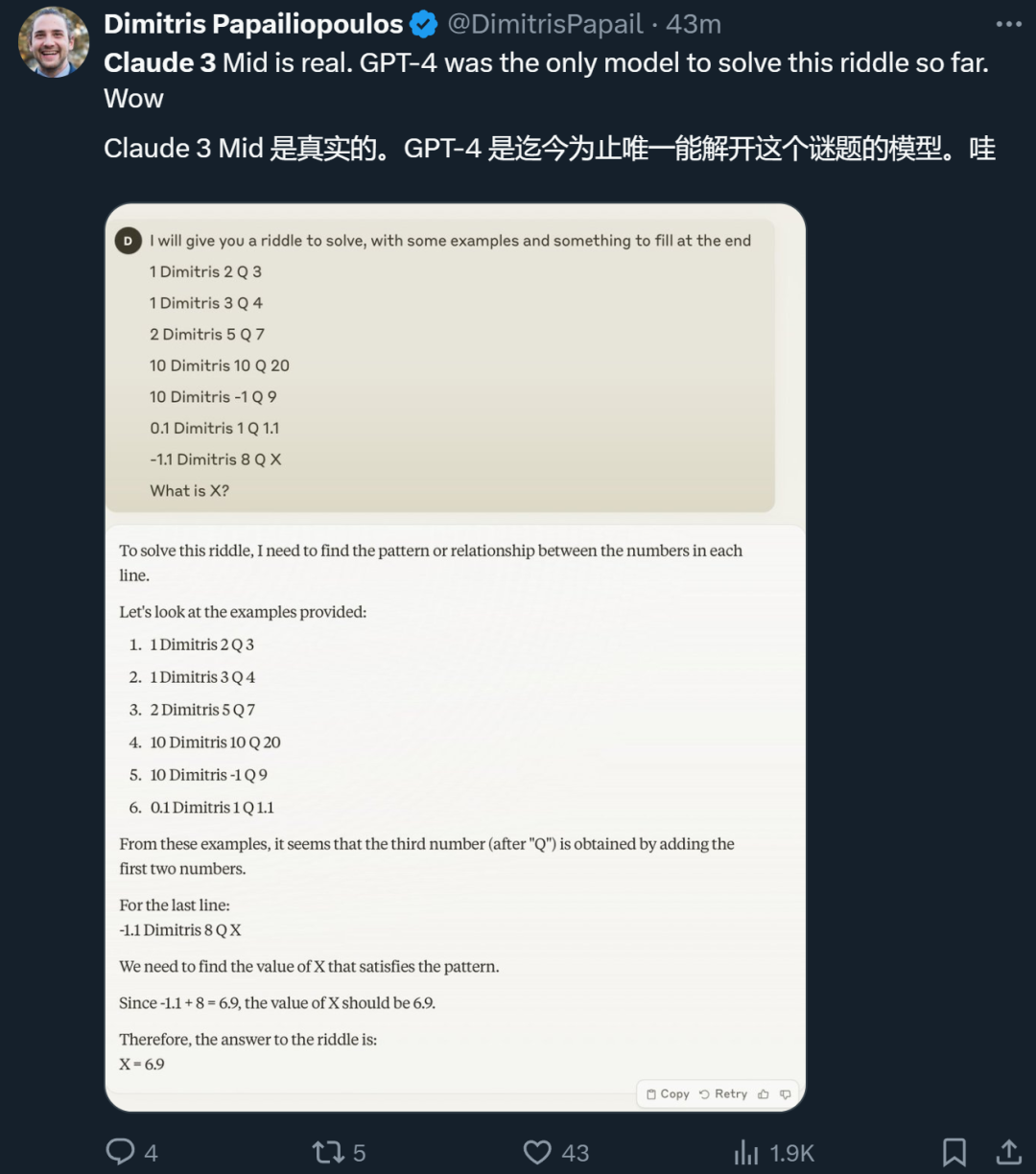

在 Anthropic 官宣之后,不少得到试用机会的研究者也晒出了自己的体验。有人说,Claude 3 Sonnet 解出了一道此前只有 GPT-4 才能解开的谜题。

不过,也有人表示,在实际体验方面,Claude 3 并没有彻底击败 GPT-4。

技术报告里写了什么

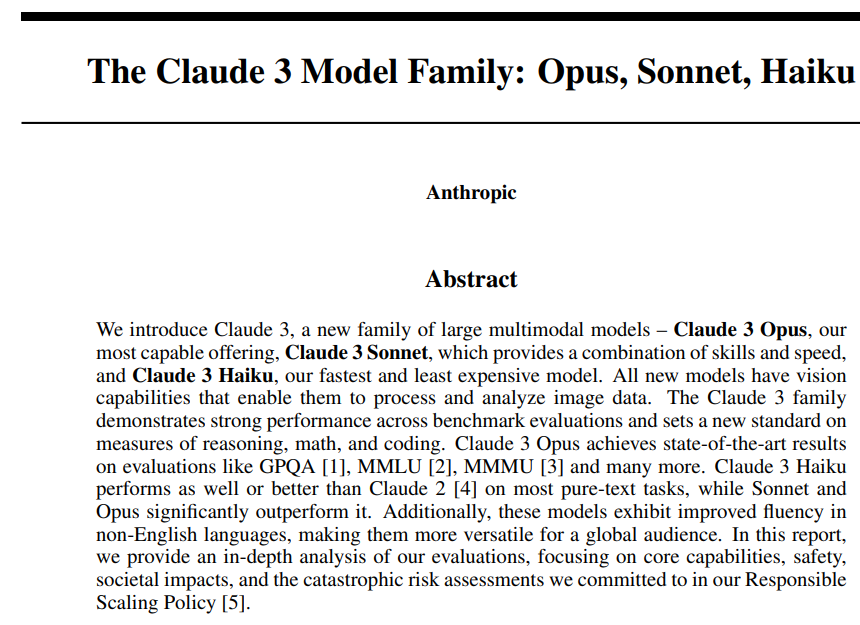

目前,Anthropic 已经放出了 42 页的技术报告《The Claude 3 Model Family: Opus, Sonnet, Haiku》。

报告地址:https://www-cdn.anthropic.com/de8ba9b01c9ab7cbabf5c33b80b7bbc618857627/Model_Card_Claude_3.pdf 我们看到了 Claude 3 系列模型的训练数据、评估标准以及更详细的实验结果。 在训练数据方面,Claude 3 系列模型接受了截至 2023 年 8 月互联网公开可用的专用混合数据的训练,以及来自第三方的非公开数据、数据标签服务商和付费承包商提供的数据、Claude 内部的数据。 Claude 3 系列模型在以下多个指标上接受了广泛的评估,包括:

- 推理能力

- 多语言能力

- 长上下文

- 可靠性 / 事实性

- 多模态能力

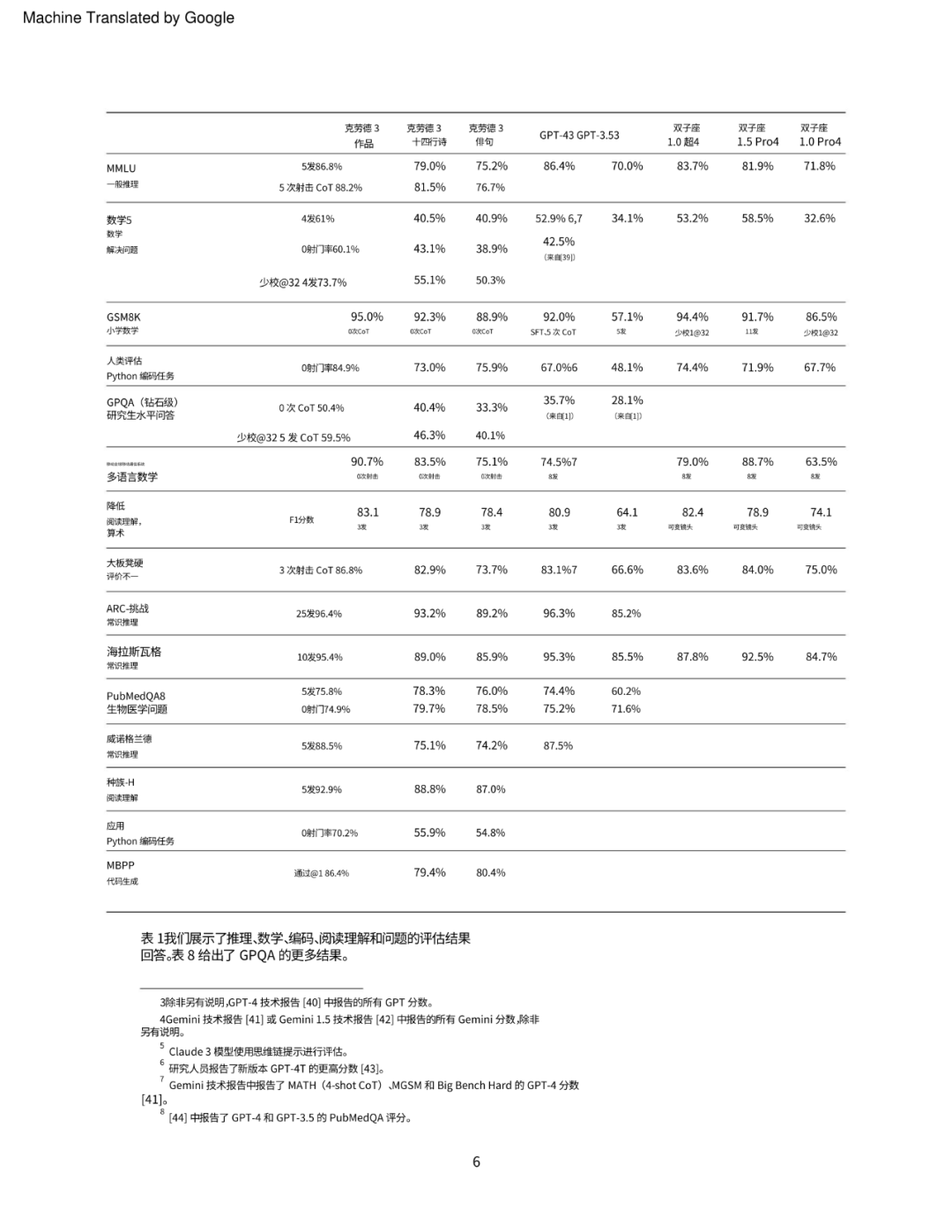

首先是推理、编程和问答任务上的评估结果,Claude 3 系列模型在一系列推理、阅读理解、数学、科学和编程的行业标准基准上与竞品模型展开了比较,结果显示不仅超越了自家以往模型,还在大多数情况下实现了新 SOTA。

Anthropic 在法学院入学考试 (LSAT) 、多州律师考试 (MBE)、美国数学竞赛 2023 年数学竞赛和研究生入学考试 (GRE) 普通考试中评估了 Claude 3 系列模型,具体结果如下表 2 所示。

Claude 3 系列模型具备多模态(图像和视频帧输入)能力,并且在解决超越简单文本理解的复杂多模态推理挑战方面取得了重大进展。 一个典型的例子是 Claude 3 模型在 AI2D 科学图表基准上的表现,这是一种视觉问答评估,涉及图表解析并以多项选择格式回答相应的问题。 Claude 3 Sonnet 在 0-shot 设置中达到了 SOTA 水平 —— 89.2%,其次是 Claude 3 Opus(88.3%)和 Claude 3 Haiku(80.6%),具体结果如下表 3 所示。

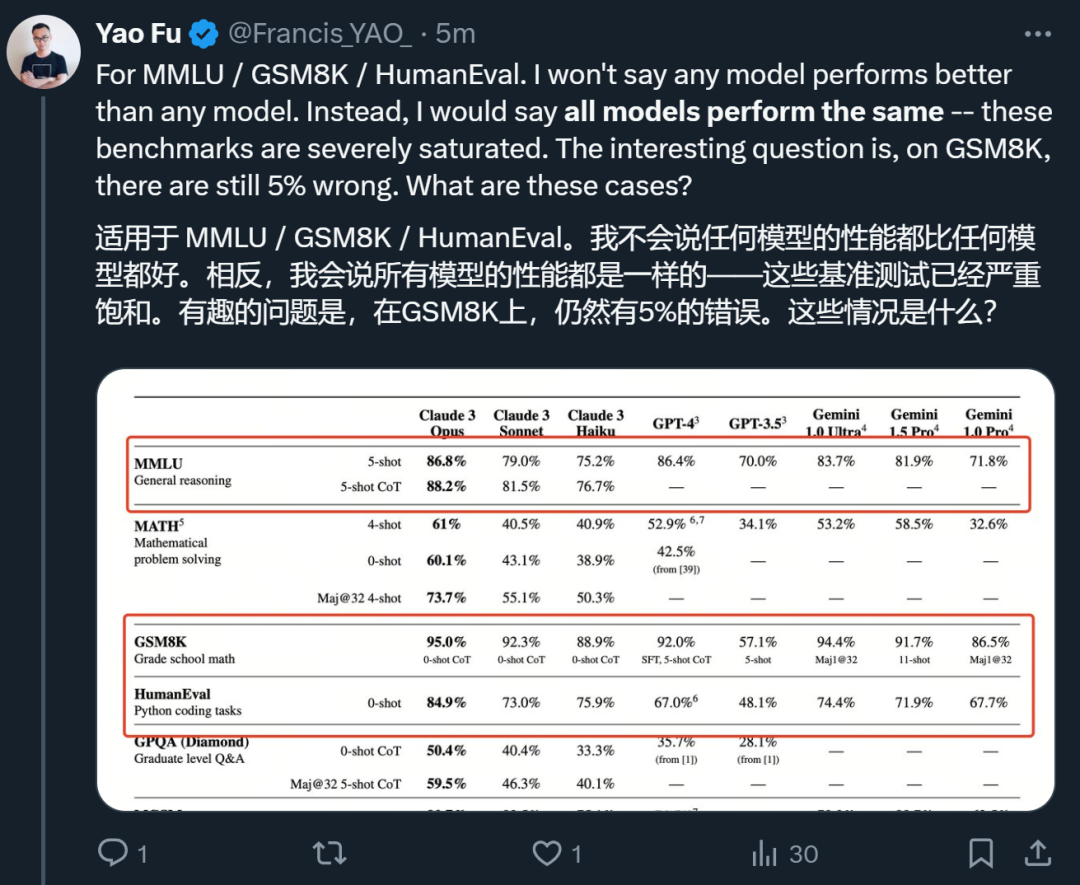

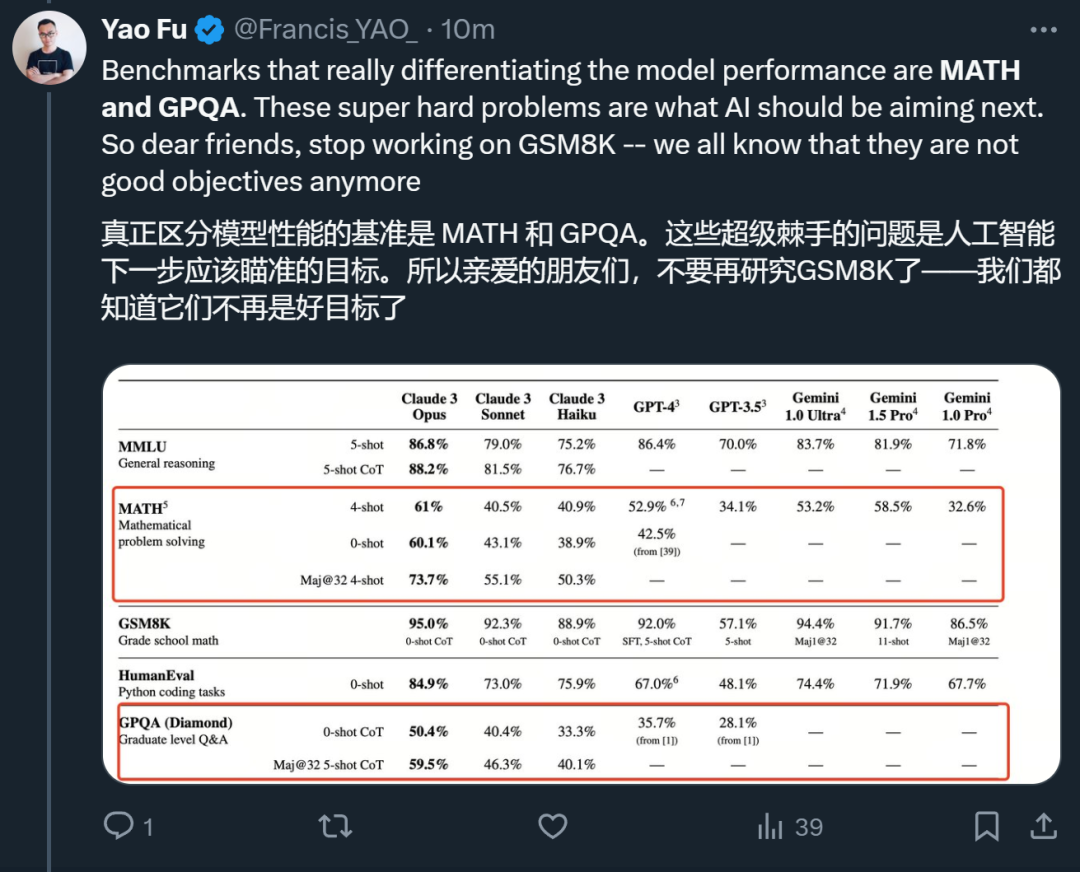

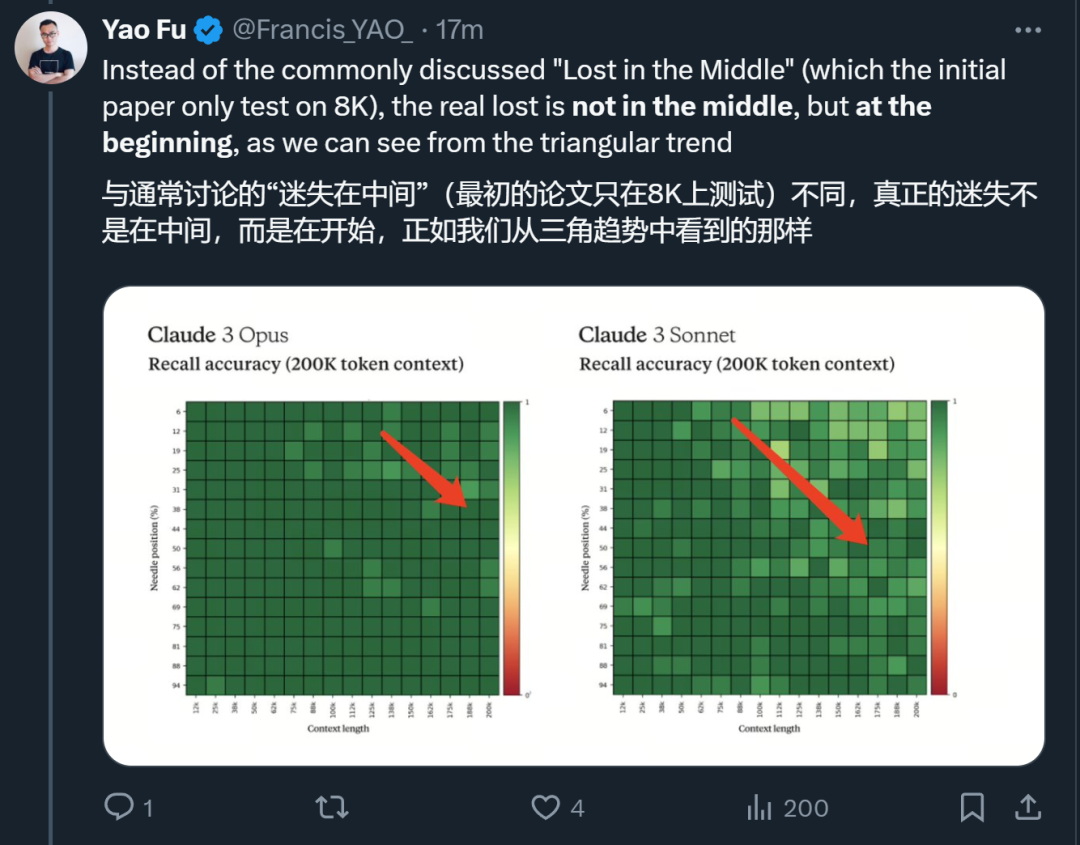

针对这份技术报告,爱丁堡大学博士生符尧在第一时间给出了自己的分析。 首先,在他看来,被评估的几个模型在 MMLU / GSM8K / HumanEval 等几项指标上基本没有区分度,真正需要关心的是为什么最好的模型在 GSM8K 上依然有 5% 的错误。

他认为,真正能够把模型区分开的是 MATH 和 GPQA,这些超级棘手的问题是 AI 模型下一步应该瞄准的目标。

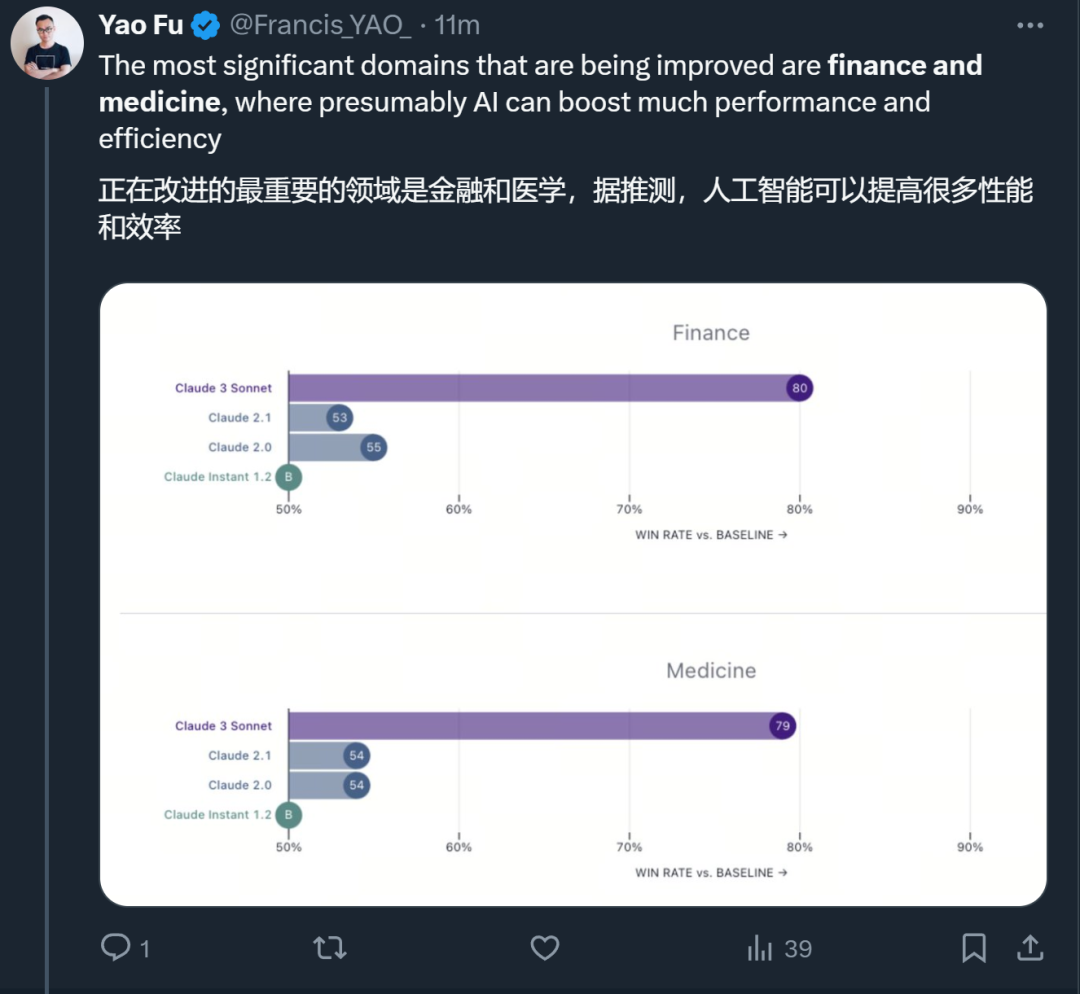

与 Claude 之前的模型相比,改进比较大的领域是金融和医学。

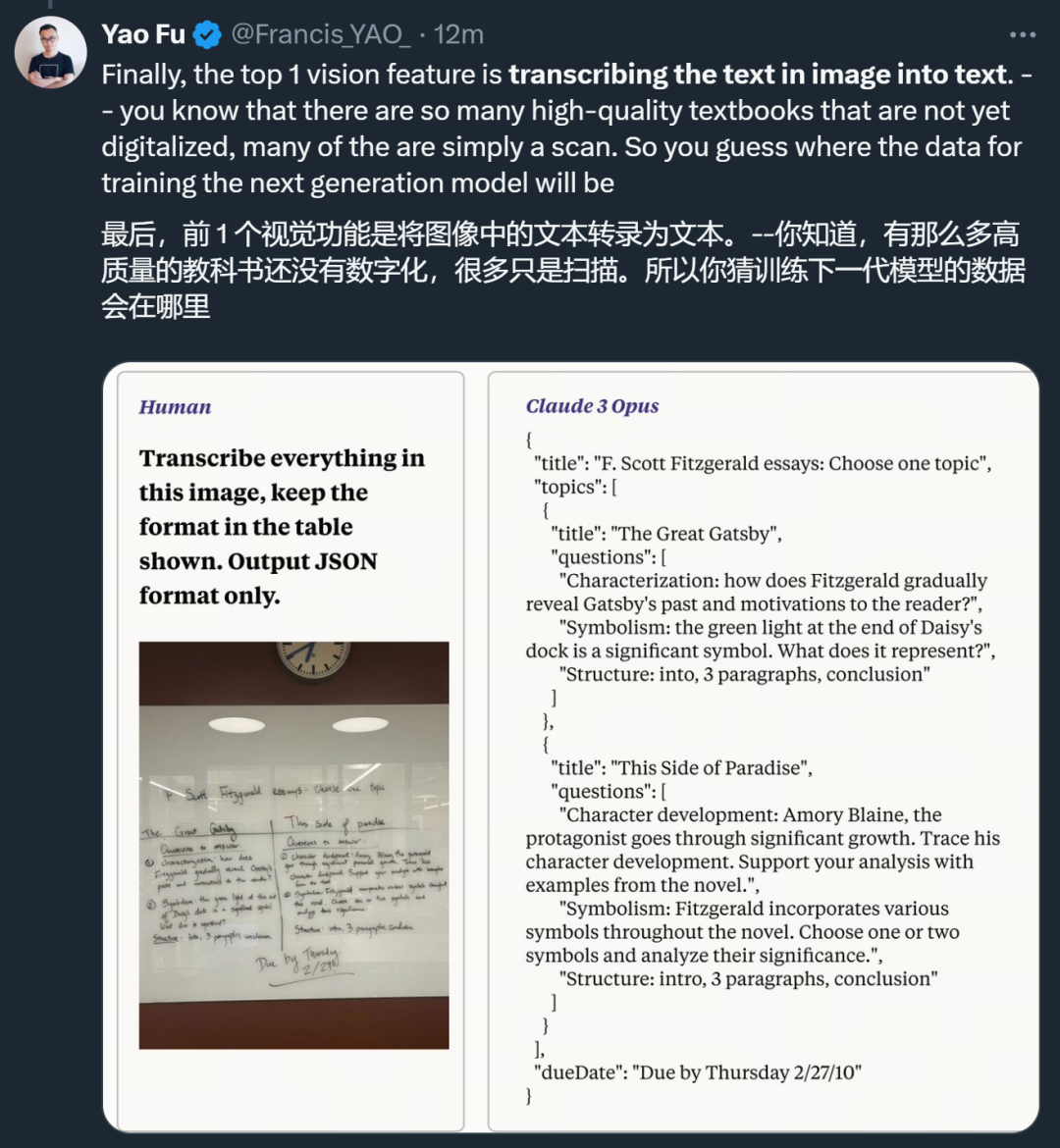

视觉方面,Claude 3 表现出的视觉 OCR 能力让人看到了它在数据收集方面的巨大潜力。

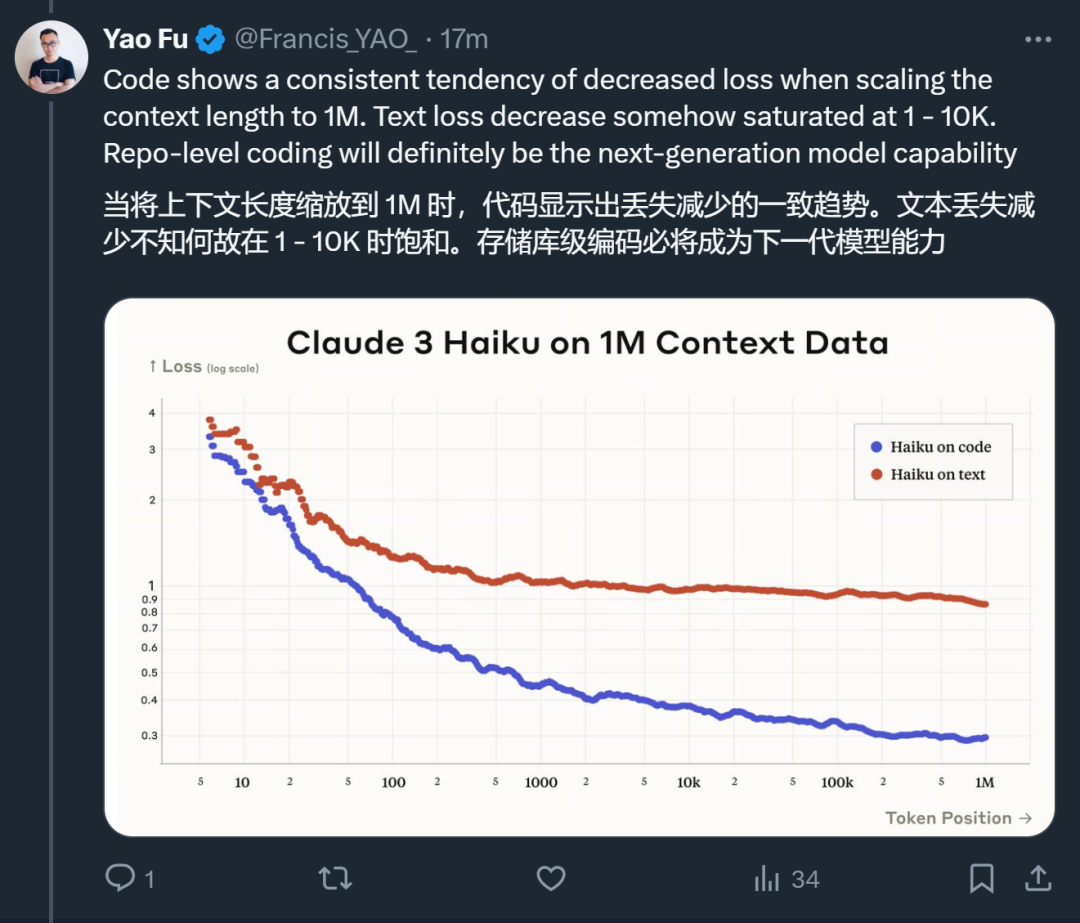

此外,他还发现了其他一些趋势:

从目前的评测基准和体验看来,Claude 3 在智能水平、多模态能力和速度上都取得了长足的进步。随着新系列模型的进一步优化和应用,我们或许将看到更加多元化的大模型生态。

博客地址:https://www.anthropic.com/news/claude-3-family 参考内容:https://www.cnbc.com/2024/03/04/google-backed-anthropic-debuts-claude-3-its-most-powerful-chatbot-yet.htmlhttps://www.aboutamazon.com/news/aws/amazon-bedrock-anthropic-ai-claude-3