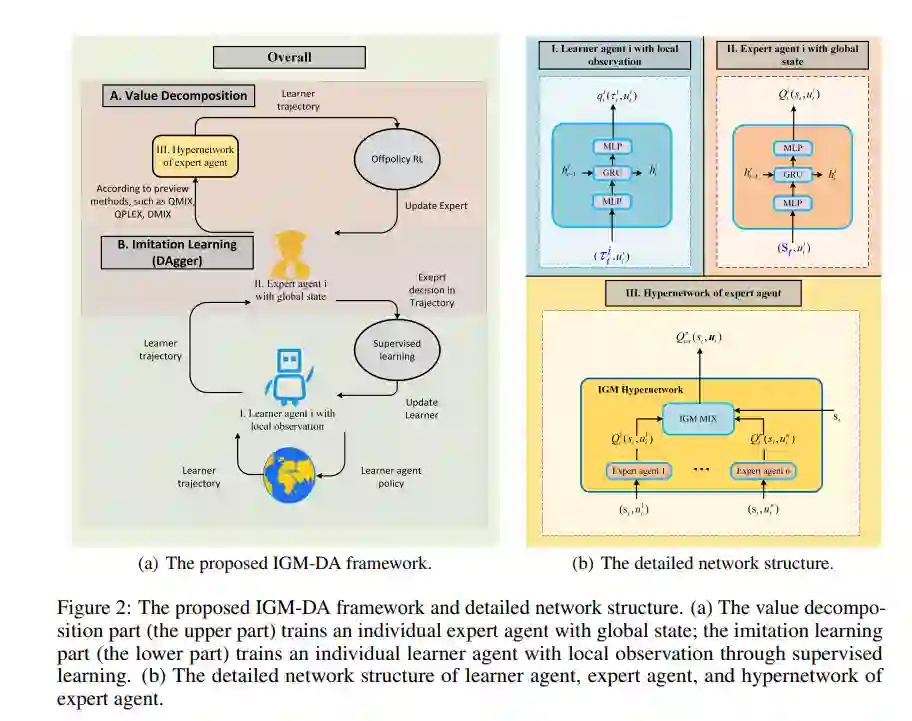

在协同多智能体强化学习中,集中训练和分散执行(CTDE)取得了显著的成功。IGM (Individual Global Max)分解是CTDE的重要组成部分,用来衡量局部策略与联合策略之间的一致性。大多数基于IGM的研究关注于如何建立这种一致的关系,但很少关注检查IGM的潜在缺陷。在这项工作中,我们揭示了IGM条件是一个有损分解,并且有损分解的误差会在基于超网络的方法中积累。针对上述问题,本文提出采用模仿学习策略将有损分解与Bellman迭代分离,从而避免误差累积。在零视点的《星际争霸》多智能体挑战赛基准问题上,对所提策略进行了理论验证和实证验证。结果也证实了提出的方法优于最先进的基于IGM的方法。https://www.zhuanzhi.ai/paper/acf4a4b734b3127ef7ad948ba9fdda23

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年10月29日

Arxiv

0+阅读 · 2022年10月28日

Arxiv

21+阅读 · 2018年12月25日