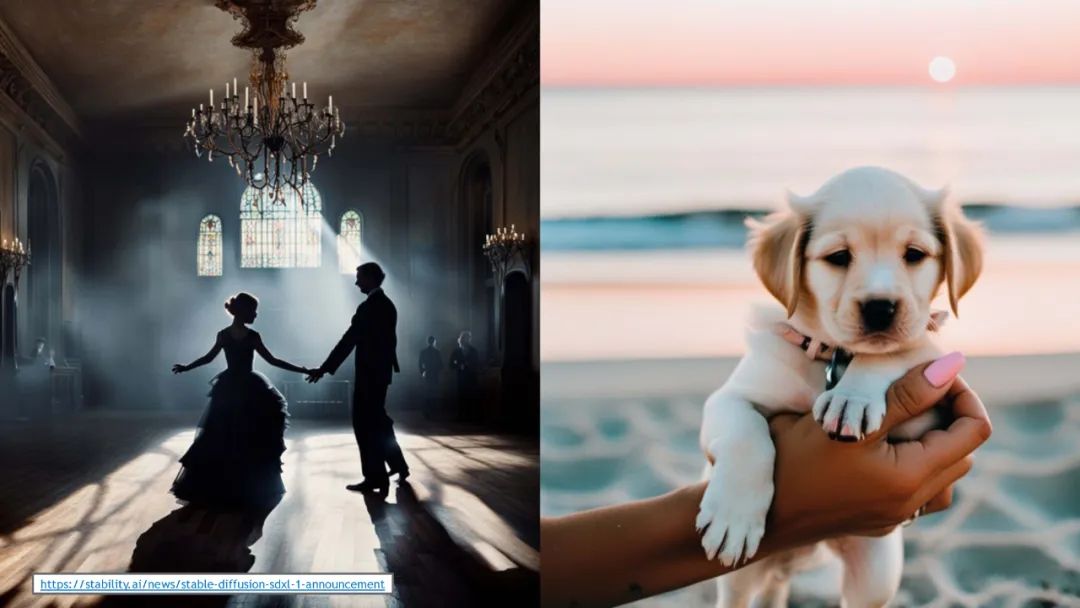

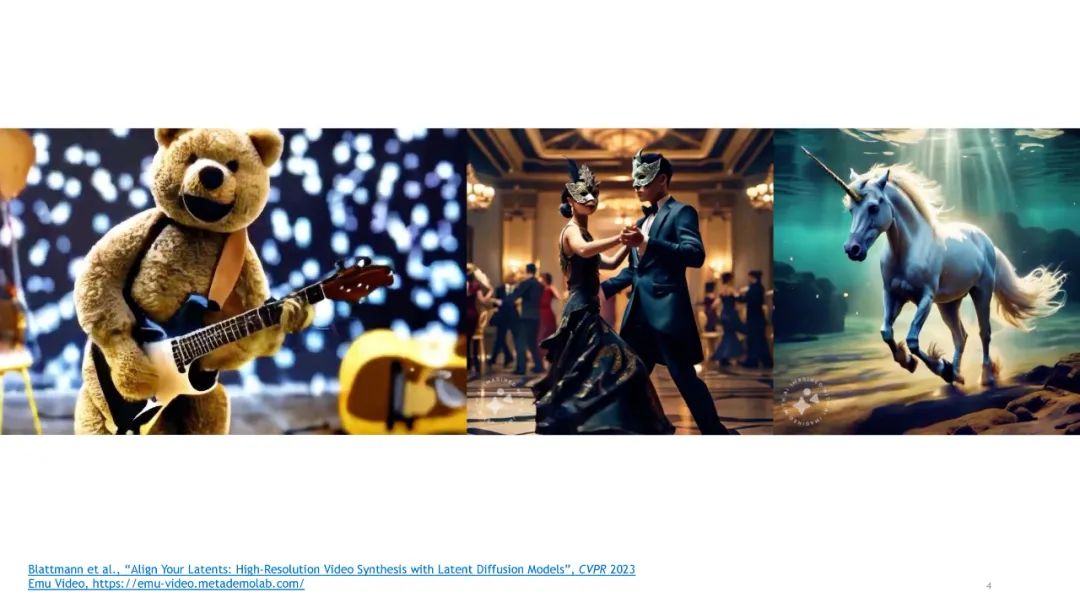

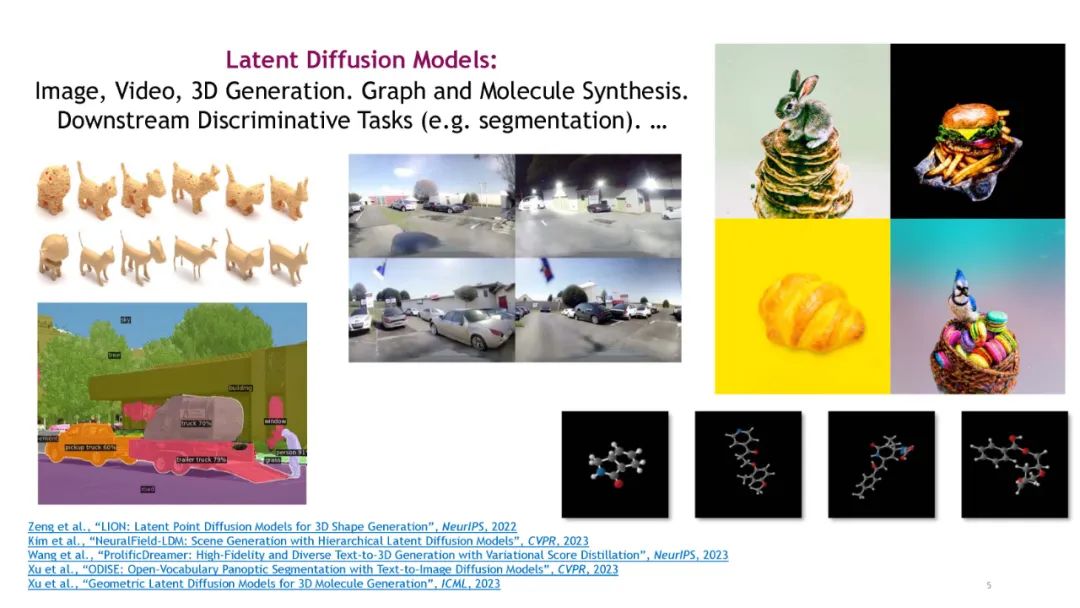

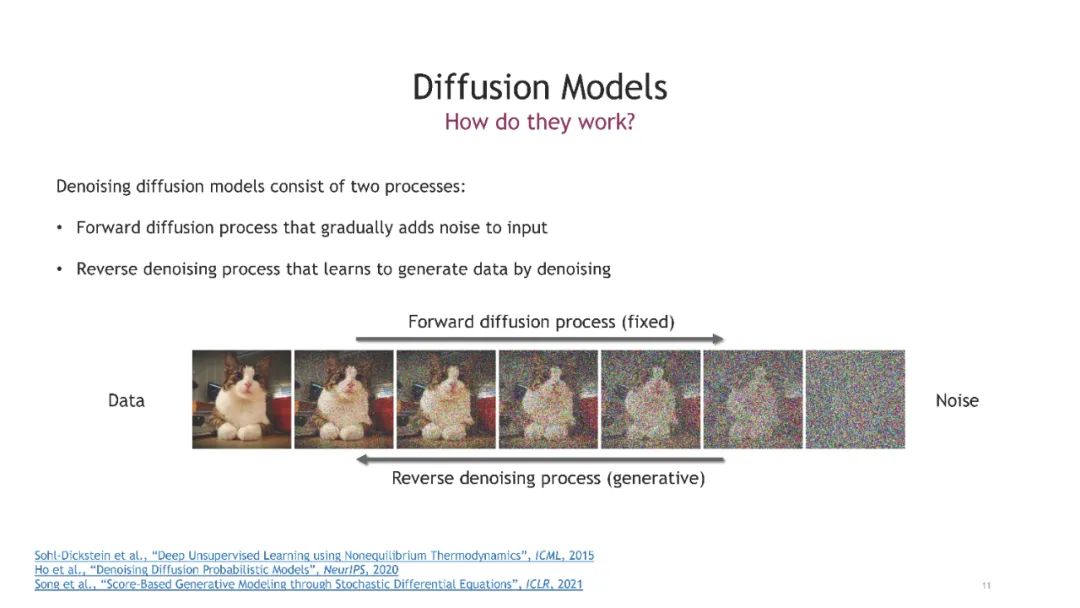

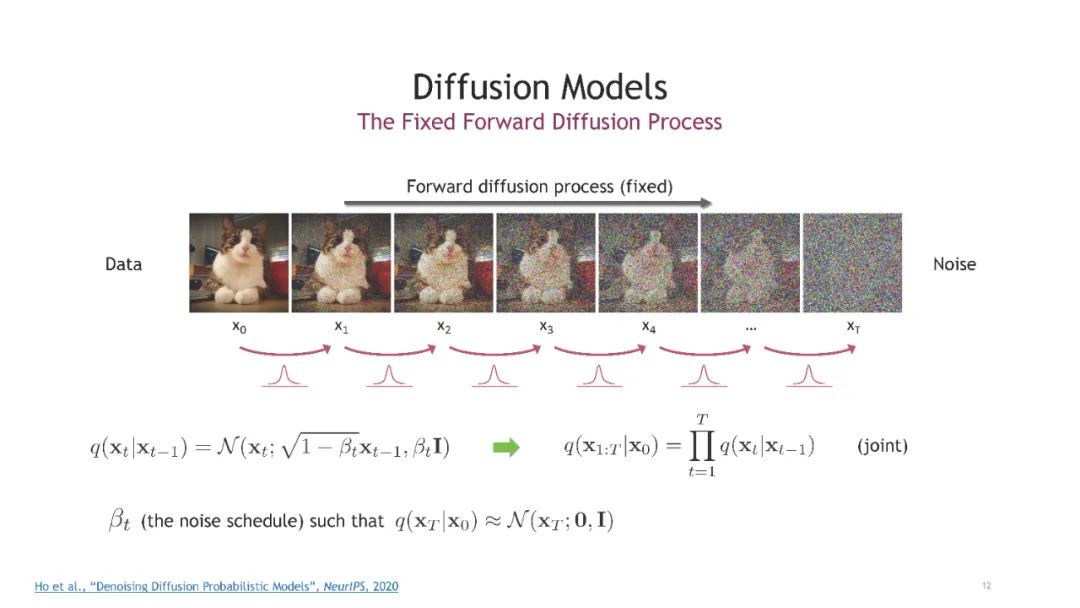

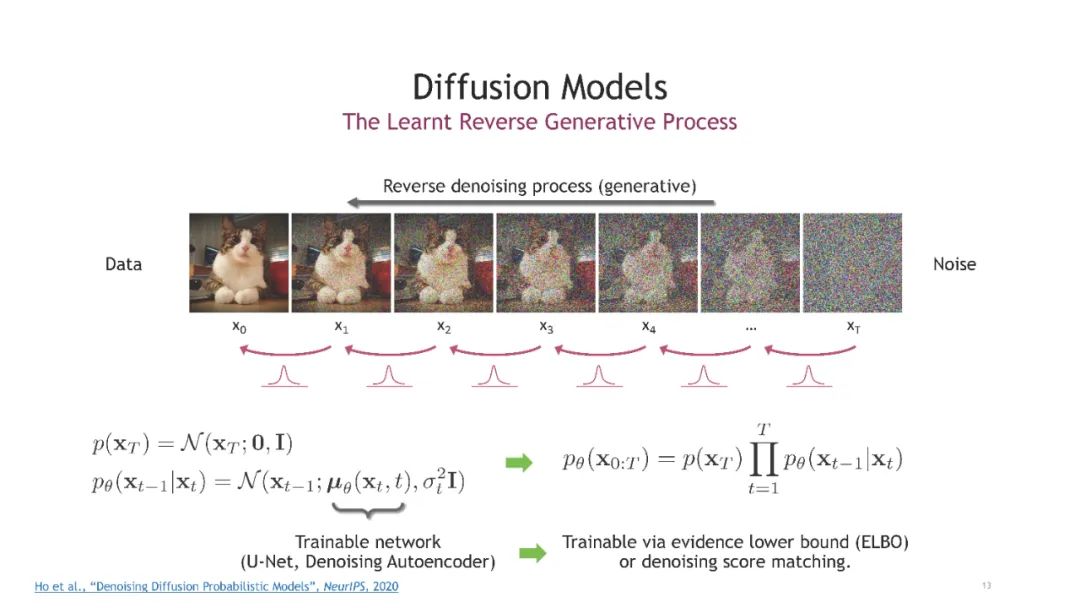

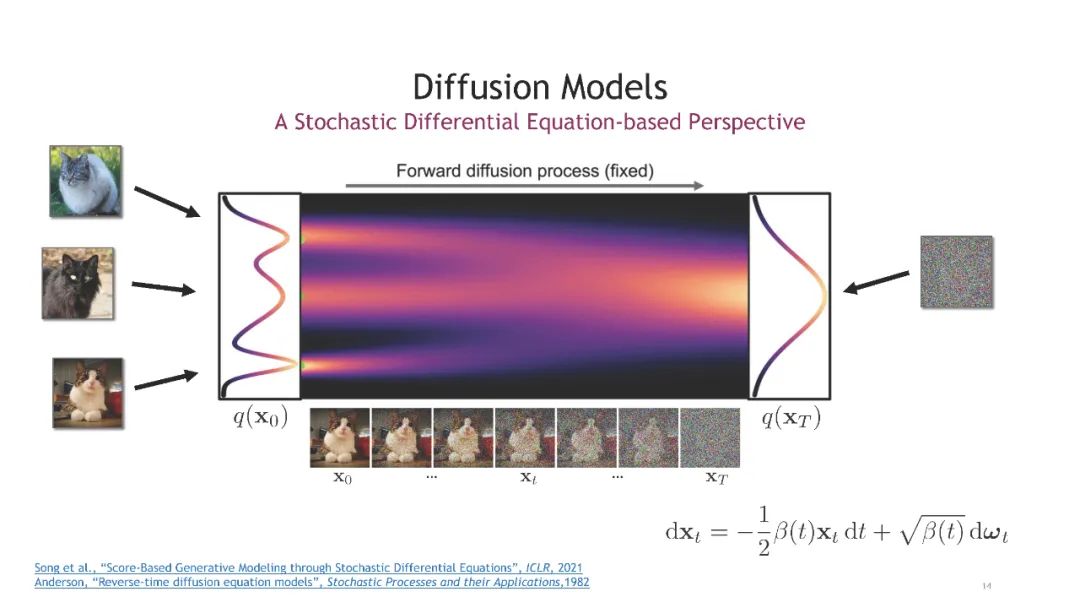

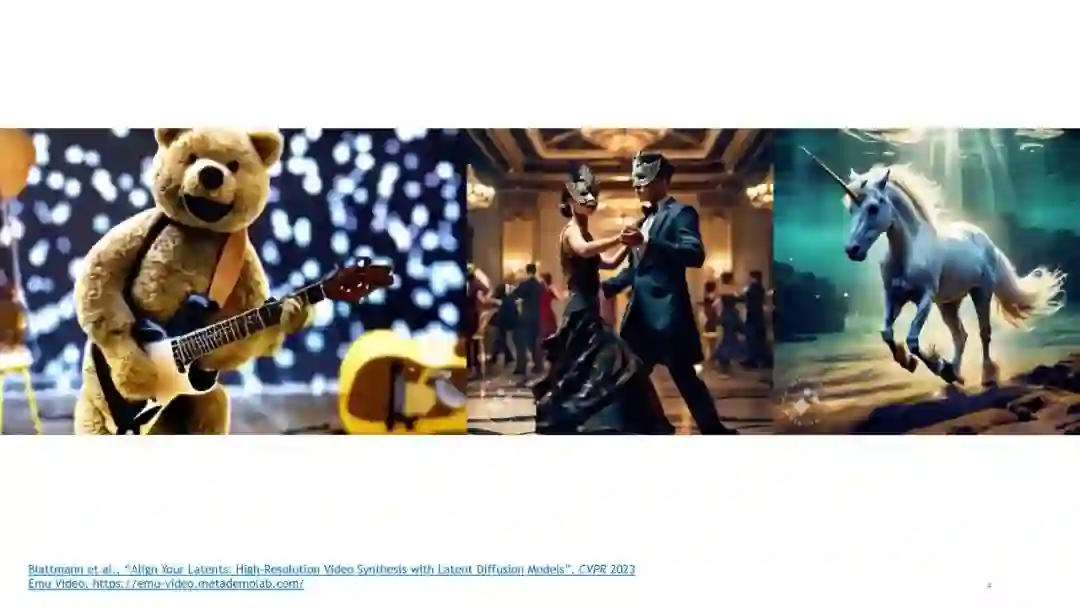

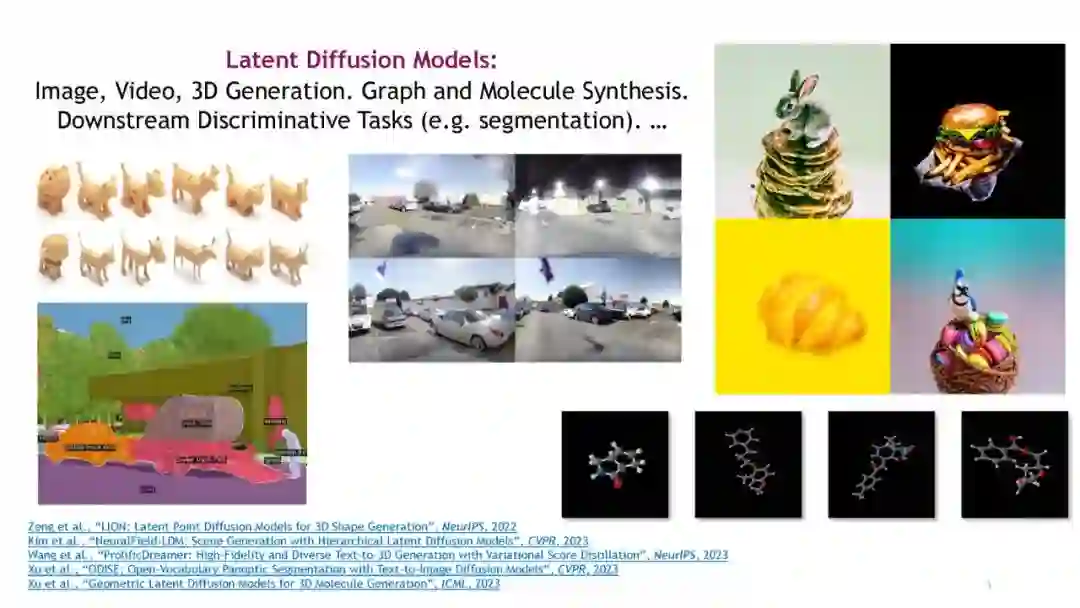

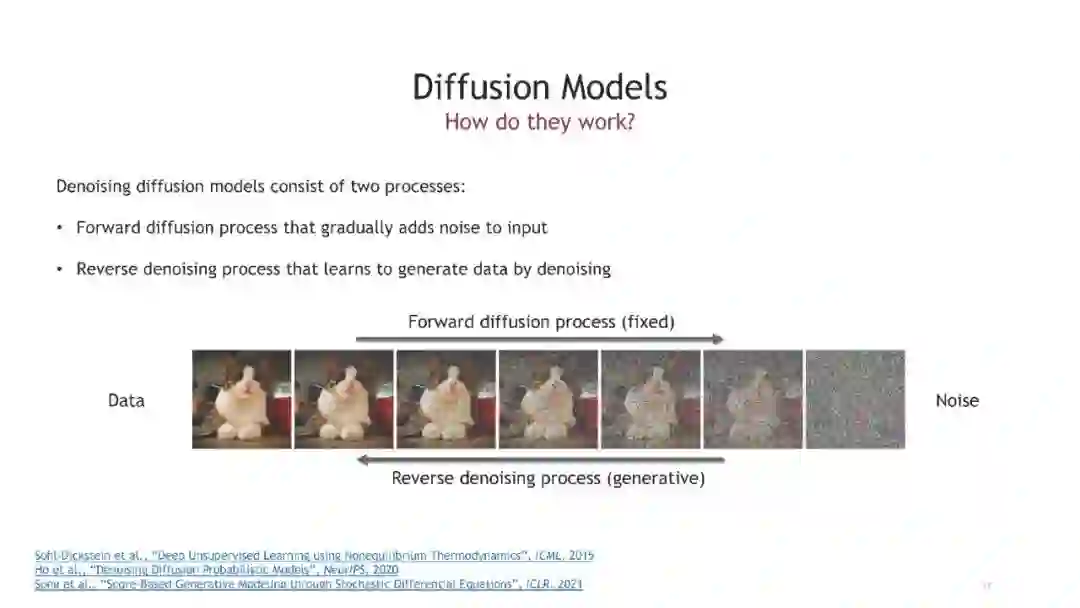

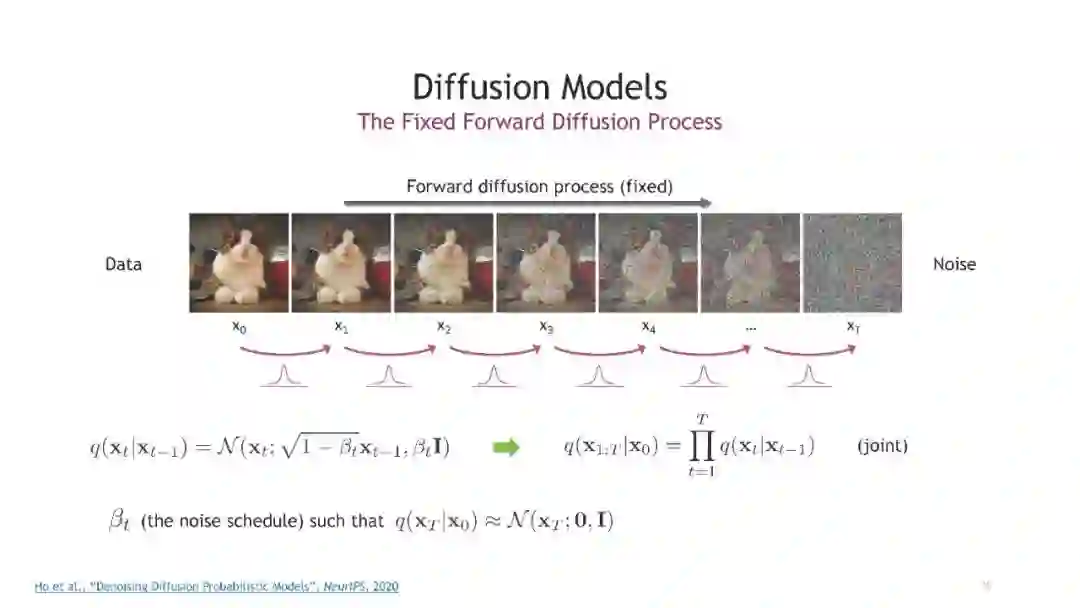

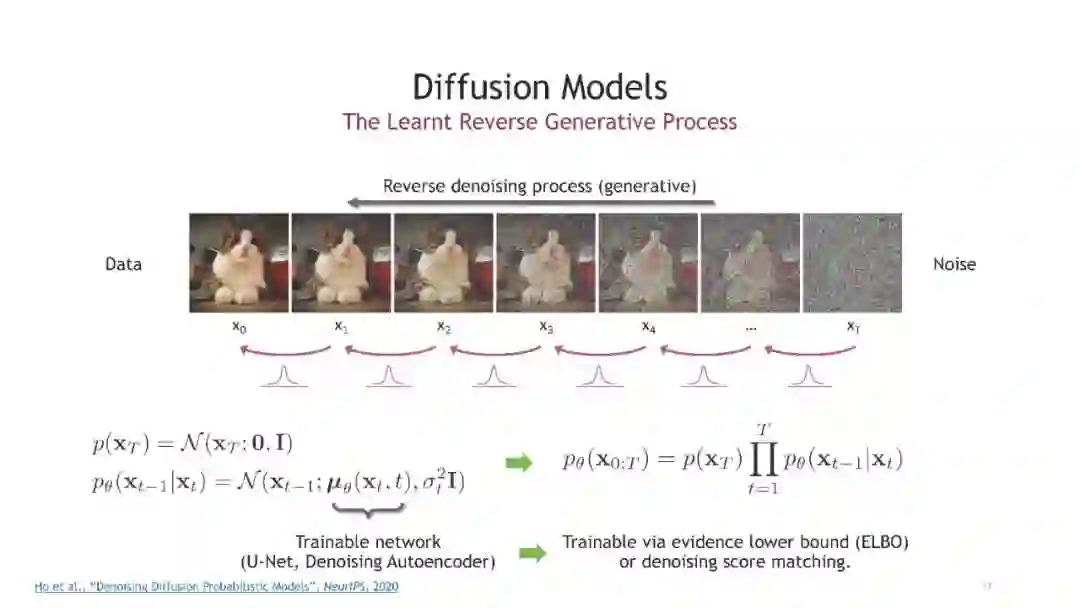

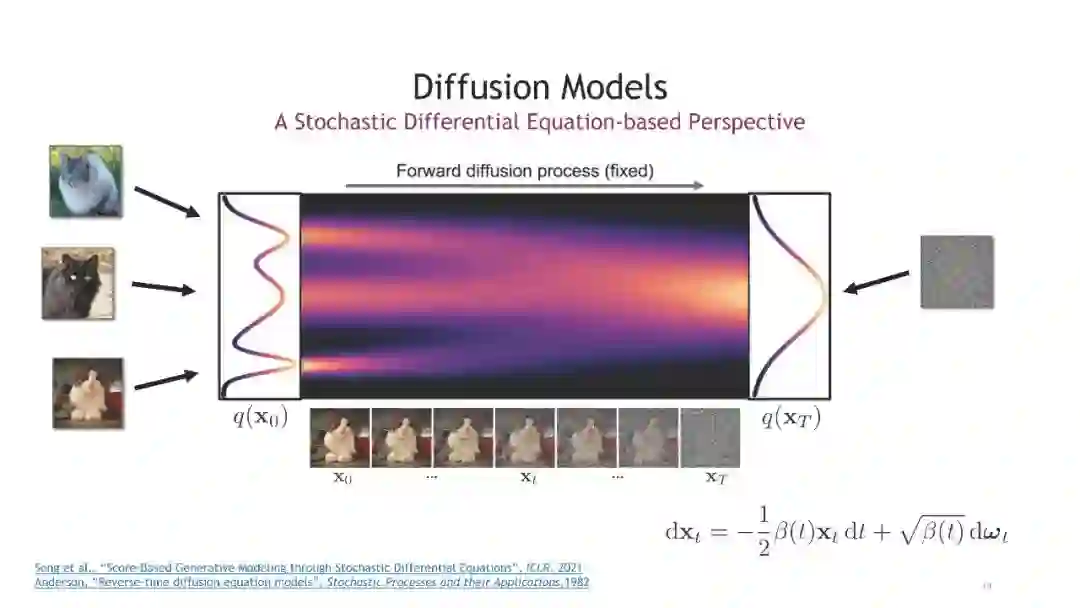

潜在扩散模型(LDMs)作为一类强大的生成模型,已在图像合成等领域展示了惊人的成果。然而,训练高分辨率的扩散模型在像素空间可能极其昂贵。为克服这些限制,潜在扩散模型首先使用自编码器将高分辨率数据映射到一个压缩的、通常是低维的潜在空间,然后在该潜在空间中更高效地训练扩散模型。因此,LDMs在避免过度计算需求的同时实现了高质量图像合成。此外,具有自编码器的LDM范式,可针对特定问题和数据进行定制,并在潜在空间中使用独立的扩散模型,提供了极大的灵活性,适用于架构和模型设计。这使得LDMs能成功扩展到图像生成之外的各种任务,如视频合成、3D对象和场景生成、语言建模等。最著名的例子是文本到图像模型Stable Diffusion,它利用了LDM框架。LDMs在生成模型文献中已变得非常流行和广泛使用。

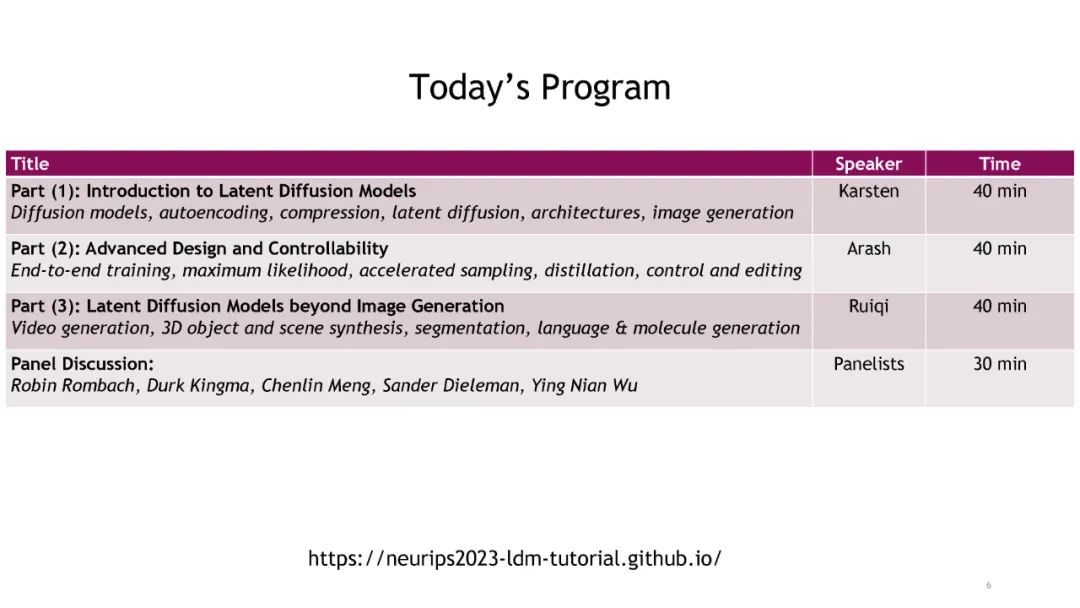

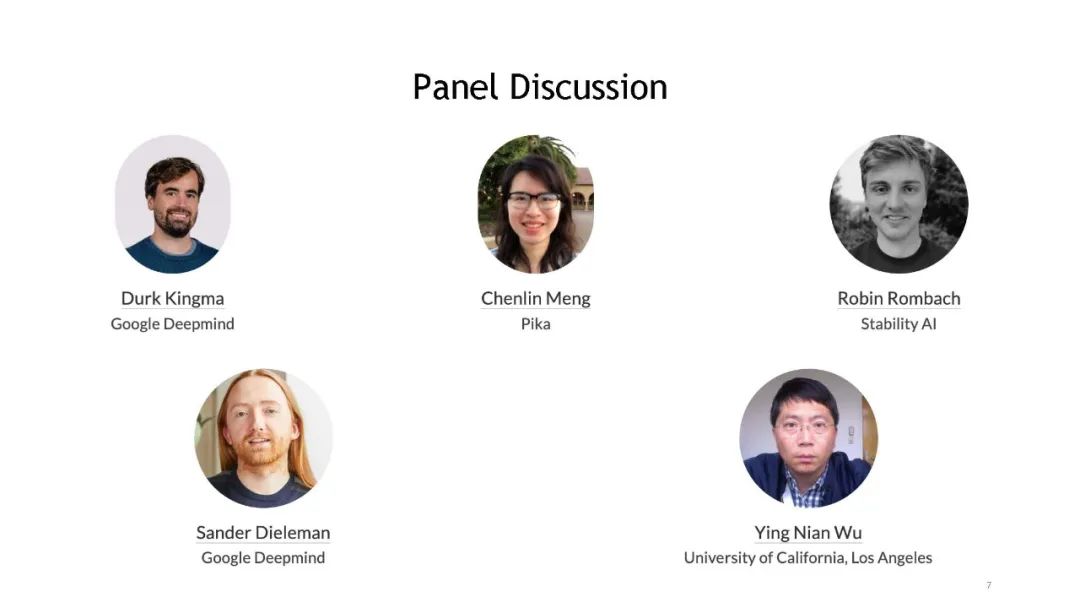

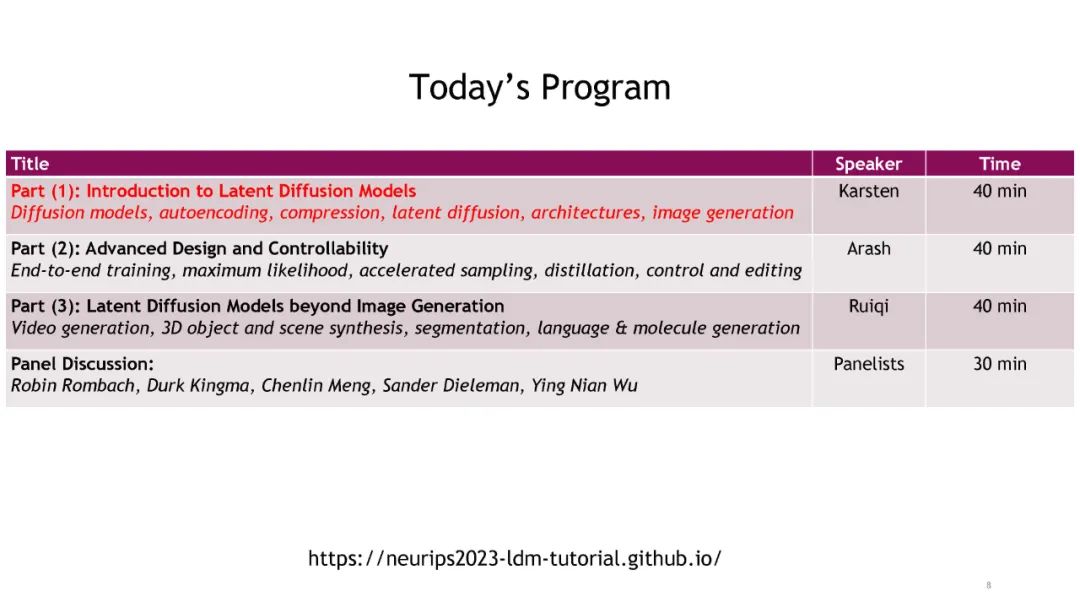

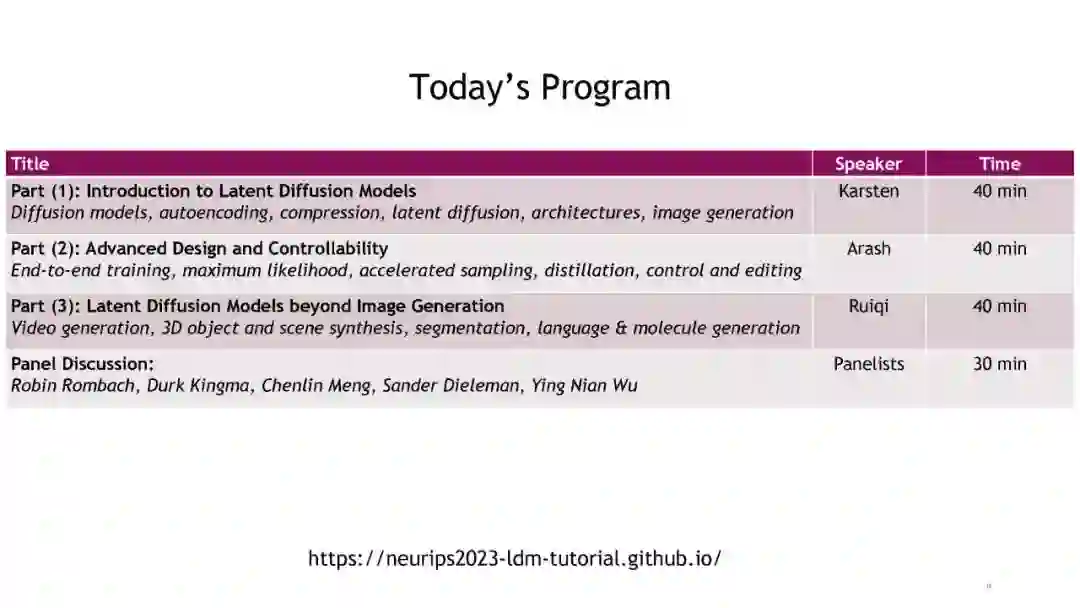

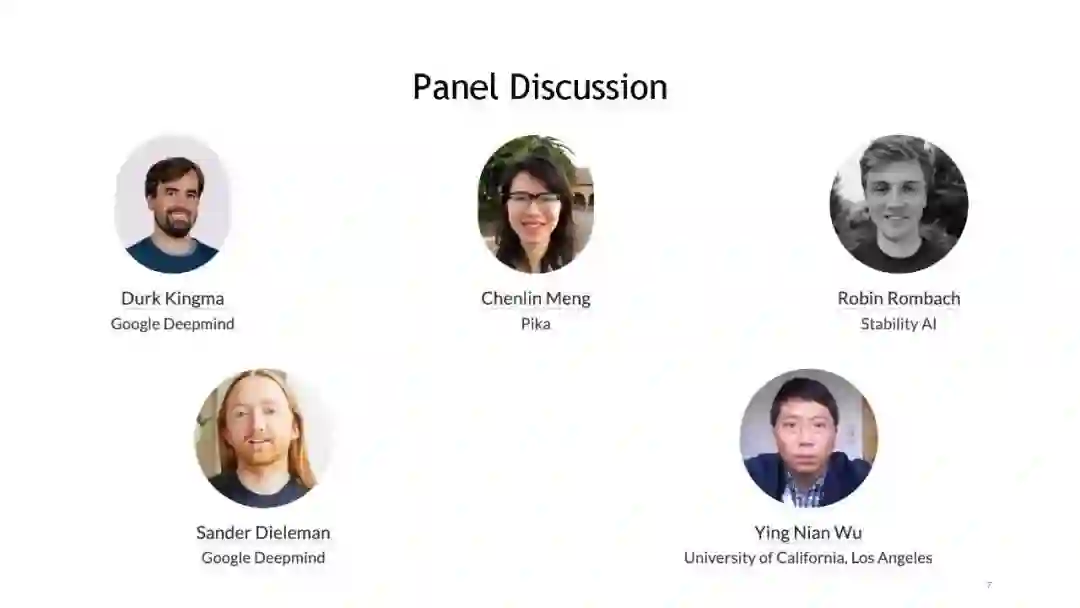

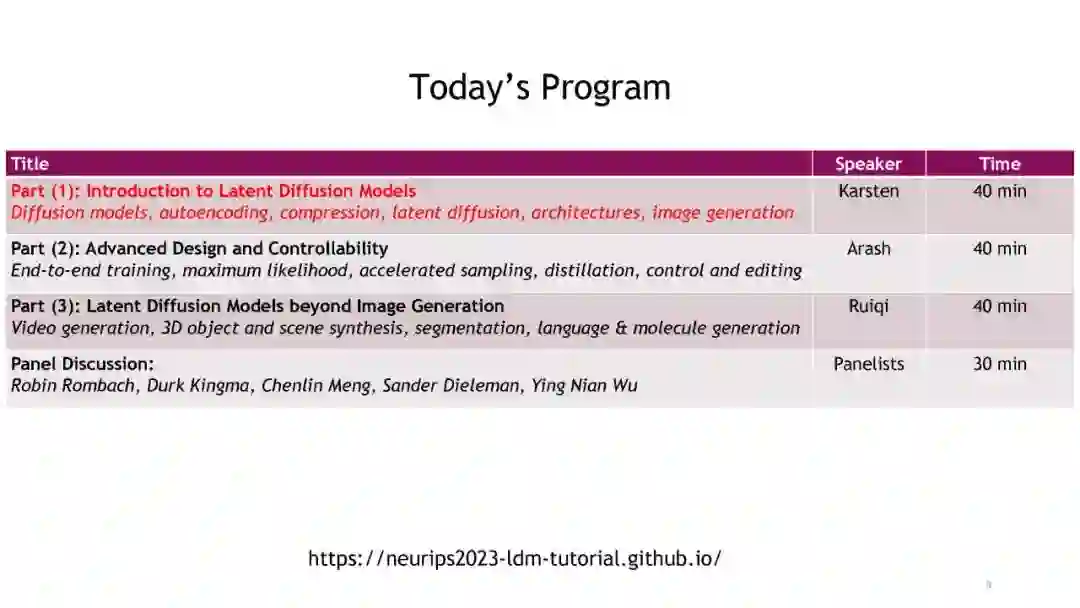

在本教程中,我们旨在提供LDMs的介绍。虽然扩散模型的文献已经很广泛,但LDM范式由于其灵活性以及在性能和计算需求之间的出色权衡而特别突出。我们的目标是呈现一个LDM教程,有助于对高效且灵活但富有表现力的生成模型框架感兴趣的研究者。我们还将强调加速采样和可控性的高级技术,并讨论LDMs在图像合成之外的各种应用。此外,一个小组讨论将提供这一动态领域的多元视角,并为未来对LDMs的研究提供展望。 本教程专注于潜在扩散模型。对于扩散模型的一般教程,我们推荐参考在CVPR'22和CVPR'23上展示的、已录制并公开可用的教程。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日