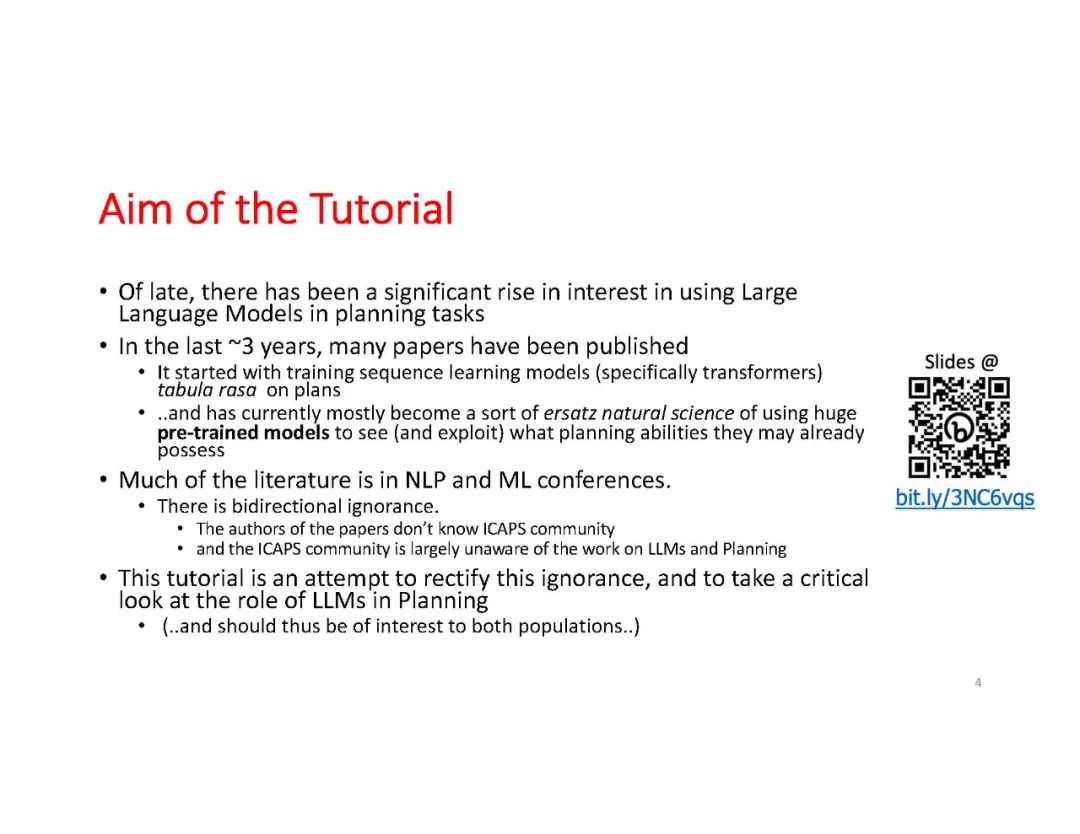

大型语言模型(LLMs,或称为类固醇版的N-gram模型),最初是为了通过在前面一串词的上下文中反复预测下一个词而进行训练的,现在已经吸引了人工智能(以及全世界)社区的关注。部分原因在于它们能够对几乎所有人类知识领域的提示生成有意义的完成句。这种极度的多功能性也引发了一种说法,即这些预测性文本补全系统可能具有抽象推理和规划的能力。在这个教程中,我们将对LLMs在规划任务中的能力进行深入探讨,无论是在自主模式还是在辅助模式中。我们特别感兴趣的是,在广泛研究的AI规划社区的问题和框架的背景下,描述这些能力(如果有的话)。

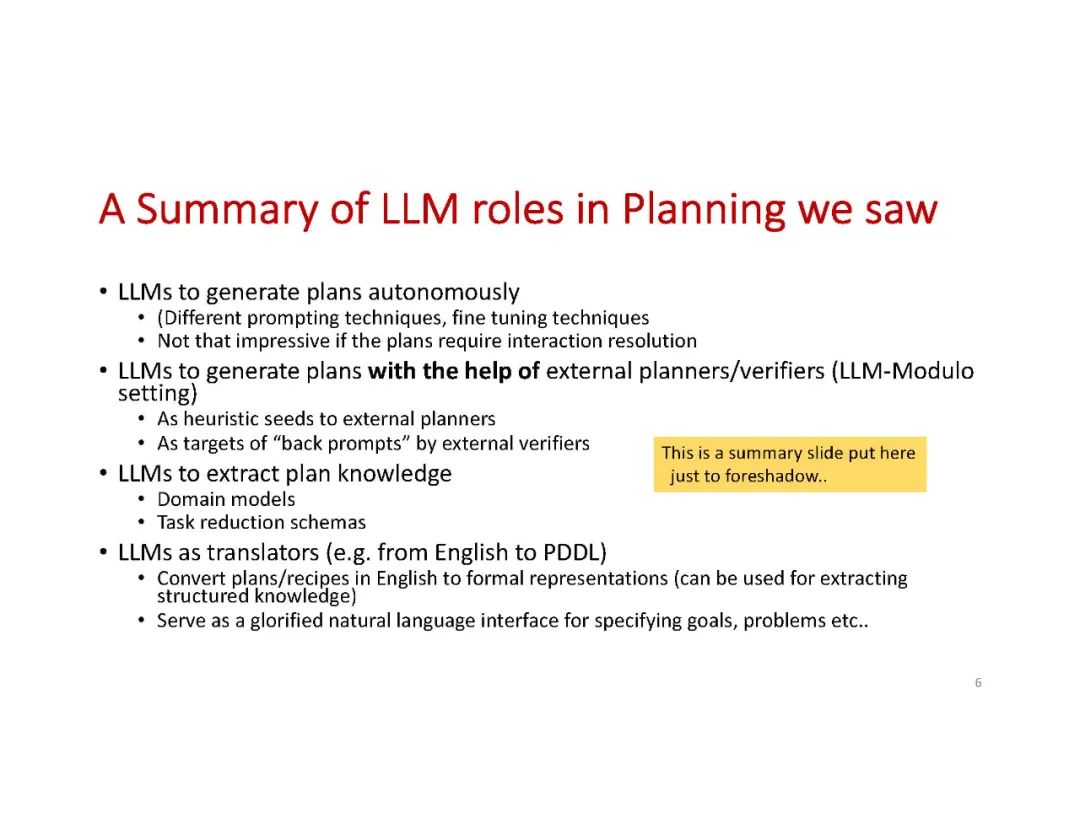

本教程将指出LLMs在生成通常需要解决子目标交互的组合搜索的计划时的基本限制,并展示LLMs作为AI规划社区开发的健全规划者的补充技术的实际应用。除了介绍我们在这个领域的工作,我们还提供了许多相关工作的批判性调查,包括来自规划社区以外的研究者的工作。

这个教程预计将涵盖的主题包括:大型语言模型的背景,以及LLM的使用模式,包括提示技术 在规划中区分使用变换器架构与预训练的LLM的方法 提及Word2vec以规划,决策变换器,我们正在进行的使用GPT2进行微调,学习验证器的工作 LLM与规划 - 自主模式 用自然语言或直接的PDDL进行提示;微调的效果;思维链提示等 LLM作为规划的启发式/想法生成器 与基于案例和轻量级规划的连接 通过提示LLM进行搜索 自动化与人工驱动的提示(以及后者的聪明汉斯问题) LLM作为模型获取技术 LLM作为支持各种类型规划的工具 不完全指定(高度分离)的目标;HTN规划;“广义规划” 在强化学习环境中使用LLM(以获得奖励,偏好)

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日