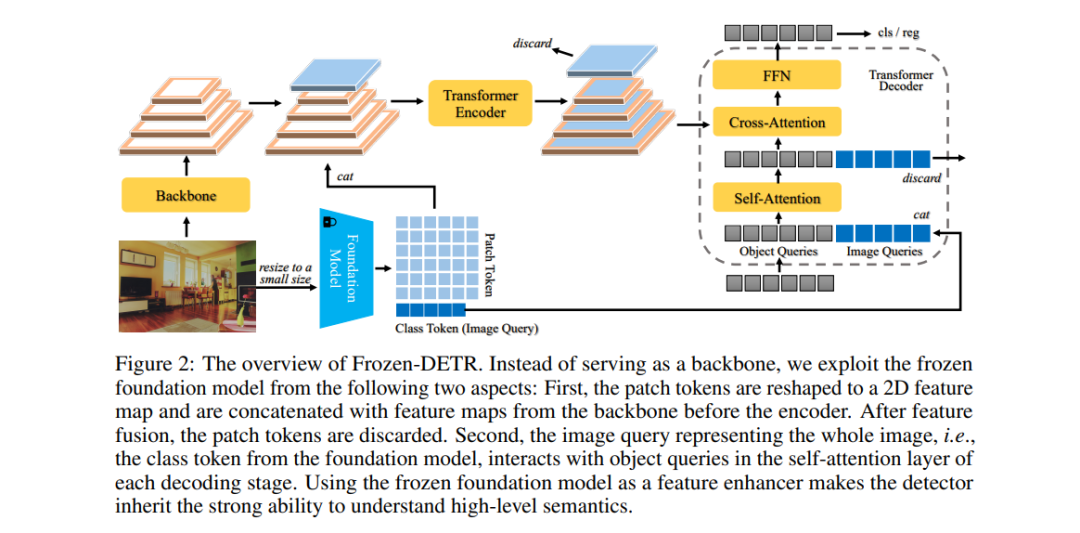

最近的视觉基础模型能够提取通用表征,并在各种任务中表现出强大的能力。然而,它们在目标检测中的应用尚未得到充分重视,尤其是在不对其进行微调的情况下。在本研究中,我们展示了即使没有为目标检测预训练的冻结基础模型也可以成为多功能的特征增强器。具体而言,我们探索了将基础模型的高级图像理解能力直接转移到检测器中的两种方式。首先,基础模型中的类别token提供了对复杂场景的深入理解,这可以通过提供紧凑的上下文来帮助检测器解码器中的对象查询解码。此外,基础模型中的patch tokens能够提供语义细节,从而丰富检测器编码器中的特征。将冻结的基础模型作为即插即用模块,而非常用的骨干网络,不仅显著提升了检测器的性能,还有效避免了检测器骨干网络与基础模型之间的架构差异所导致的问题。在这种创新范式下,我们将SOTA查询式检测器DINO的AP从49.0%提升到51.9%(+2.9% AP),并通过集成一个或两个基础模型,进一步提升到53.8% AP(+4.8% AP),该实验在COCO验证集上进行,检测器的骨干网络为R50,训练周期为12个epochs。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日