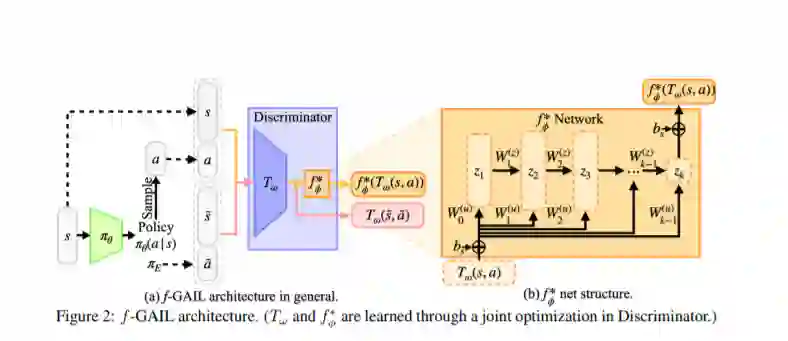

模仿学习(IL)旨在从专家演示中学习一种策略,使学习者和专家行为之间的差异最小化。针对预先确定的差异,提出了不同的模仿学习算法来量化差异。这自然会产生以下问题:给定一组专家演示,哪些分歧可以在更高的数据效率下更准确地恢复专家策略?在这项研究中,我们提出了一种新的生成性对抗模仿学习(GAIL)模型——f-GAIL,它可以自动地从f-divergence族中学习出一个差异度量,并且能够产生与专家相似行为的策略。与具有各种预定义散度度量的IL基线相比,f-GAIL在6个基于物理的控制任务中学习了更好的策略和更高的数据效率。

https://arxiv.org/abs/2010.01207

成为VIP会员查看完整内容

相关内容

模仿学习是学习尝试模仿专家行为从而获取最佳性能的一系列任务。目前主流方法包括监督式模仿学习、随机混合迭代学习和数据聚合模拟学习等方法。模仿学习(Imitation Learning)背后的原理是是通过隐含地给学习器关于这个世界的先验信息,比如执行、学习人类行为。在模仿学习任务中,智能体(agent)为了学习到策略从而尽可能像人类专家那样执行一种行为,它会寻找一种最佳的方式来使用由该专家示范的训练集(输入-输出对)。当智能体学习人类行为时,虽然我们也需要使用模仿学习,但实时的行为模拟成本会非常高。与之相反,吴恩达提出的学徒学习(Apprenticeship learning)执行的是存粹的贪婪/利用(exploitative)策略,并使用强化学习方法遍历所有的(状态和行为)轨迹(trajectories)来学习近优化策略。它需要极难的计略(maneuvers),而且几乎不可能从未观察到的状态还原。模仿学习能够处理这些未探索到的状态,所以可为自动驾驶这样的许多任务提供更可靠的通用框架。

专知会员服务

24+阅读 · 2019年11月11日

Arxiv

4+阅读 · 2019年5月24日

Arxiv

4+阅读 · 2017年12月30日