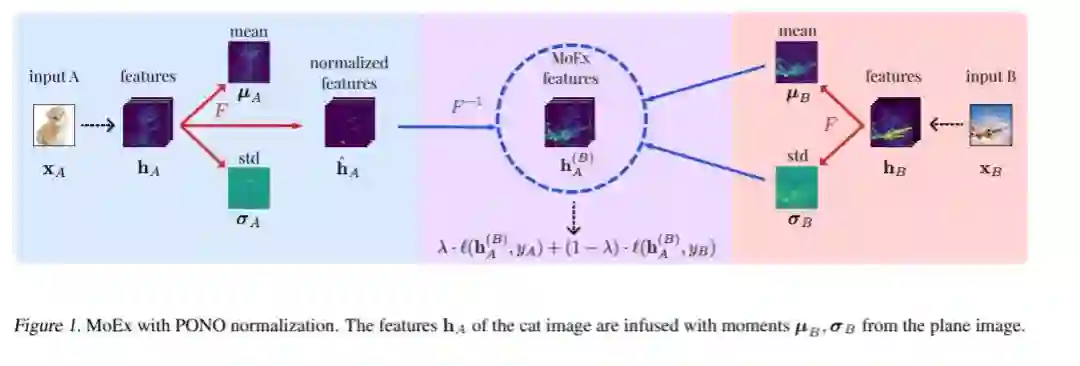

现代神经网络训练在很大程度上依赖于数据的增强来提高泛化能力。在保持标记的扩展最初获得成功之后,最近出现了对标记扰动方法的兴趣激增,这种方法将训练样本中的特征和标记结合起来,以平滑所学习的决策表面。在本文中,我们提出了一种新的增强方法,利用特征归一化提取并重新注入第一和第二矩。我们将一个训练图像的学习特征的矩替换为另一个训练图像的学习特征的矩,并对目标标签进行插值。由于我们的方法速度快,完全在特征空间中操作,并且与以前的方法相比混合了不同的信号,因此可以有效地将其与现有的增强方法相结合。我们在计算机视觉、语音和自然语言处理的基准数据集上演示了它的有效性,在这些基准数据集上,它不断地提高了高度竞争的基线网络的泛化性能。

成为VIP会员查看完整内容

相关内容

专知会员服务

44+阅读 · 2020年6月29日

专知会员服务

51+阅读 · 2020年3月31日

专知会员服务

87+阅读 · 2020年3月1日

Arxiv

7+阅读 · 2018年1月28日