图神经网络

·

原文地址:https://arxiv.org/abs/2006.05057

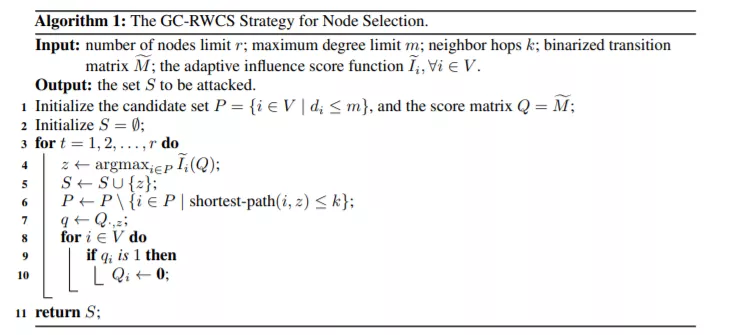

我们研究在一种新颖实际的设定下对图神经网络的黑盒攻击,我们限制攻击者只能获得部分节点的信息并且只能修改其中小部分的节点。在这样的设定下,如何选择节点变得愈发重要。我们证明图神经网络的结构归纳偏差能成为有效的黑盒攻击源头。具体来说,通过利用图神经网路的向后传播与随机游走之间的联系,我们表明基于梯度的常见白盒攻击可以通过梯度和与PageRank类似的重要性分数之间的联系而推广到黑盒攻击。在实践中,我们发现基于这个重要性分数上确实很大的程度地增加了损失值,但是不能显著提高分类错误的比率。我们的理论和经验分析表明,损失值和误分类率之间存在差异,即当受攻击的节点数增加时,后者会呈现递减的回报模式。因此,考虑到收益递减效应,我们提出了一种贪心算法来校正这一重要性得分。实验结果表明,所提出的选点程序在无需访问模型参数或预测的前提下可以显著提高常用数据集上常见GNN的误分类率。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2020年12月3日

Arxiv

0+阅读 · 2020年12月2日

Arxiv

0+阅读 · 2020年11月27日