题目: Context-Transformer: Tackling Object Confusion for Few-Shot Detection

摘要:

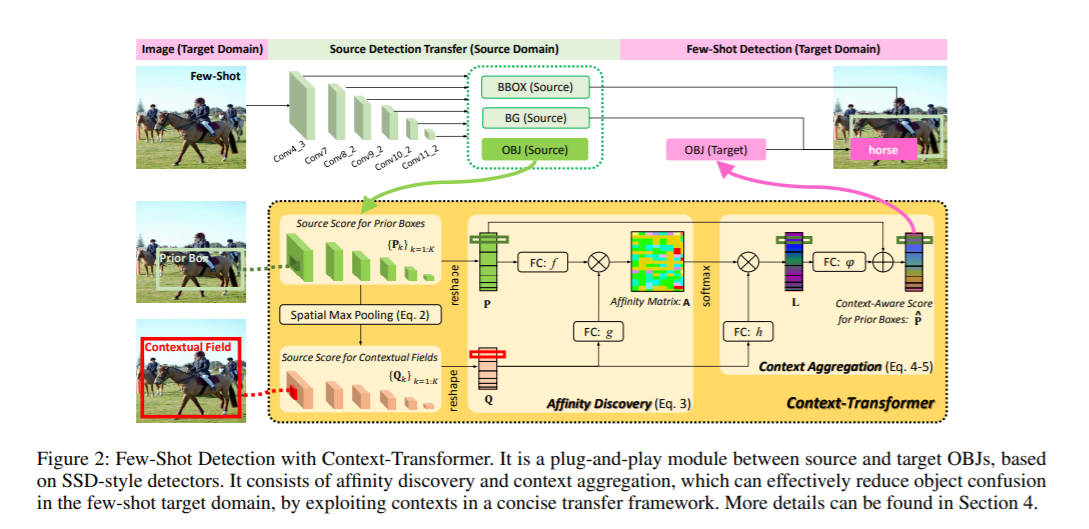

小样本目标检测是一个具有挑战性但又很现实的场景,只有少数带注释的训练图像可用于训练检测器。处理这个问题的一个流行的方法是迁移学习,对在源域基准上预先训练的检测器进行微调。然而,由于训练样本的数据多样性较低,这种转移的检测器往往不能识别目标域中的新对象。为了解决这一问题,我们提出了一个新颖的上下文转换器:一个简洁的深层传输框架。具体来说,Context-Transformer可以有效地利用源域对象知识作为指导,并自动地从目标域中的少量训练图像中挖掘上下文。然后,自适应地整合这些相关线索,增强检测器的识别能力,以减少在小样本场景下的目标混淆。此外,上下文转换器灵活地嵌入到流行的ssd风格的检测器中,这使得它成为端到端小样本学习的即插即用模块。最后,我们评估了上下文转换器对小样本检测和增量小样本检测的挑战性设置。实验结果表明,我们的框架比目前最先进的方法有更好的性能。

成为VIP会员查看完整内容

相关内容

迁移学习(Transfer Learning)是一种机器学习方法,是把一个领域(即源领域)的知识,迁移到另外一个领域(即目标领域),使得目标领域能够取得更好的学习效果。迁移学习(TL)是机器学习(ML)中的一个研究问题,着重于存储在解决一个问题时获得的知识并将其应用于另一个但相关的问题。例如,在学习识别汽车时获得的知识可以在尝试识别卡车时应用。尽管这两个领域之间的正式联系是有限的,但这一领域的研究与心理学文献关于学习转移的悠久历史有关。从实践的角度来看,为学习新任务而重用或转移先前学习的任务中的信息可能会显着提高强化学习代理的样本效率。

专知会员服务

38+阅读 · 2020年3月23日

专知会员服务

39+阅读 · 2020年3月19日