AAAI 是由国际人工智能促进协会主办的年会,是人工智能领域中历史最悠久、涵盖内容最广泛的国际顶级学术会议之一,也是中国计算机学会(CCF)推荐的 A 类国际学术会议,在人工智能领域享有较高的学术声誉。2024年,AAAI主办地为加拿大温哥华,录用文章2342篇,录用率为23.75%。

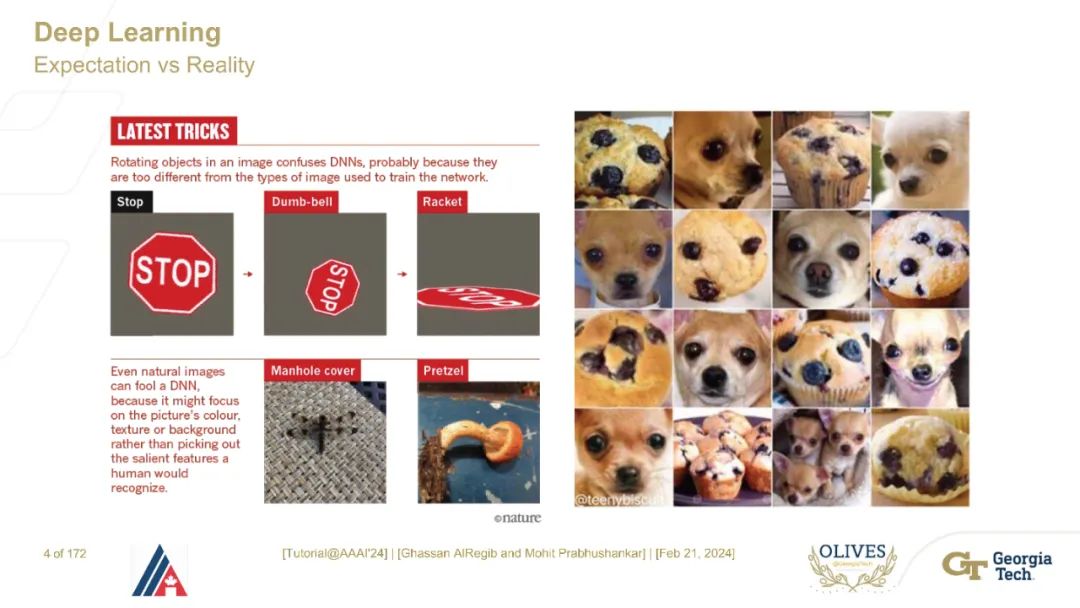

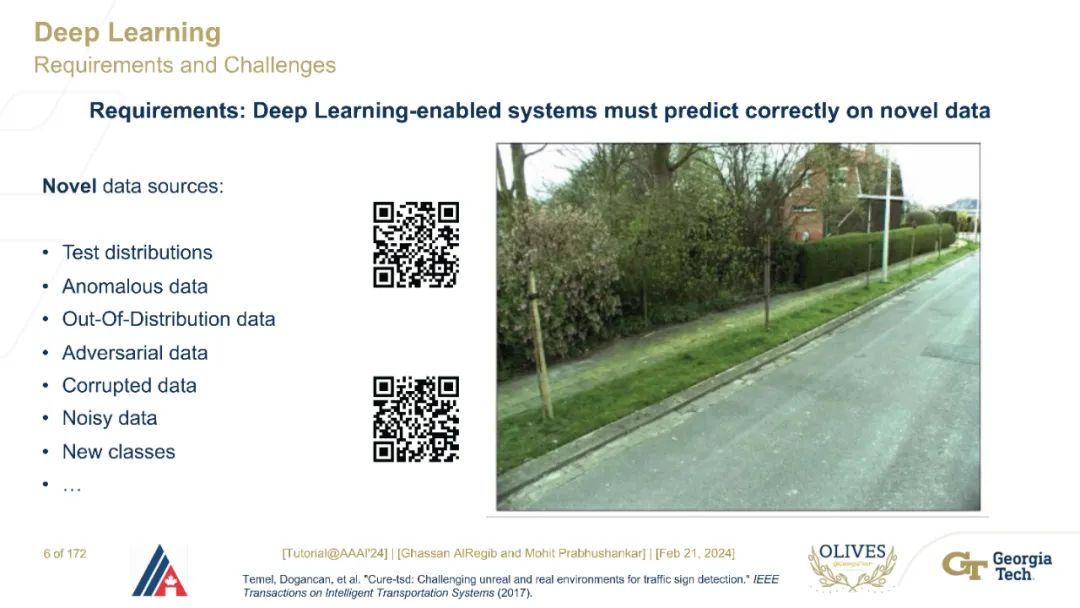

深度学习在提供大数据访问的多个领域展现了高度的适用性。随着基于深度学习的人工智能系统从学术界过渡到日常生活,必须在公众接受之前理解它们的脆弱性。一个关键的脆弱性是对神经网络操作极限的知识缺乏。这种脆弱性被视为神经网络中的鲁棒性不足。在过去,为研究社区服务的简单鲁棒性测量包括输入噪声分析和超出分布的识别。然而,拥有数十亿参数的大型视觉模型对其他工程化和对抗性噪声以及对其预测概率的未校准也很脆弱。最近,允许用户在推理阶段进行有限输入的基于提示的架构获得了突出。虽然这些提示充当干预,但它们的目标不是理解因果关系或测量鲁棒性,而是提取有限的知识。这是一个及时且相关的教程,强调了神经网络在人本测量上的鲁棒性,这有助于它们的广泛适用性。https://alregib.ece.gatech.edu/aaai-2024-tutorial/

本教程的目标有三个:1) 将现代大规模神经网络的鲁棒性分解为三个可管理的、以人为中心的测量标准,2) 以概率方式定义事后可解释性、不确定性和可干预性测量标准,以及3) 以输入、网络和输出为函数计算这三个测量标准,重点关注医疗和地震领域的实际应用。详细的子主题在下面的大纲部分提供。

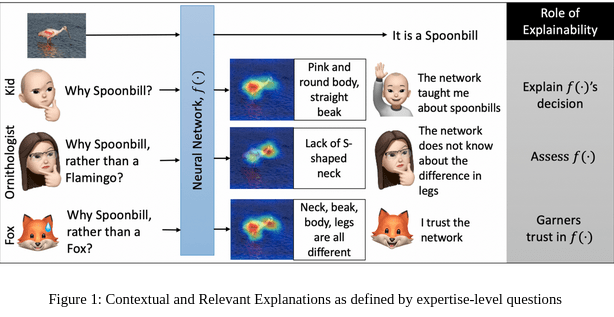

本教程由四个主要部分组成。第一部分讨论了一些关于使用超出分布(OOD)数据训练神经网络的最新令人惊讶的结果,其结论是,在训练期间何时以及如何使用OOD数据并不总是清楚的。这激发了在推理时对鲁棒性进行正式和以人为中心的测量的需求。第二部分介绍了可解释性、不确定性和可干预性每一个的基本数学框架。我们考虑它们之间的关系,并显示对预测不确定性的方差分解的干预是用于可解释性的评估测量。第三部分阐述了在视网膜和地震图像分析的实际应用中可解释性与不确定性之间的关系。第四部分讨论了以不确定性为功能的可干预性,以提示和非因果干预的情况为例。具体而言,讨论了地震领域中的干预不确定性分析。神经网络提供了广泛适用于图像理解应用的可泛化和任务独立的表示空间。图像数据内特征交互的复杂语义已被分解为一组非线性函数、卷积参数、注意力以及多模态输入等。这些操作的复杂性在神经网络架构内引入了多个脆弱性。这些脆弱性包括对抗样本、置信度校准问题和灾难性遗忘等。鉴于人工智能承诺将引领第四次工业革命,理解并克服这些脆弱性至关重要。这需要创建鲁棒的神经网络来驱动人工智能系统。然而,定义鲁棒性并非易事。在现实生活设置中不适用的简单噪声和扰动不变性的测量。在本教程中,我们提供了一种以人为中心的方法来理解允许人工智能在社会中功能的神经网络的鲁棒性。这样做允许我们声明以下内容:1) 所有神经网络必须装备提供给人类的上下文相关解释,2) 神经网络必须知道它们不知道的时间和内容,3) 神经网络必须装备有在其决策过程的任何阶段被人类干预的能力。这三个声明要求鲁棒的神经网络是可解释的,配备了不确定性量化,并且可以干预。我们提供了可解释性、不确定性和可干预性的概率事后分析。事后意味着决策已经做出。一个简单的事后上下文相关解释的示例显示在图1中。给定一个训练有素的神经网络,常规解释回答“为什么是琵鹭?”的问题,通过突出鸟的身体。然而,一个更相关的问题可能是“为什么是琵鹭,而不是火烈鸟?”。这样的问题要求提问者意识到火烈鸟的特征。如果网络显示差异在于缺乏S形颈部,那么提问者将对提供的上下文答案感到满意。上下文解释建立了信任,并且除了解释决策之外还评估了神经网络。在更大的背景下,可解释性的目标必须是满足各种专业水平的多个利益相关者。这包括研究人员、工程师、政策制定者和日常用户等。在本教程中,我们阐述了一种梯度基方法,它提供了上述所有解释,而不需要任何重新训练。一旦神经网络被训练,它就充当一个知识库,通过它可以使用不同类型的梯度来遍历对抗性、对比性、解释性、反事实表示空间。除了解释,我们展示了这些梯度定义不确定性和可干预性的实用性。将讨论包括异常、新奇性、对抗性和超出分布图像检测、图像质量评估和噪声识别实验等在内的多个图像理解和鲁棒性应用。在本教程中,我们检查了作为大规模神经网络实用性的以人为中心的鲁棒性的类型、视觉含义和解释。

参考文献:

- AlRegib, Ghassan, and Mohit Prabhushankar. “Explanatory Paradigms in Neural Networks: Towards relevant and contextual explanations.” IEEE Signal Processing Magazine 39.4 (2022): 59-72.

- M. Prabhushankar, and G. AlRegib, “Introspective Learning : A Two-Stage Approach for Inference in Neural Networks,” in Advances in Neural Information Processing Systems (NeurIPS), New Orleans, LA,, Nov. 29 – Dec. 1 2022.

- J. Lee, M. Prabhushankar, and G. AlRegib, “Gradient-Based Adversarial and Out-of-Distribution Detection,” in International Conference on Machine Learning (ICML) Workshop on New Frontiers in Adversarial Machine Learning, Baltimore, MD, Jul. 2022.

- M. Prabhushankar and G. AlRegib, “Extracting Causal Visual Features for Limited Label Classification,” IEEE International Conference on Image Processing (ICIP), Anchorage, AK, Sept 2021.

- J. Lee and G. AlRegib, “Open-Set Recognition with Gradient-Based Representations,” IEEE International Conference on Image Processing (ICIP), Anchorage, AK, submitted on Jan. 18 2021.