AAAI 是由国际人工智能促进协会主办的年会,是人工智能领域中历史最悠久、涵盖内容最广泛的国际顶级学术会议之一,也是中国计算机学会(CCF)推荐的 A 类国际学术会议,在人工智能领域享有较高的学术声誉。2024年,AAAI主办地为加拿大温哥华,录用文章2342篇,录用率为23.75%。

教程目标

本教程代表一个显著成就,因为它提供了一个全面概述,专为大规模图上的机器学习设计的技术,包括理论基础和实际应用。它深入探讨了旨在提高图神经网络(GNNs)可扩展性的过去和最近的研究努力,并探索了它们的多样化潜在用例。这个教程面向广泛的受众,包括工程师、研究人员、研究生和渴望利用可扩展的GNNs处理大规模数据集的行业专业人士。教程后,受众预期将学习到经典和新颖模型框架的基础理论以及它们的应用。 摘要

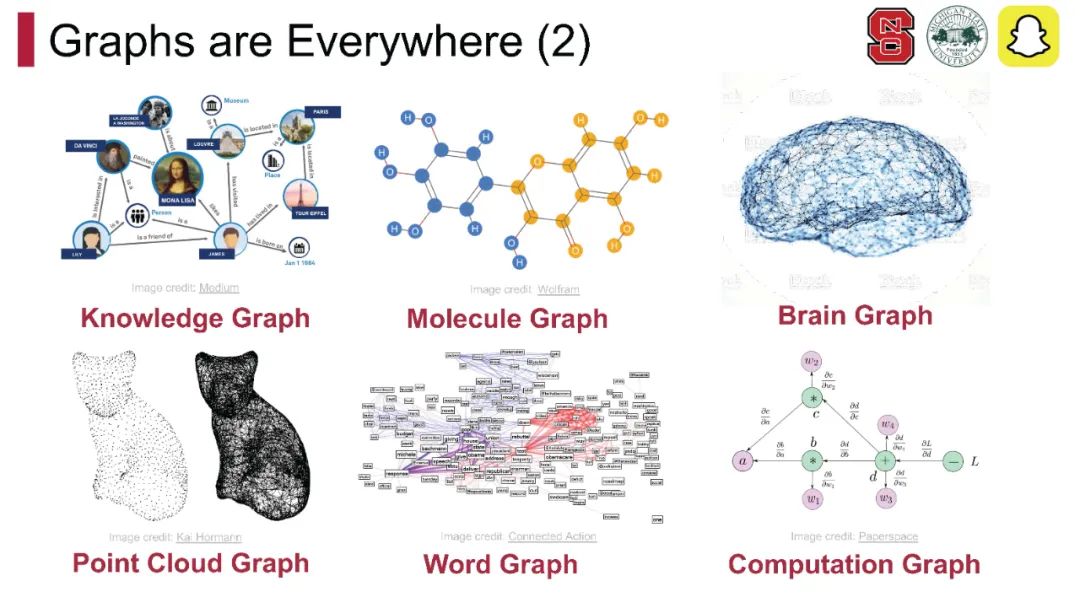

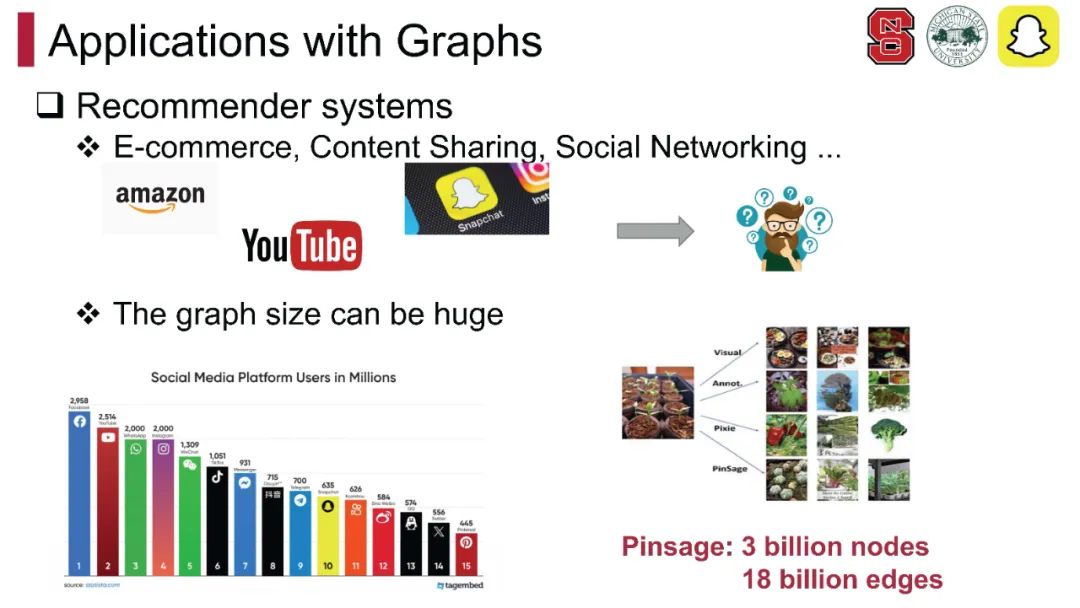

近年来,图神经网络(GNNs)由于能够模拟社交网络、蛋白质结构和知识图谱等图结构数据中实体之间的复杂关系而获得了显著关注。然而,由于现实世界工业图的大小和GNNs的特殊架构,工程师和研究人员在大规模图上部署GNNs一直是一个长期的挑战,这在很大程度上限制了它们在现实世界应用中的应用。在这个教程中,我们将覆盖GNNs的基本可扩展性挑战、大规模GNNs的前沿,包括经典方法和一些新兴技术、可扩展GNNs的评估和比较,以及它们的大规模现实世界应用。总的来说,本教程旨在提供一个系统全面的理解,关于扩展GNNs的挑战和最新技术。对未来方向的总结和讨论将激励工程师和研究人员在这个迅速发展的领域探索新的想法和发展。

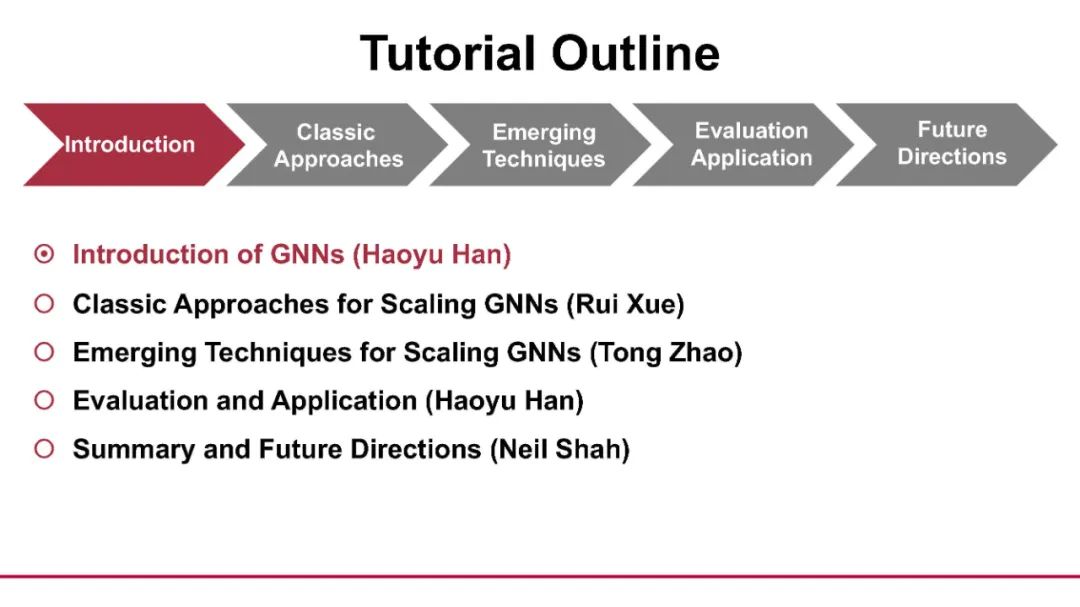

- GNNs介绍(30分钟)(a) GNNs的基础(b) GNNs的应用(c) 大规模GNNs的可扩展性挑战

- 扩展GNNs的经典方法(60分钟)(a) 采样方法(b) 解耦方法(c) 分布式方法休息:30分钟

- 扩展GNNs的新兴技术(60分钟)训练:(a) 懒惰传播(b) 交替训练(c) GNN预训练推理:跨模型蒸馏数据:(a) 图压缩(b) 子图草图(c) 表格化

- 评估、比较和应用(20分钟)

- 总结和未来方向(10分钟)

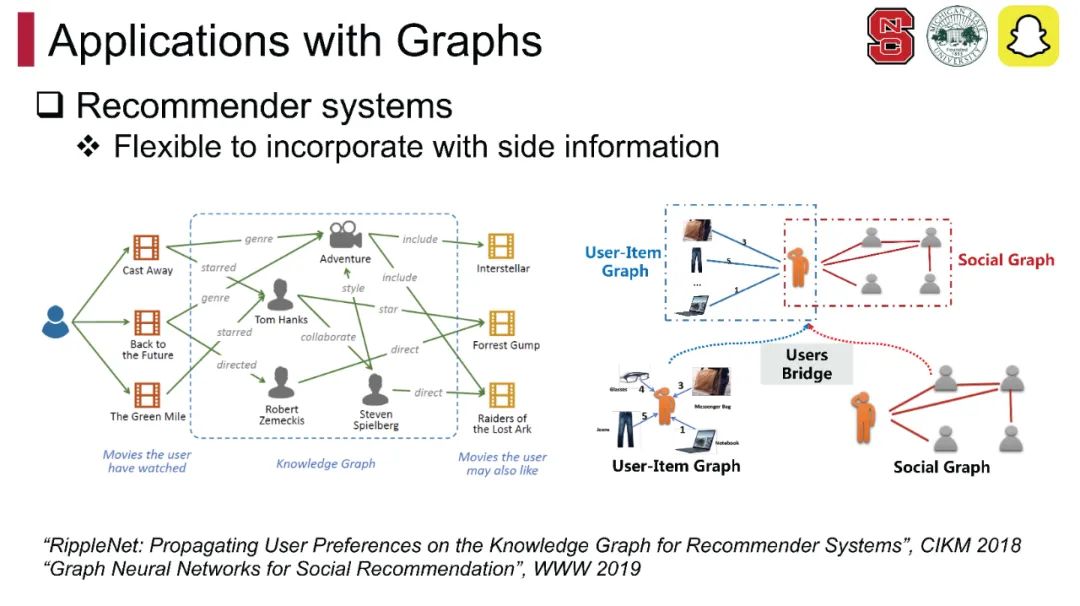

GNNs介绍 我们首先简要介绍图神经网络(GNNs)。我们将展示几个经典和基础的GNN模型及其在现实世界中的应用【1-3】。这些领域包括社交网络、生物分子和推荐系统。在基本概念之后,我们将通过理论分析和实证例子介绍大规模GNNs的可扩展性挑战【7, 8】。

- 扩展GNNs的经典方法 本节重点介绍使用各种创新设计的大规模GNNs的可扩展性和效率的经典研究,如采样方法【7-9】、预/后计算方法【3,10,11】和分布式方法。针对不同的类别,我们将介绍它们的基本方法论,它们如何缓解可扩展性问题,它们的变体和它们的局限性。这部分为观众提供了必要的知识,了解我们如何处理不断增大的图。

- 扩展GNNs的新兴技术

这部分将提供可扩展GNN研究中新兴趋势和技术的概述。我们将讨论三个方面的最新发展:训练、推理和数据。在训练策略方面,我们深入探讨创新方法,如懒惰图传播、交替训练以及预训练的日益重要性。在推理方面,我们介绍跨模型蒸馏的概念。此外,在数据管理领域,我们探索如图压缩、子图草图和表格化等不断发展的技术。这全面的审查提供了宝贵的洞见,了解正在塑造可扩展GNN研究未来的前沿发展。通过这次讨论的结束,观众将获得对可扩展GNN研究当前最先进状态的全面理解及其解决现实世界问题的潜力。

- 评估、比较和应用

在本节中,我们将评估介绍的方案,重点关注它们的准确性和计算复杂度。这些评估的结果将通知读者每种方法的优点和缺点。这样的洞见不仅将指导选择适合扩展GNNs的技术,也将激励研究人员和实践者创建更有效、更精确的大规模GNNs。随着大规模图数据的可用性增长,可扩展GNNs在解决复杂问题和在各个领域进行准确预测的重要性将上升。我们将深入探讨可扩展GNNs在著名现实世界应用中的影响,如网规模推荐系统、朋友推荐和欺诈检测。此外,我们将介绍几个为大规模图定制的平台和包。最后,我们将讨论一些在现实世界应用中的普遍挑战和潜在的研究途径。

- 总结和未来方向

我们将总结本教程并提供关于大规模GNNs未来方向的讨论。

参考文献: * Kipf, T. N., & Welling, M. (2016). Semi-supervised classification with graph convolutional networks. arXiv preprint arXiv:1609.02907. * Gasteiger, J., Bojchevski, A., & Günnemann, S. (2018). Predict then propagate: Graph neural networks meet personalized PageRank. arXiv preprint arXiv:1810.05997. * Wu, F., Souza, A., Zhang, T., Fifty, C., Yu, T., & Weinberger, K. (2019). Simplifying graph convolutional networks. In International conference on machine learning, pages 6861–6871. PMLR. * Yao, L., Mao, C., & Luo, Y. (2019). Graph convolutional networks for text classification. In Proceedings of the AAAI conference on artificial intelligence, volume 33, pages 7370–7377. * Zhang, Y., Zhang, H., & Tang, J. (2018). Graph convolutional networks for protein structure prediction. In Advances in Neural Information Processing Systems, pages 991–1001. * Wu, S., Sun, F., Zhang, W., Xie, X., & Cui, B. (2022). Graph neural networks in recommender systems: a survey. ACM Computing Surveys, 55(5), 1–37. * Hamilton, W., Ying, Z., & Leskovec, J. (2017). Inductive representation learning on large graphs. In Advances in neural information processing systems, 30. * Chen, J., Ma, T., & Xiao, C. (2018). Fastgcn: fast learning with graph convolutional networks via importance sampling. arXiv preprint arXiv:1801.10247. * Chiang, W. L., Liu, X., Si, S., Li, Y., Bengio, S., & Hsieh, C. J. (2019). Cluster-GCN: An efficient algorithm for training deep and large graph convolutional networks. In Proceedings of the 25th ACM SIGKDD international conference on knowledge discovery & data mining, pages 257–266. * Sun, C., Gu, H., & Hu, J. (2021). Scalable and adaptive graph neural networks with self-label-enhanced training. arXiv preprint arXiv:2104.09376. * Huang, Q., He, H., Singh, A., Lim, S. N., & Benson, A. R. (2020). Combining label propagation and simple models out-performs graph neural networks. arXiv preprint arXiv:2010.13993. * Vasimuddin, Md., Misra, S., Ma, G., Mohanty, R., Georganas, E., Heinecke, A., Kalamkar, D., Ahmed, N. K., & Avancha, S. (2021). DistGNN: Scalable distributed training for large-scale graph neural networks. In Proceedings of the International Conference for High-Performance Computing, Networking, Storage and Analysis, pages 1–14. * Xue, R., Han, H., Torkamani, M. A., Pei, J., & Liu, X. (2023). LazyGNN: Large-scale graph neural networks via lazy propagation. ICML, 2023. * Han, H., Liu, X., Torkamani, A., Shi, F., Lee, V., & Tang, J. (2023). Alternately optimized graph neural networks. ICML, 2023. * Han, X., Zhao, T., Liu, Y., Hu, X., & Shah, N. (2023). MLPInit: Embarrassingly simple GNN training acceleration with MLP initialization. In The Eleventh International Conference on Learning Representations, 2023. * Zhang, S., Liu, Y., Sun, Y., & Shah, N. (2021). Graph-less neural networks: Teaching old MLPs new tricks via distillation. arXiv preprint arXiv:2110.08727. * Jin, W., Zhao, L., Zhang, S., Liu, Y., Tang, J., & Shah, N. (2021). Graph condensation for graph neural networks. arXiv preprint arXiv:2110.07580. 2021 * Chamberlain, B. P., Shirobokov, S., Rossi, E., Frasca, F., Markovich, T., Hammerla, N., Bronstein, M. M., & Hansmire, M. (2022). Graph neural networks for link prediction with subgraph sketching. arXiv preprint arXiv:2209.15486. * Zhang, D., Huang, X., Liu, Z., Hu, Z., Song, X., Ge, Z., Zhang, Z., Wang, L., Zhou, J., Shuang, Y., et al. (2020). AGL: A scalable system for industrial-purpose graph machine learning. arXiv preprint arXiv:2003.02454. * Ying, R., He, R., Chen, K., Eksombatchai, P., Hamilton, W. L., & Leskovec, J. (2018). Graph convolutional neural networks for web-scale recommender systems. In Proceedings of the 24th ACM SIGKDD international conference on knowledge discovery & data mining, pages 974–983. * Shi, J., Chaurasiya, V., Liu, Y., Vij, S., Wu, Y., Kanduri, S., Shah, N., Yu, P., Srivastava, N., Shi, L., et al. (2023). Embedding based retrieval in friend recommendation. 2023