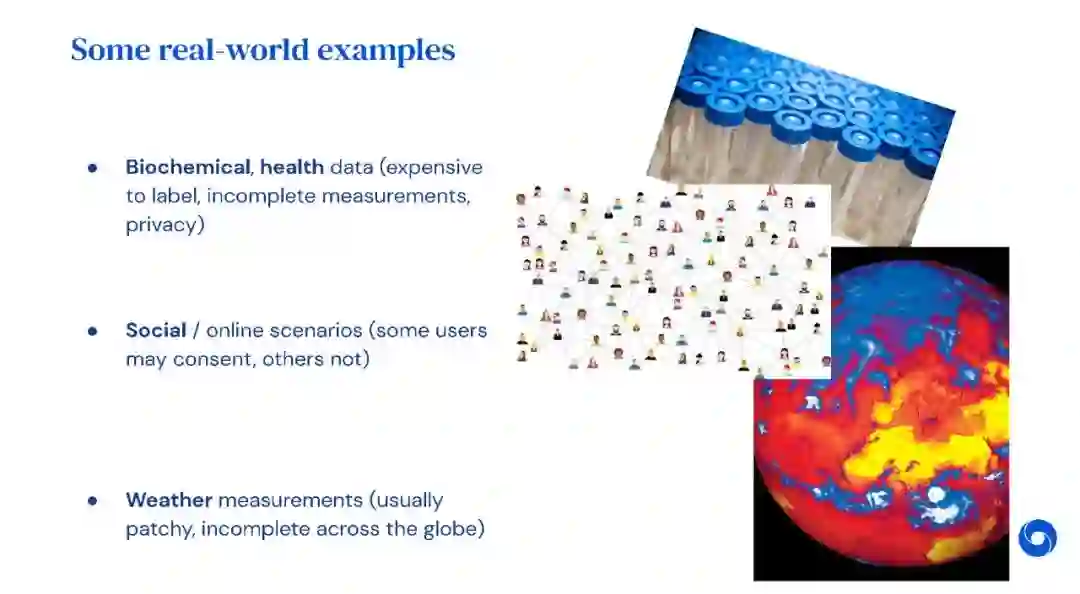

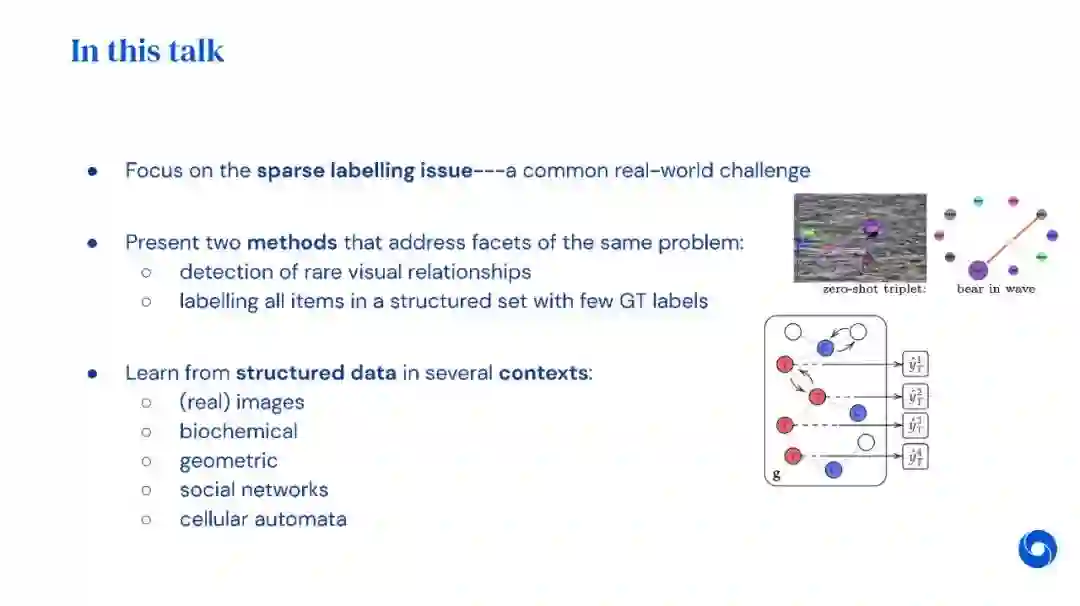

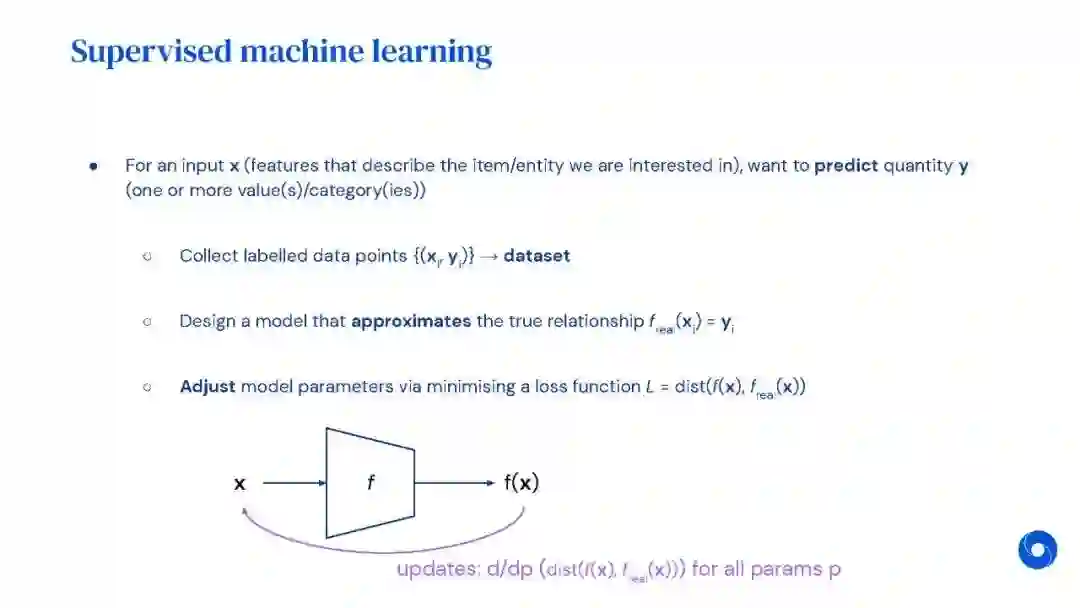

对结构化数据进行少样本学习可能是在现实生活中部署AI模型的基本要求。在经典的监督ML设置中,我们可以获得大量的标有标签的样本,这在现实环境中通常不是这样——一些例子是生化、健康、社会或天气环境。其中许多可以用图形表示,因此结构在设计能够成功处理这些场景的方法时也扮演着关键角色。因此,充分利用少数可用的标签并使我们的模型能够利用这些信息通常是很重要的,以便获得与通过数据需求方法获得的相同好的表示。该演讲展示了两件工作,从不同的角度解决了这个问题:场景图生成中新颖合成的图密度感知损失(Knyazev et al., 2020)和消息传递神经过程(Cangea & Day et al., 2020)。

https://catalinacangea.netlify.app/talk/roaidays_nov21/

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年10月5日