图神经网络如何用于知识图谱?这篇《图神经网络知识图谱补全》综述论文帮你总结好了

知识图谱补全是一类重要的问题。近年来基于图神经网络的知识图谱表示得到了很多关注。这边综述论文总结了图神经网络知识图谱补全的工作,值得查看!

摘要:知识图谱在诸如回答问题和信息检索等各种下游任务中越来越流行。然而,知识图谱往往不完备,从而导致性能不佳。因此,人们对知识库补全的任务很感兴趣。最近,图神经网络被用来捕获固有地存储在这些知识图谱中的结构信息,并被证明可以跨各种数据集实现SOTA性能。在这次综述中,我们了解所提出的方法的各种优势和弱点,并试图在这一领域发现新的令人兴奋的研究问题,需要进一步的调研。

https://arxiv.org/abs/2007.12374

1. 概述

知识库是以关系三元组形式的事实信息的集合。每个关系三元组可以表示为(e1,r,e2),其中e1和e2是知识库中的实体,r是e1和e2之间的关系。最受欢迎的知识库表示方式是多关系图,每个三元组(r e1, e2)是表示为有向边从e1, e2与标签r。知识图谱被用于各种下游任务。

然而,由于知识库是从文本中自动挖掘来填充的,它们通常是不完整的,因为不可能手动编写所有事实,而且在提取过程中经常会出现不准确的情况。这种不准确性会导致各种下游任务的性能下降。因此,大量工作开发一种有效的工具来完成知识库(KBs)方面,它可以在不需要额外知识的情况下自动添加新的事实。这个任务被称为知识库补全(或链接预测),其目标是解决诸如(e1,r,?)这样的查询。

第一种实现高效知识库补全的方法是像TransE (Bordes et al.(2013))和TransH (Wang et al.(2014))这样的加法模型,其中关系被解释为隐藏实体表示的简单翻译。然后观察到,诸如Distmult (Yang et al.(2015))和Complex (Trouillon et al.(2016))等乘法模型优于这些简单的相加模型。与平移不同,旋转(Sun等人(2019a))将关系定义为简单的旋转,这样头部实体就可以在复杂的嵌入空间中旋转来匹配尾部实体,这已经被证明满足了很多有用的语义属性,比如关系的组合性。最近,引入了表达性更强的基于神经网络的方法(如ConvE (Dettmers等人(2018))和ConvKB(Nguyen等人(2018)),其中评分函数与模型一起学习。然而,所有这些模型都独立地处理每个三元组。因此,这些方法不能捕获语义丰富的邻域,从而产生低质量的嵌入。

图已被广泛用于可视化真实世界的数据。在将ML技术应用于图像和文本方面已经取得了巨大进展,其中一些已成功应用于图形(如Kipf和Welling(2017)、Hamilton等人(2017)、Velickovic等人(2018)。基于该方法的启发,许多基于图神经网络的方法被提出用于KBC任务中获取知识图的邻域。在这次调查中,我们的目的是研究这些工作。

2. 数据

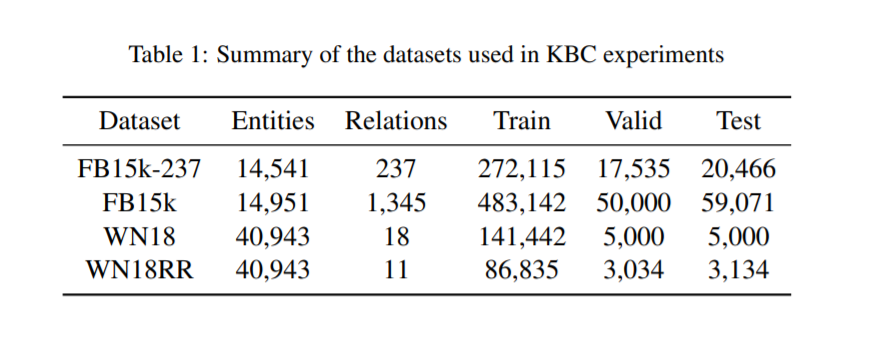

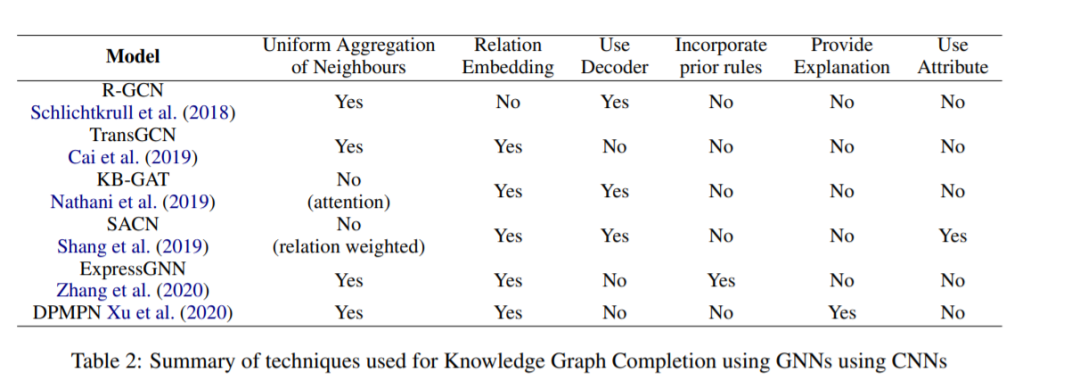

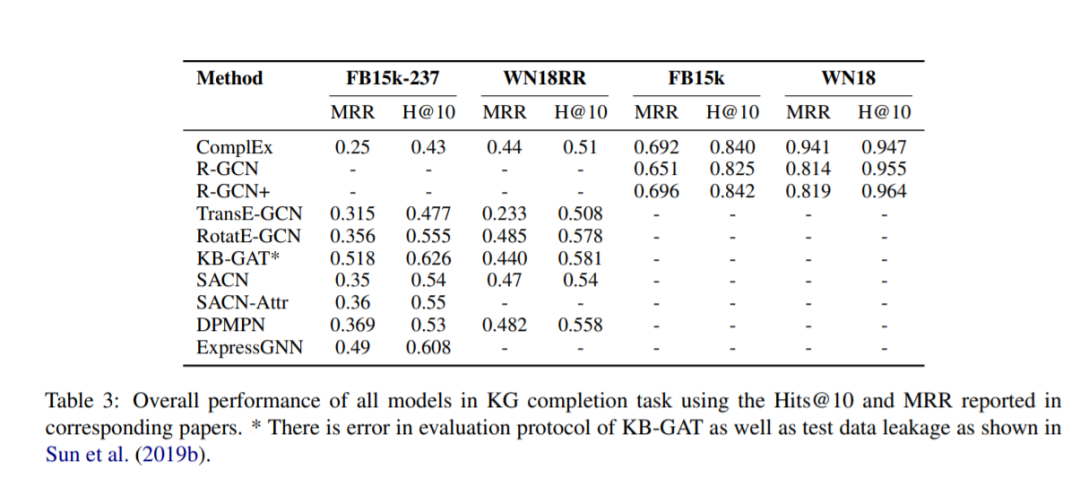

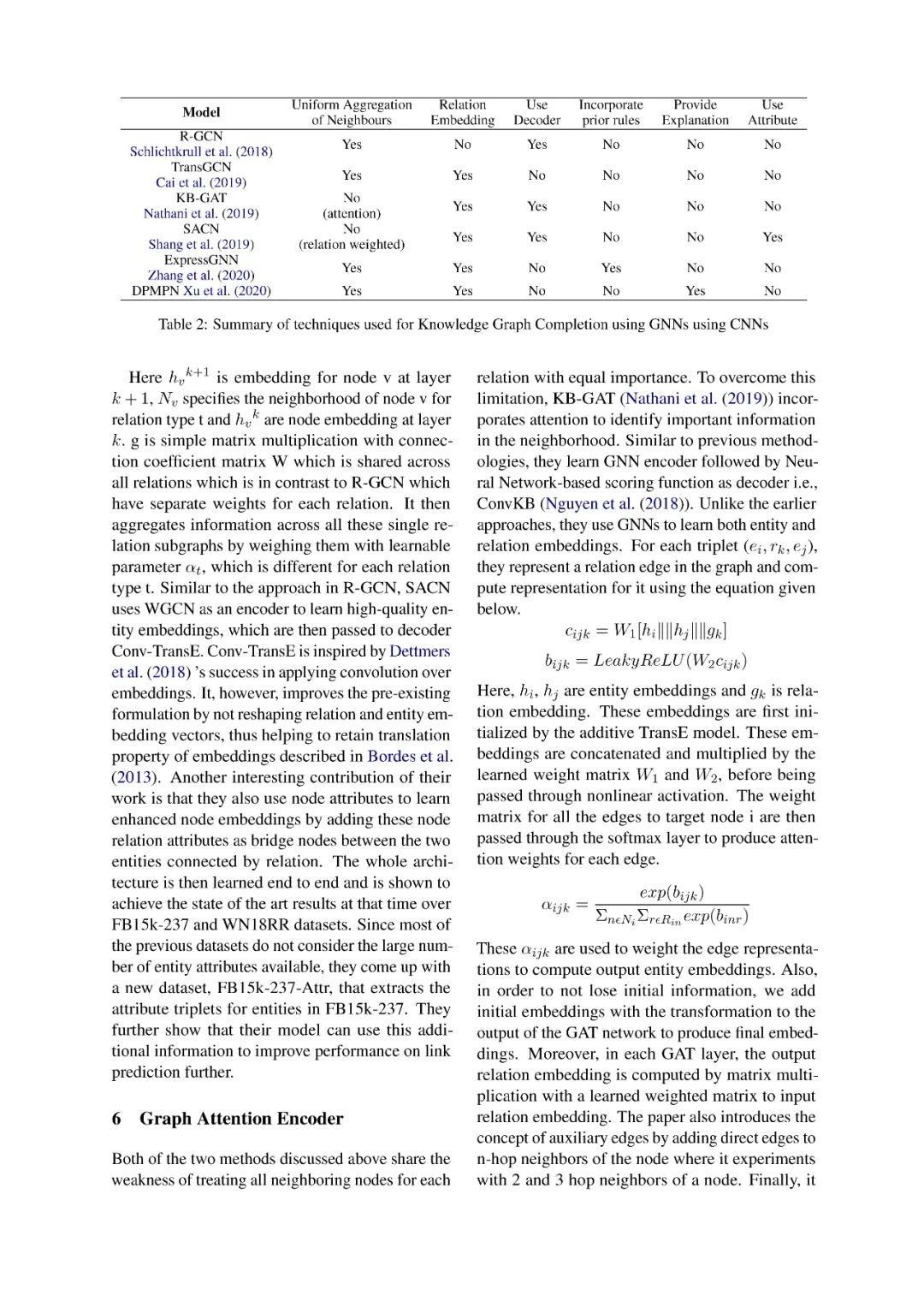

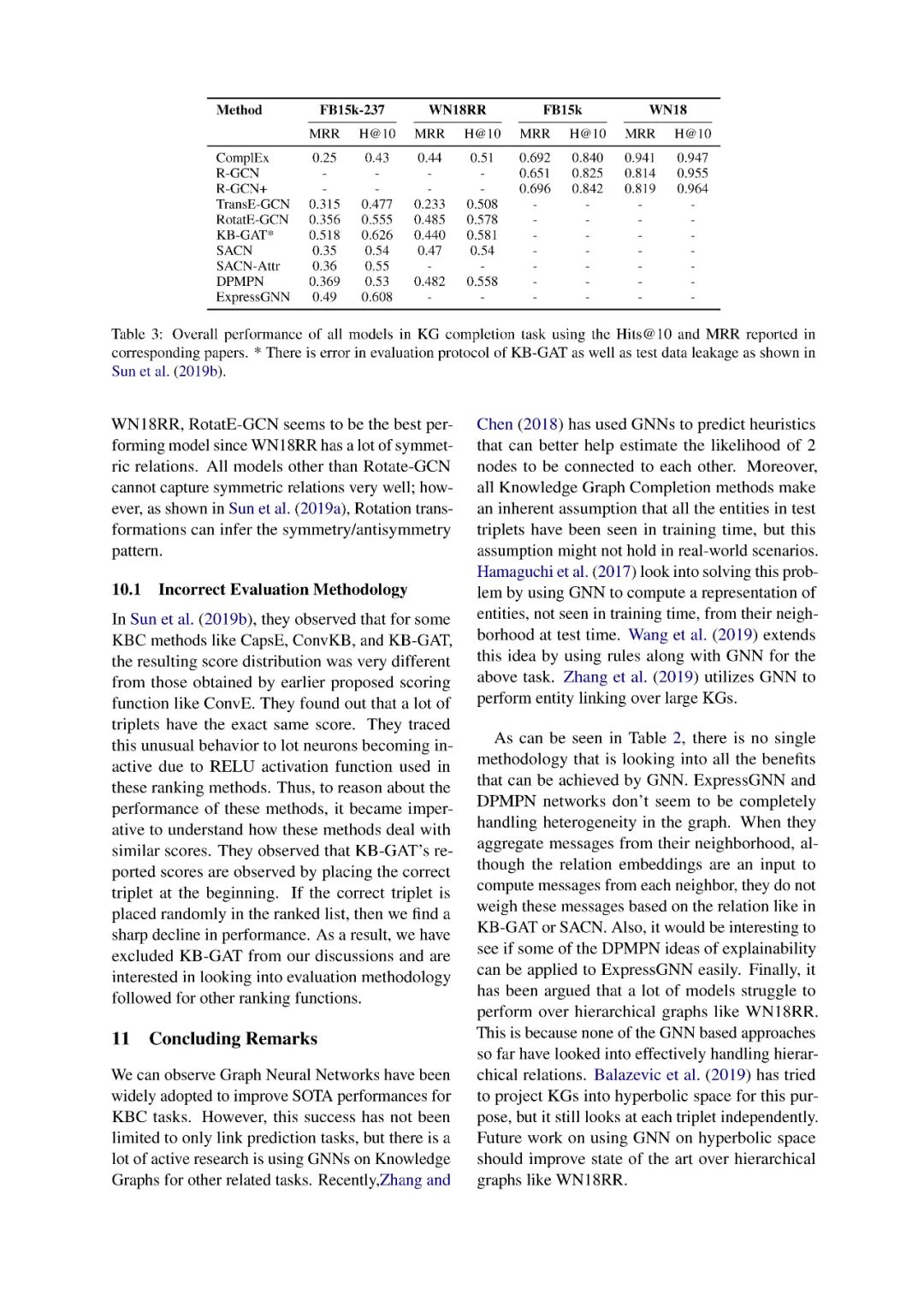

知识图谱补全方法已经在各种基准数据集上进行了评估。现在,我们将简要地介绍这些用于评估KBC任务中对的知识库。表1显示了对这些基准数据集大小的描述。

3. 基本概念

在本节中,我们将讨论一些与图神经网络相关的基本概念。

3.1 消息传递神经网路

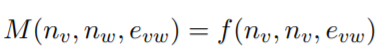

消息传递网络(Gilmer et al.(2017))是一个旨在泛化各种基于图的数据的神经网络的框架。让我们看看图G,对于所有节点v,节点嵌入nv,对于v和w之间的所有边,边嵌入evw。我们首先定义如下所示的消息函数

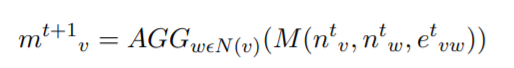

式中,f为非线性函数,通常取MLP。然后,将来自节点v的所有邻居w的消息聚合到一起,计算发送到节点v的网络消息

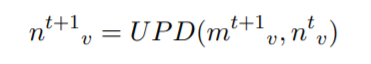

其中,N(v)为v的邻居集,t为消息聚合时的时间步长,AGG为聚合函数,可以是和,均值,也可以是其他函数。最后,使用UPD更新函数对节点v的嵌入进行更新,如下所示:

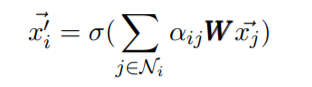

3.2 图卷积网络

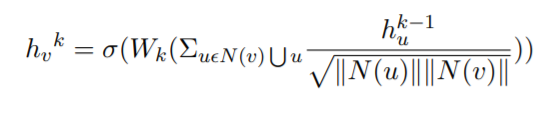

图卷积网络是基于谱图卷积网络的。这里的数据集由每个节点的顶点集、邻接矩阵和特征集组成的图。这些特性可以是分类属性(如节点标签)、结构特性(如节点度数)以及针对每个节点的简单单次热编码。GCNs使用下面所示的简单公式从节点的邻居处聚合信息。

3.3 图注意力网络

在GCNs中,所有的邻居对每个目标节点的聚合贡献相等。Graph Attention Networks (GATs) [Velickovic等人(2018)]通过学习对所考虑节点的邻域内的所有节点分配不同程度的重要性,而不是将每个节点同等重要或使用固定的权重,克服了之前工作的缺点。此外,GATs可以推广到看不见的节点(归纳学习),从而模拟真实世界的设置,并在各种任务中提高了技术水平。

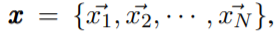

GAT输入是

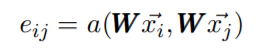

其中N是节点数。然后用下式计算每条边的注意力权值。

其中W为权值矩阵,a为任意注意力函数,eij为节点i和节点j之间边的注意力权值,对每个节点i通过softmax函数进行权值归一化。每个节点的嵌入输出由下式计算

3.4 解码器

许多为KBC任务使用GNN的方法使用它们作为自动编码器来帮助提供相邻关系三元组的信息。然后,预先存在的评分函数(如DistMult)以其实体嵌入的初始化形式丰富了这些信息,并优于仅使用评分函数的方法。这个评分函数在文献中称为解码器。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“GNNKG” 可以获取《《图神经网络知识图谱补全》综述论文》专知下载链接索引