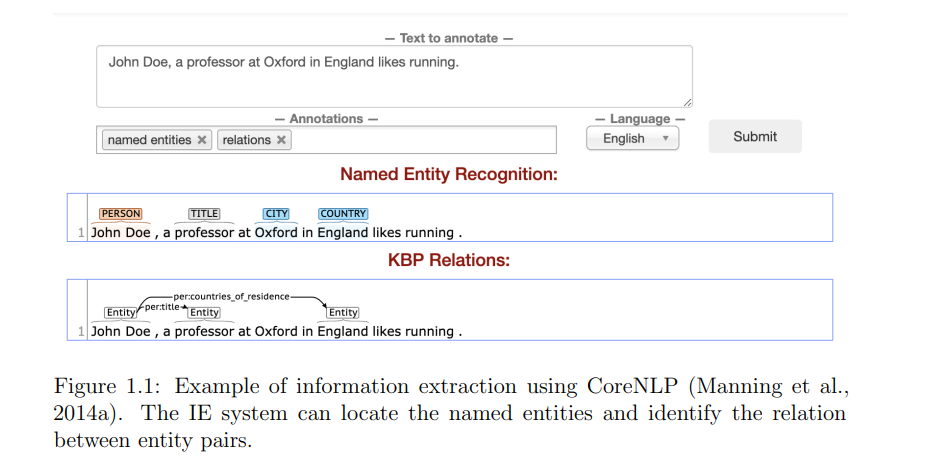

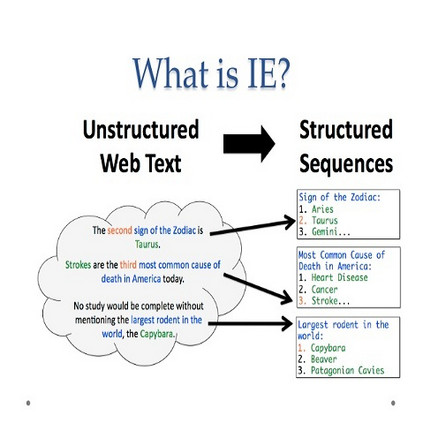

**可解释性对于许多NLP应用非常重要。许多这样的应用(例如,信息提取、情感分析)被应用于重要的决策领域,如政府政策、金融、法律等。在这些场景中,如果要将机器部署到现实世界中,它们必须解释产生的信息。****本文提出了一些信息提取的方法,通过对两个目标进行联合训练,缓解了泛化和可解释性之间的紧张关系。**首先,研究了一种使用编码器-解码器架构的方法,联合训练一个用于信息提取的分类器,以及一个生成解释分类器决策的语法-语义规则的规则解码器。在两个不同的信息提取任务上评估了所提出的方法,结果表明,解码器生成了可解释的规则,这些规则作为分类器决策的准确解释,重要的是,联合训练通常提高了分类器的性能。该方法可用于半监督学习,在基于规则的系统生成的自动标记数据上进行训练时,其性能有所提高。其次,研究了另一种方法,使用多任务学习架构,联合训练一个用于关系提取的分类器,以及一个序列模型,在关系的上下文中标记解释关系分类器决策的单词。还将模型输出转换为规则,以对这种方法进行全局解释。这个序列模型使用一种混合策略进行训练:有监督的,当来自预先存在的模式的监督可用时,半监督的。在后一种情况下,我们将序列模型的标签视为潜在变量,并学习最大化关系分类器性能的最佳分配。在两个关系抽取数据集上对所提出的方法进行了评估,结果表明,序列模型为关系分类器的决策提供了准确的解释,重要的是,联合训练通常提高了关系分类器的性能。评估了生成规则的性能,并表明新规则是手工规则的很好的补充,使基于规则的系统更接近神经模型。第三,我们还从两种方式探索了模型输出的用法。将它们转换为规则,以对这种方法进行全局解释;和2。当我们没有足够的数据时,可以使用它们来引导。全局可解释模型在合理的差距内接近神经模型的性能。

成为VIP会员查看完整内容

相关内容

Arxiv

2+阅读 · 2023年4月19日

Arxiv

0+阅读 · 2023年4月19日