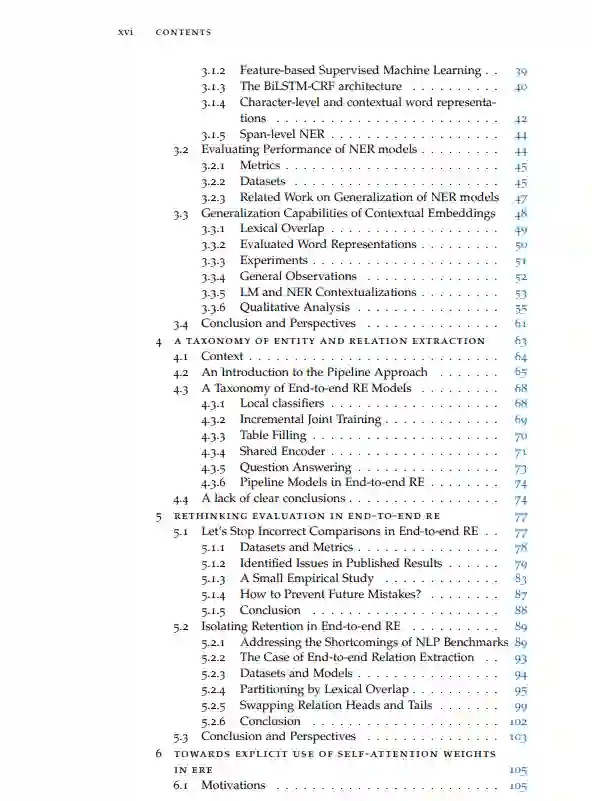

在过去的十年中,神经网络在自然语言处理(NLP)领域已经取得了显著的进展,特别是因为它们能够从大量的未标记语料库中学习相关的单词表征。这些词嵌入可以在监督训练中进行迁移移和微调应用到不同的终端应用。最近,在2018年,整个预训练语言模型的迁移和上下文化能力的保留使得几乎在每一个NLP基准上都达到了前所未有的性能,有时甚至超过了人类的基准。然而,当模型达到如此令人印象深刻的分数时,它们的理解能力仍然显得很肤浅,这揭示了基准的局限性,不能为它们的表现因素提供有用的见解,并准确地衡量理解能力。

在本论文中,我们研究了最SOTA模型在两个重要的信息提取任务(命名实体识别(NER)和关系提取(RE))中关于在未见事实的泛化性能。事实上,传统基准在提到和关系之间存在重要的词汇重叠,用于训练和评估模型,而信息提取的主要兴趣是提取以前未知的信息。我们提出了基于提及和与训练集的关系重叠来分离性能的实证研究,发现预训练的语言模型主要有利于检测未见提及,特别是域外提及。虽然这使得它们适合于真正的用例,但可见和未见提及之间仍然存在性能差距,这不利于对新事实的归纳。特别是,即使是最先进的ERE模型也依赖于浅层记忆启发式,其预测更多地基于论据表面形式而不是上下文。

在这项工作中,我们还巩固了端到端关系提取评估的基础,这一基础被以前的不正确的比较所破坏,并提出了一个更细粒度的评估和理解端到端关系提取模型,以泛化到新的关系。最后,我们提出了在创建未来的模型和数据集时改进上下文合并的想法。

成为VIP会员查看完整内容

相关内容

Arxiv

13+阅读 · 2019年11月14日