世界上结构化数据非常丰富,许多NLP应用都试图对这些数据进行推理。尽管取得了成功,但现代神经网络模型往往难以纳入结构化信息。本文研究如何建立有效的神经网络模型,以结合结构化数据进行自然语言理解。 图是结构信息表示的一种自然形式,最近提出的图神经网络(GNNs)允许神经网络通过可学习的消息传递函数在图上执行推理。本文首先有效地介绍了第一个GNN模型,适用于与NLP应用相关的结构化数据的常见形式中发现的有向、多关系数据,如知识库(KBs)。本文研究用于关系链接预测、问答和事实验证的结构编码器。一个重大挑战是此类编码器的不可解释、黑箱性质。为缓解这个问题,本文提出一种解释GNN预测的新技术。

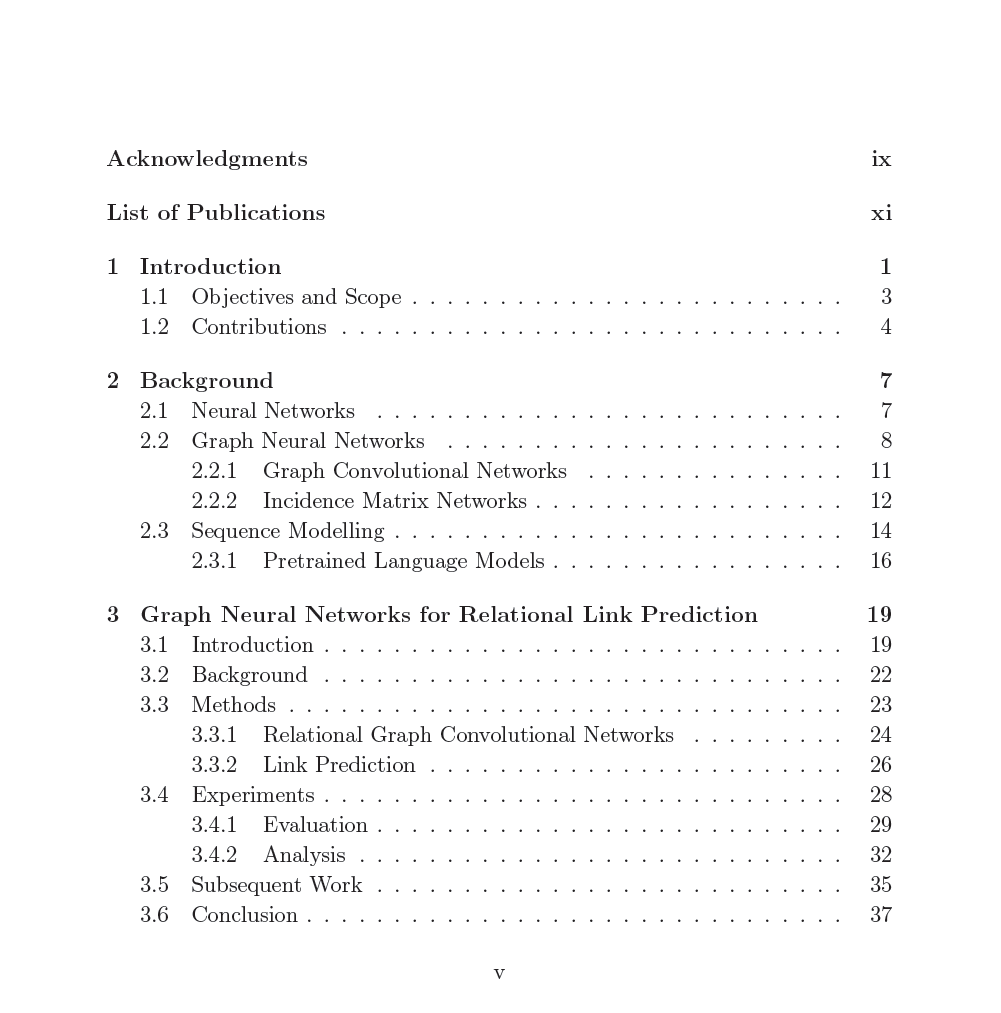

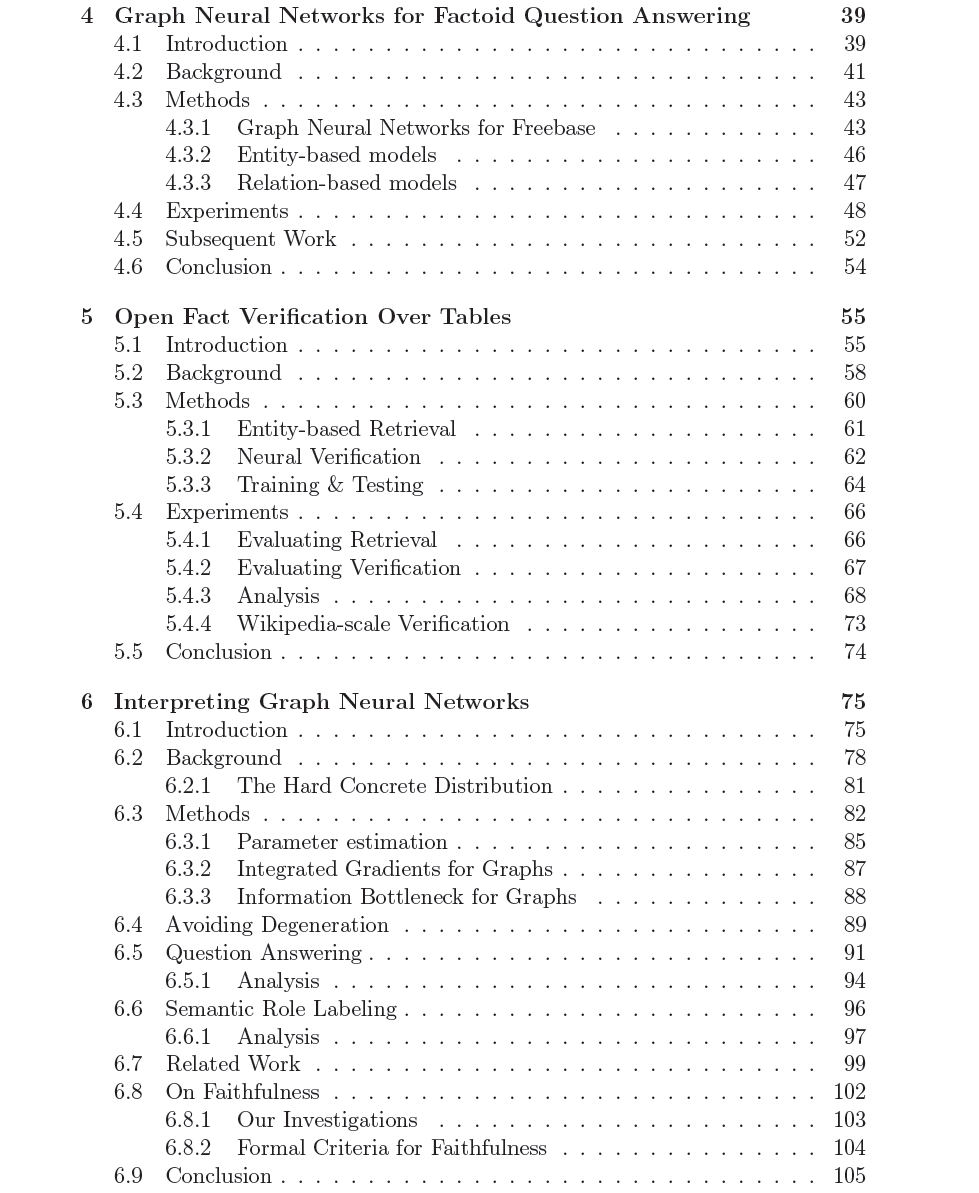

我们的工作分为四章:

-本文提出关系图卷积网络(R-GCN)编码器,用于知识库中的关系链接预测。R-GCNs是GNN的一种新变体,适用于对KBs中发现的有向、多关系数据进行建模。通过将我们的R-GCN编码器与文献中的因子分解解码器相结合,在本文发表时,我们在FB15k-237数据集上取得了最先进的性能。该模型在涉及高度顶点和稀有关系的复杂推理中表现得特别好。

-本文提出了两个基于GNN的KBs事实问答模型,依赖于选择单个答案顶点,或选择答案的最佳路径。除了R-GCN,还提出了一种变体,使用门来限制使用哪些边。我们通过l_1 -惩罚来鼓励这种选择的稀疏性。来自稀疏性的改进展示了基于GNN的模型如何从滤除多余的边缘中获益。

-本文提出一种新的模型,用于在开放的表集合上进行事实验证,将用于线性化表的RoBERTa编码器与用于融合证据文档的交叉注意力机制相结合。线性化是图建模结构的一个重要替代方案。在开放域中操作时,所提出方法实现了与当前封闭域技术水平相当的性能;当在封闭域中操作时,该方法设置了新的技术水平。本文还提出了两种新的策略,用于利用封闭域数据集来提高在开放域的性能,依赖于联合建模声明真相和证据重排序的目标。

-正如我们的经验表明,可解释性是GNN的一个重要问题。本文提出GraphMask,一种新的基于GNN模型的事后解释技术。通过为每个消息学习端到端的可微0 - 1门,GraphMask为GNN如何实现特定预测产生了忠实、可扩展和易于理解的解释。在一个具有已知忠实度gold标准的合成任务上测试了所提出方法,表明GraphMask比当前的替代方法要好。将该技术应用于分析文献中两个NLP模型的预测——语义角色标注模型和问答模型。