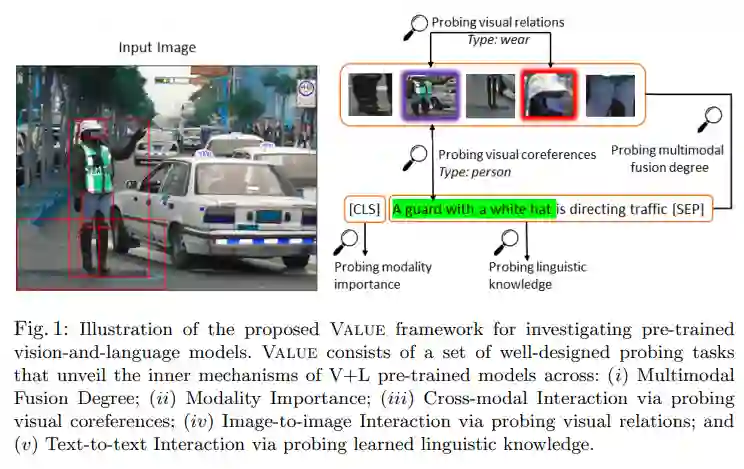

题目: Behind the Scene: Revealing the Secrets of Pre-trained Vision-and-Language Models

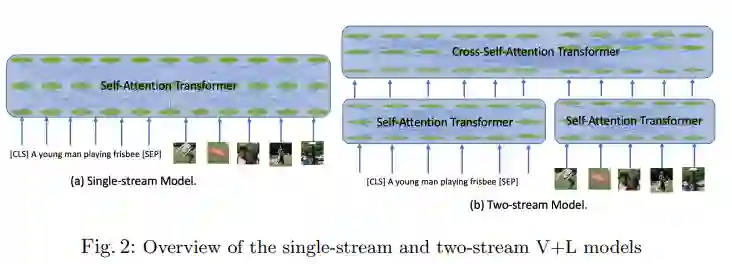

摘要: 最近基于Transformer的大规模预训练模型已经彻底改变了视觉和语言(V+L)研究。ViLBERT、LXMERT和UNITER等模型通过联合图像-文本预训练在大量的V+L基准上显著提高了技术水平。然而,人们对这些令人印象深刻的成功背后的内在机制知之甚少。为了揭示这些强大的模型的场景背后的秘密,我们提出的Value(视觉和语言理解评估),是一个精心设计的探索任务(如视觉算法,视觉检测的关系,语言探索任务)可概括的标准预训练V+L模型,旨在解读多通道的内部运作训练的(例如,个人的隐性知识获得关注,通过上下文化的多模态嵌入学习的固有的跨模态对齐)。通过这些探测任务对每个原型模型体系结构进行大量的分析,我们的主要观察结果如下:(i)预训练的模型显示出在推理过程中专注于文本而非图像的倾向。(ii)存在一种注意力头子集,专门用于捕捉跨模态交互。(iii)在预训练的模型中学习注意力矩阵,显示与图像区域和文本单词之间的隐对齐一致的模式。(iv)绘制的注意力模式揭示了图像区域之间的视觉解释关系。纯粹的语言知识也有效地编码在注意力头中。这些都是有价值的见解,有助于指导未来的工作,以设计更好的模型架构和目标的多模态预训练。

成为VIP会员查看完整内容

相关内容

专知会员服务

32+阅读 · 2020年2月21日

专知会员服务

43+阅读 · 2020年1月28日

专知会员服务

11+阅读 · 2019年12月28日

Arxiv

7+阅读 · 2018年4月6日