在过去的十年里,深度学习的兴起重新定义了许多计算机视觉和自然语言处理任务中的最先进技术,其应用范围从自动个人助理和社交网络过滤到自动驾驶汽车和药物开发。这些算法的普及源于GPU普及带来可用于训练的计算能力的指数级增长。准确度的提高创造了对适合部署在边缘设备上的更快、更省电的硬件需求。在这篇论文中,我们提出了一系列创新和技术,这些创新和技术属于这种需求所引发的众多研究领域之一,重点是卷积神经网络的高能效硬件。

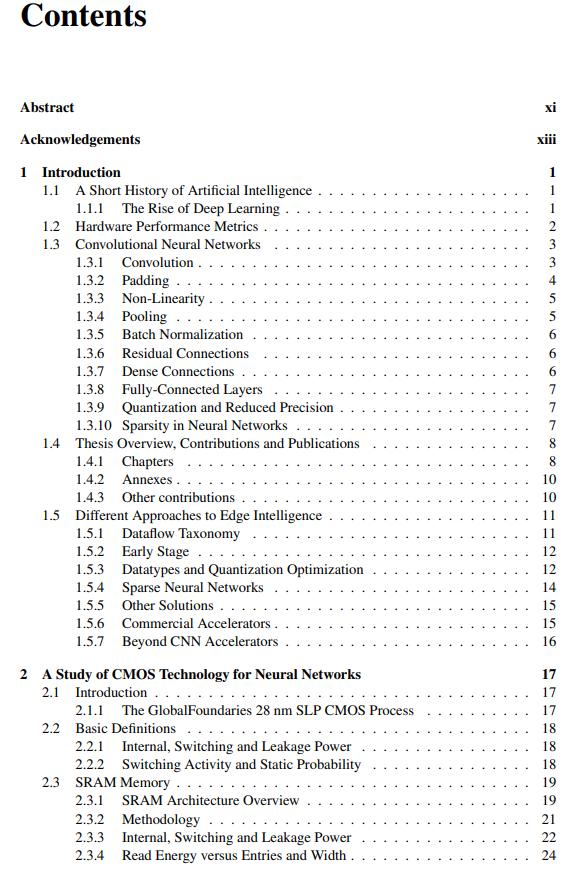

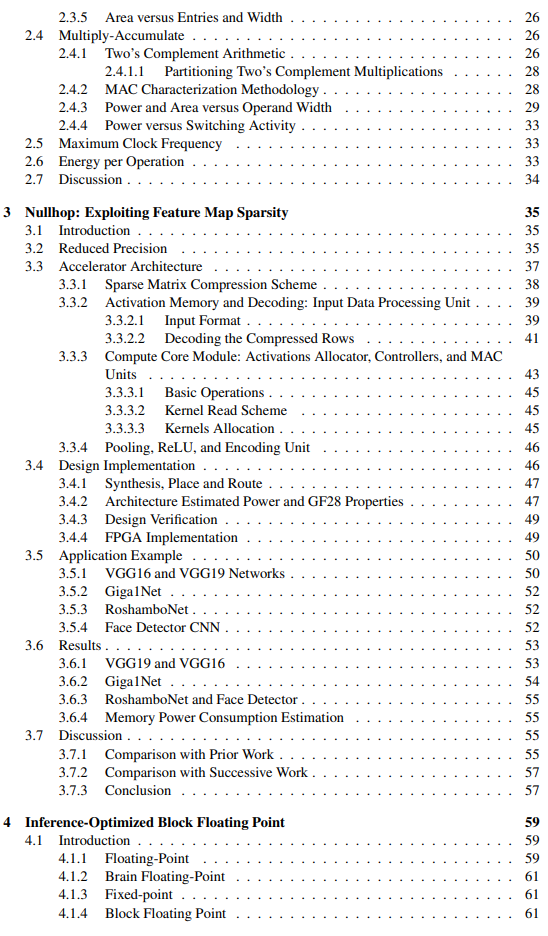

我们首先研究了标准28纳米CMOS工艺在深度学习加速器设计方面的表现,特别考虑了在使用降低精度的算术和短SRAM内存字节时,基于标准单元电路的功率和面积。这一分析的结果表明,降低位精度后的功率效率增益是如何非线性的,以及在使用16位精度时如何达到饱和。

我们提出了Nullhop,一个率先使用卷积神经网络典型的特征图稀疏性的加速器,并通过量化来提高硬件能力。Nullhop的创新之处在于它能够跳过所有的乘法运算,包括零值激活。在6.3平方毫米的空间内,它的功率效率达到3 TOP/s/W,吞吐量几乎达到0.5 TOP/s。

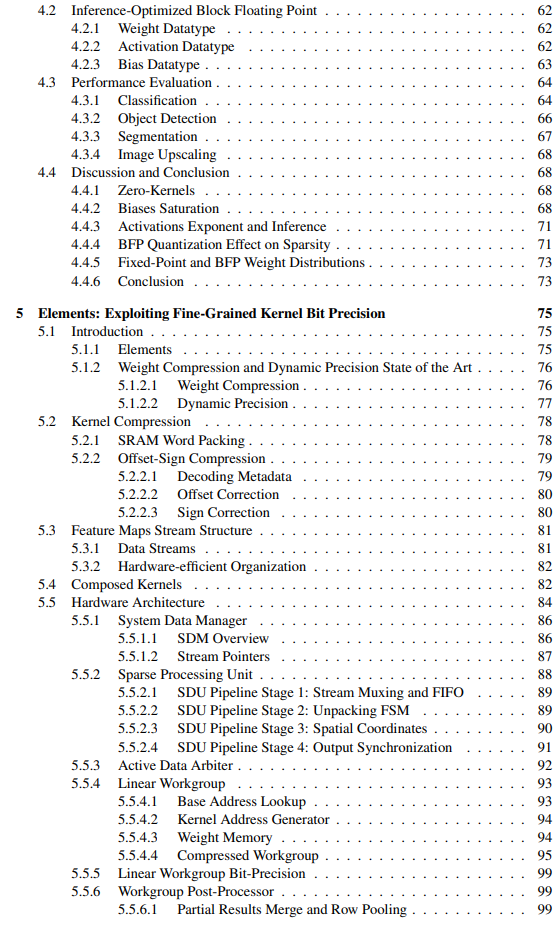

我们提出了一种基于硬件-软件代码设计方法的神经网络量化算法。我们在分类、物体检测、分割和图像生成等各种任务上训练几个网络,以证明其能力。该量化方案在Elements中实现,Elements是一个卷积神经网络加速器架构,支持可变权重位精度和稀疏性。我们通过多种设计参数化来展示Elements的能力,适合于广泛的应用。其中一个参数化被称为Deuterium,仅用3.3平方毫米就达到了超过4 TOP/s/W的能源效率。

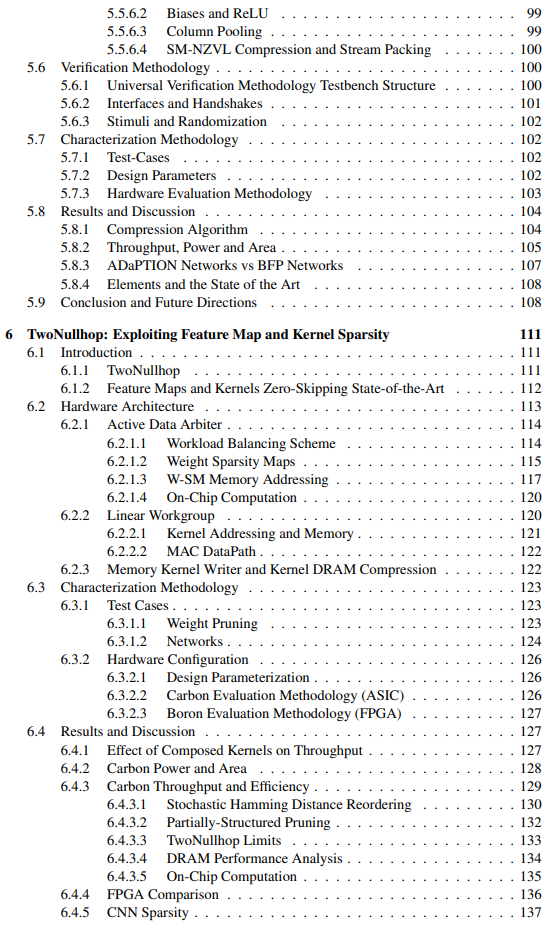

我们用第三个卷积神经网络加速器架构进一步探索稀疏性的概念,该架构被称为TwoNullhop,能够跳过特征图和内核的零值。我们用Carbon测试了TwoNullhop架构,这个加速器尽管只有128个乘积单元,而且运行频率只有500MHz,但在只有4平方毫米的空间里,实现了超过2.4TOP/s的能效,10.2TOP/s/W。

论文最后概述了我们预见的未来深度学习硬件发展的挑战和可能性,试图预测哪些主题将在未来几年主导该领域。