论文题目: Privacy-Preserving Gradient Boosting Decision Trees

论文作者: Qinbin Li, Zhaomin Wu, Zeyi Wen, Bingsheng He

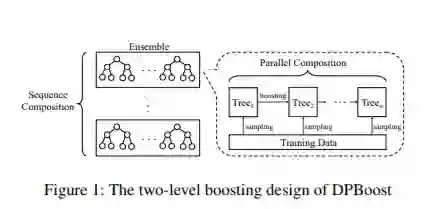

论文摘要: 梯度提升决策树(GBDT)是近年来用于各种任务的流行机器学习模型。在本文中,我们研究如何在保留差异性隐私的有力保证的同时提高GBDT的模型准确性。敏感度和隐私预算是差异化私人模型有效性的两个关键设计方面。现有的具有差分隐私保护的GBDT解决方案由于过于宽松的敏感性界限和无效的隐私预算分配(尤其是GBDT模型中的不同树)而导致严重的准确性损失。松散的灵敏度范围导致更多的噪声以获得固定的优先级。无效的隐私预算分配使准确性降低,尤其是在树的数量很大时。因此,我们提出了一种新的GBDT训练算法,该算法可实现更严格的灵敏度范围和更有效的噪声分配。具体而言,通过研究梯度的属性和每棵树在GBDT中的贡献,我们提出针对每个迭代和叶节点修剪自适应地控制训练数据的梯度,以收紧敏感度范围。此外,我们设计了一种新颖的增强框架,可以在树之间分配隐私预算,从而可以减少准确性损失。我们的实验表明,与其他基准相比,我们的方法可以实现更好的模型准确性。

成为VIP会员查看完整内容

相关内容

专知会员服务

22+阅读 · 2020年6月19日

专知会员服务

15+阅读 · 2020年3月7日

专知会员服务

44+阅读 · 2019年11月20日

Arxiv

11+阅读 · 2018年6月16日