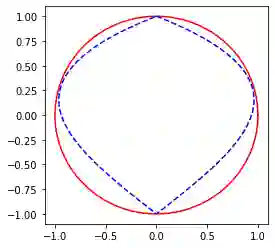

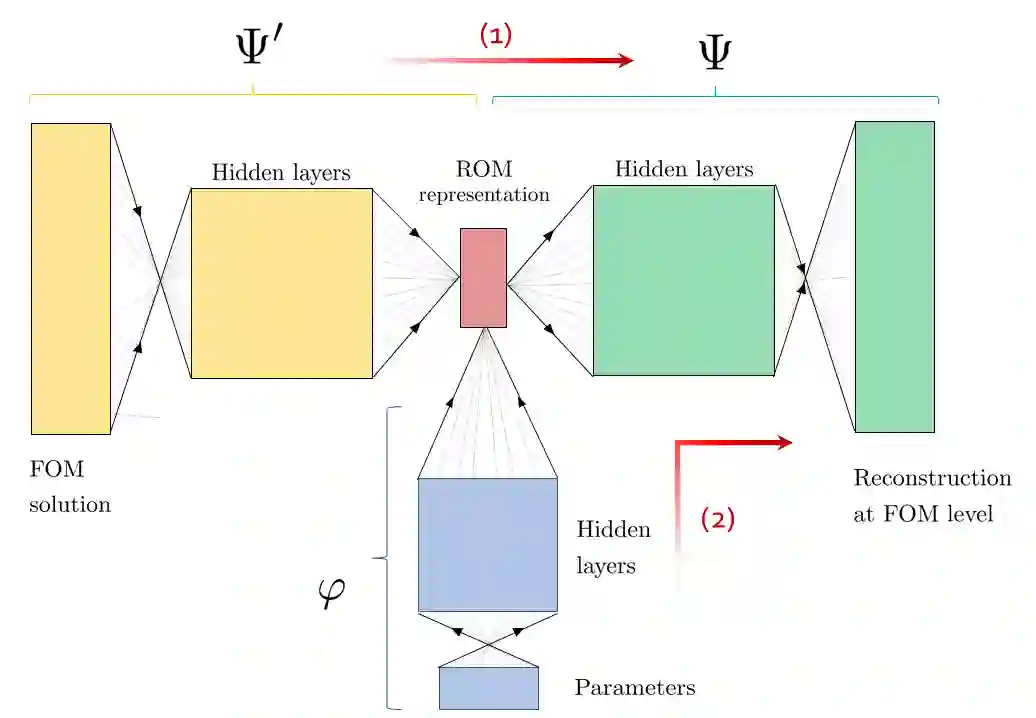

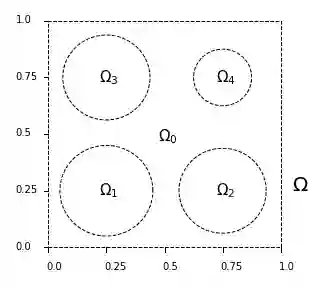

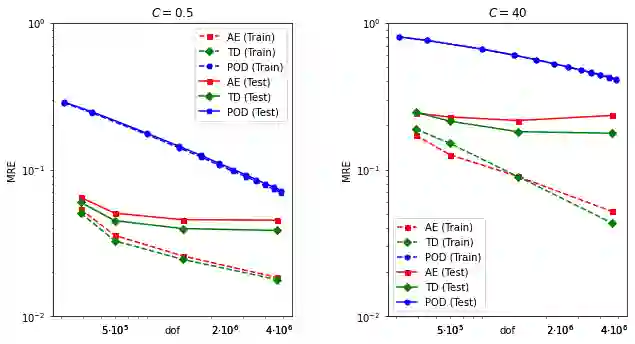

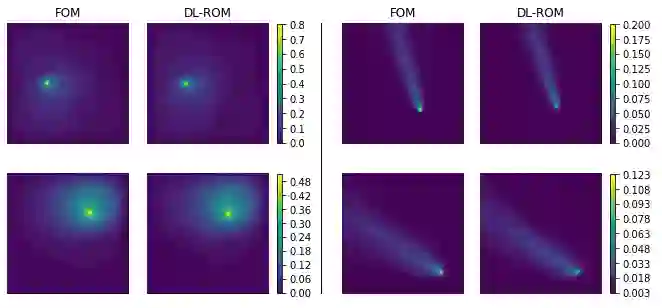

Within the framework of parameter dependent PDEs, we develop a constructive approach based on Deep Neural Networks for the efficient approximation of the parameter-to-solution map. The research is motivated by the limitations and drawbacks of state-of-the-art algorithms, such as the Reduced Basis method, when addressing problems that show a slow decay in the Kolmogorov n-width. Our work is based on the use of deep autoencoders, which we employ for encoding and decoding a high fidelity approximation of the solution manifold. In order to fully exploit the approximation capabilities of neural networks, we consider a nonlinear version of the Kolmogorov n-width over which we base the concept of a minimal latent dimension. We show that this minimal dimension is intimately related to the topological properties of the solution manifold, and we provide some theoretical results with particular emphasis on second order elliptic PDEs. Finally, we report numerical experiments where we compare the proposed approach with classical POD-Galerkin reduced order models. In particular, we consider parametrized advection-diffusion PDEs, and we test the methodology in the presence of strong transport fields, singular terms and stochastic coefficients.

翻译:在参数依赖性 PDE 框架内,我们以深神经网络为基础,为有效近近近参数到溶解的地图制定了一种建设性的方法。研究的动机是,在解决科尔莫戈洛夫 n-width 缓慢衰减的问题时,如 " 降低基础方法 " 等最新算法的局限性和缺点。我们的工作基于使用深自动调解码器,用于编码和解码解决方案方块的高度忠诚近似值。为了充分利用神经网络的近似能力,我们考虑 Kolmogorov n-width的非线性版本,作为我们最小潜在维度概念的基础。我们表明,这一最小维度与解决方案多维的地形特性密切相关,我们提供一些理论结果,特别强调第二顺序的椭圆形PDE。最后,我们报告数字实验,将拟议方法与古典POD-Galerkin 减序模型进行比较。我们特别考虑在坚固的磁场上的adminction-divoculation 方法中,我们测试了坚固的磁场的PDE-divology 方法。