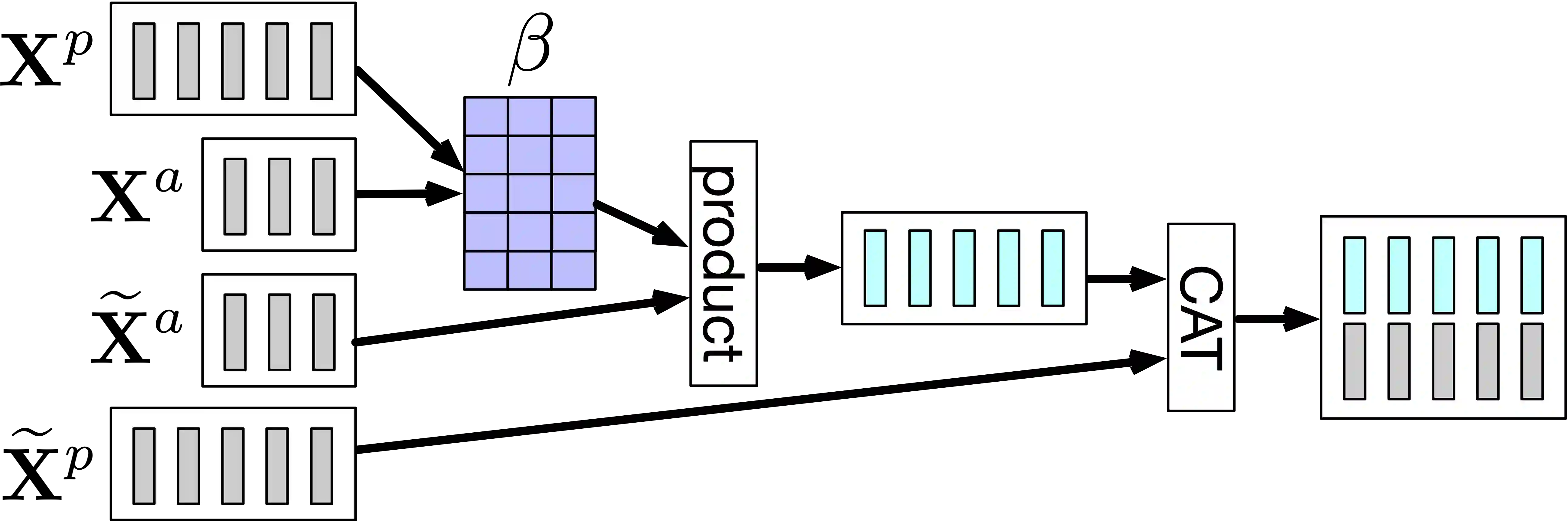

Natural question generation (QG) aims to generate questions from a passage and an answer. Previous works on QG either (i) ignore the rich structure information hidden in text, (ii) solely rely on cross-entropy loss that leads to issues like exposure bias and inconsistency between train/test measurement, or (iii) fail to fully exploit the answer information. To address these limitations, in this paper, we propose a reinforcement learning (RL) based graph-to-sequence (Graph2Seq) model for QG. Our model consists of a Graph2Seq generator with a novel Bidirectional Gated Graph Neural Network based encoder to embed the passage, and a hybrid evaluator with a mixed objective combining both cross-entropy and RL losses to ensure the generation of syntactically and semantically valid text. We also introduce an effective Deep Alignment Network for incorporating the answer information into the passage at both the word and contextual levels. Our model is end-to-end trainable and achieves new state-of-the-art scores, outperforming existing methods by a significant margin on the standard SQuAD benchmark.

翻译:自然问题生成( QG) 旨在从段落和答案中产生问题 。 之前关于 QG 的作品要么 (一) 忽略文本中隐藏的丰富结构信息, 要么 (二) 完全依赖导致接触偏差和火车/测试测量之间不一致等问题的交叉热带损失, 要么 (三) 没有充分利用答案信息。 为了解决这些局限性, 我们在本文件中建议为 QG 建立一个基于图形到序列( Graph2Seq) 模型的强化学习( RL ) 。 我们的模式包括一个Greaph2Seq 生成器, 配有新型双向 Gate 图形神经网络编码, 以嵌入通道, 以及一个混合评价器, 具有混合目标, 将交叉孔径和 RL 损失结合起来, 以确保生成协同和 语义有效的文本。 我们还引入一个有效的深度协调网络, 将答案信息纳入文字和背景层次的段落中。 我们的模式是端到端可训练的, 并实现新的状态分数, 在标准 QuAD 基准上以显著的边缘执行现有方法。