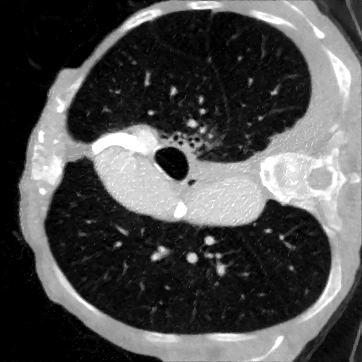

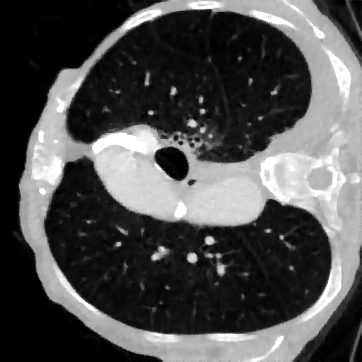

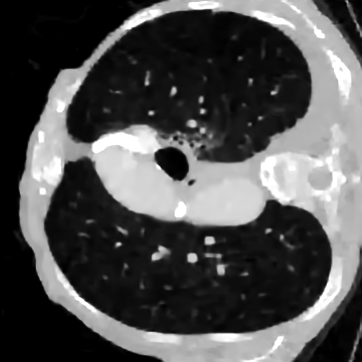

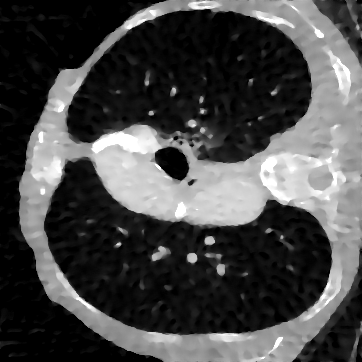

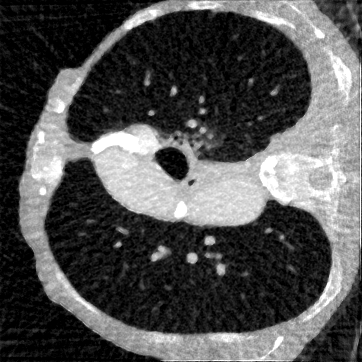

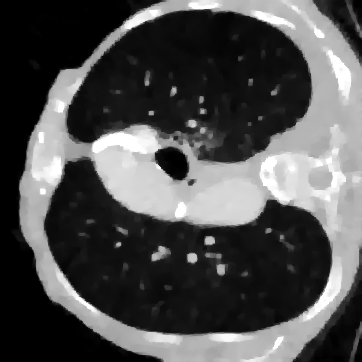

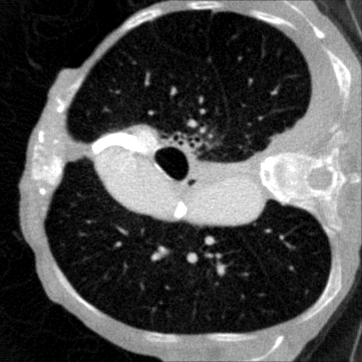

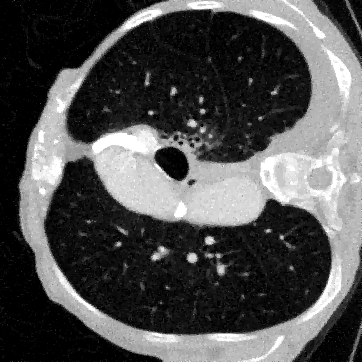

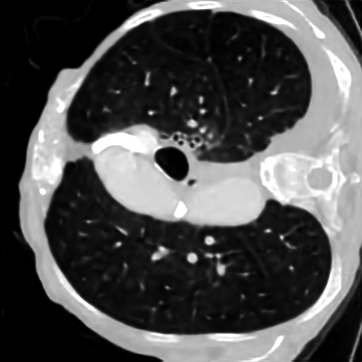

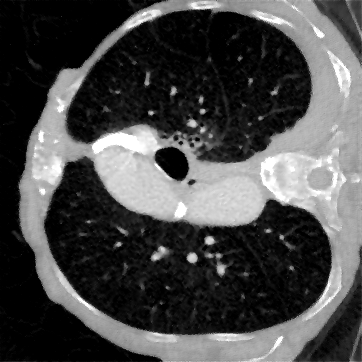

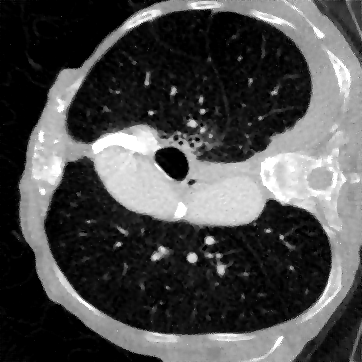

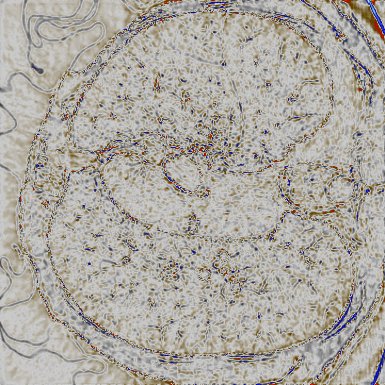

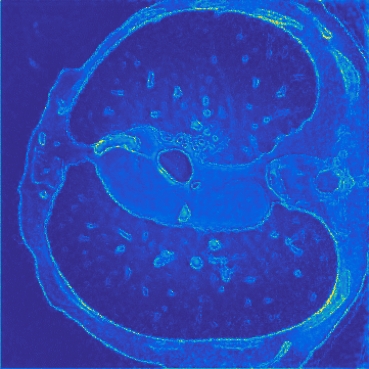

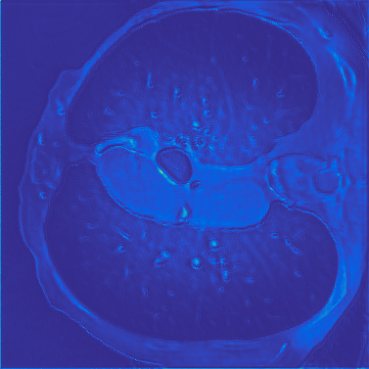

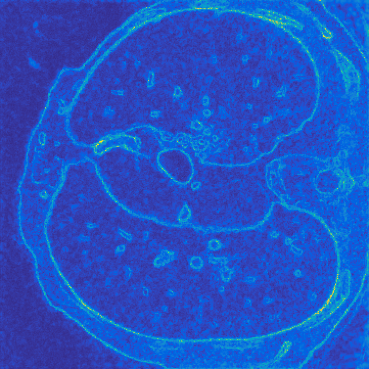

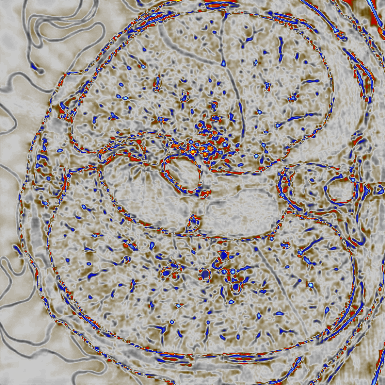

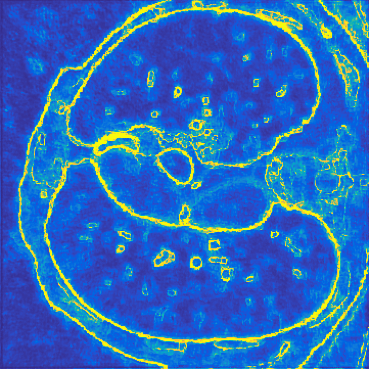

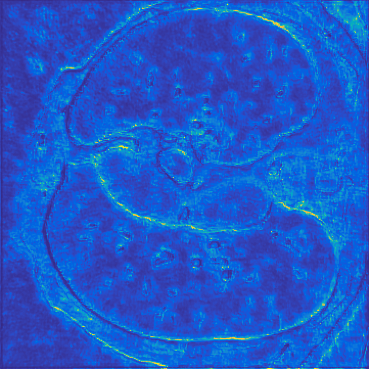

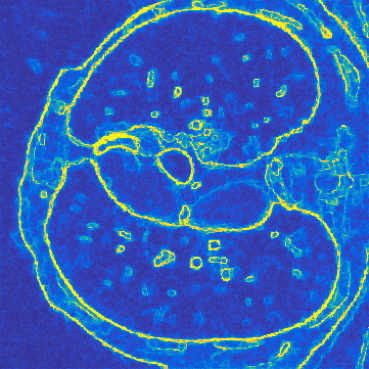

Deep learning-based image reconstruction approaches have demonstrated impressive empirical performance in many imaging modalities. These approaches generally require a large amount of high-quality training data, which is often not available. To circumvent this issue, we develop a novel unsupervised knowledge-transfer paradigm for learned iterative reconstruction within a Bayesian framework. The proposed approach learns an iterative reconstruction network in two phases. The first phase trains a reconstruction network with a set of ordered pairs comprising of ground truth images and measurement data. The second phase fine-tunes the pretrained network to the measurement data without supervision. Furthermore, the framework delivers uncertainty information over the reconstructed image. We present extensive experimental results on low-dose and sparse-view computed tomography, showing that the proposed framework significantly improves reconstruction quality not only visually, but also quantitatively in terms of PSNR and SSIM, and is competitive with several state-of-the-art supervised and unsupervised reconstruction techniques.

翻译:深层学习图像重建方法在许多成像模式中表现出了令人印象深刻的经验性表现,这些方法一般需要大量往往无法获得的高质量培训数据。为回避这一问题,我们为在巴伊西亚框架内进行学习的迭代重建开发开发了一种新的不受监督的知识转移模式。拟议方法分两个阶段学习了迭接重建网络。第一阶段培训重建网络,配有一套由地面真实图像和测量数据组成的定单配对。第二阶段对预先训练的网络进行微调,使其与未经监督的测量数据挂钩。此外,该框架还就重建后的图像提供了不确定信息。我们介绍了关于低剂量和少见的计算图象学的广泛实验结果,表明拟议的框架不仅在视觉上,而且在数量上大大改进了重建质量,而且在PSNR和SSIM方面,并且与一些最先进的、受监督和不受监督的、不受监督的重建技术具有竞争力。