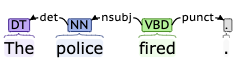

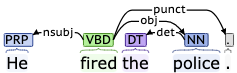

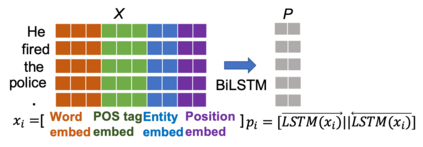

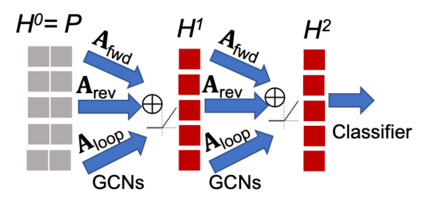

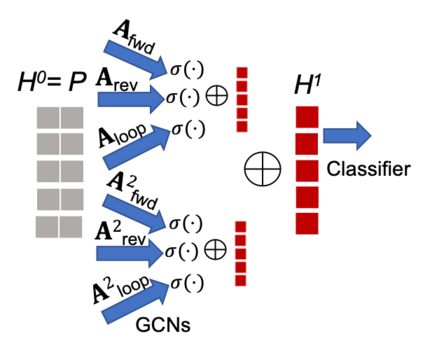

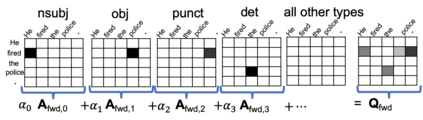

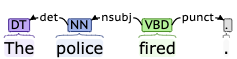

Recent works show that the graph structure of sentences, generated from dependency parsers, has potential for improving event detection. However, they often only leverage the edges (dependencies) between words, and discard the dependency labels (e.g., nominal-subject), treating the underlying graph edges as homogeneous. In this work, we propose a novel framework for incorporating both dependencies and their labels using a recently proposed technique called Graph Transformer Networks (GTN). We integrate GTNs to leverage dependency relations on two existing homogeneous-graph-based models, and demonstrate an improvement in the F1 score on the ACE dataset.

翻译:最近的工作表明,由依赖分析师生成的句子图表结构有可能改进事件探测。 但是,它们往往只是利用字词之间的边緣(依赖性),抛弃依赖性标签(如名义主体),将基本图形边緣作为同质处理。在这项工作中,我们提出了一个新颖的框架,将依赖性及其标签都纳入其中,使用最近提出的称为“图形变换者网络”的技术。我们整合了GTN,以利用现有两种单一绘图模型的依赖关系,并展示了ACE数据集F1分数的改善。