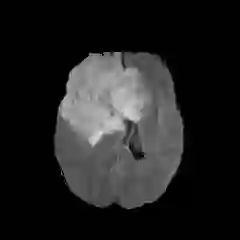

Automatic and accurate tumor segmentation on medical images is in high demand to assist physicians with diagnosis and treatment. However, it is difficult to obtain massive amounts of annotated training data required by the deep-learning models as the manual delineation process is often tedious and expertise required. Although self-supervised learning (SSL) scheme has been widely adopted to address this problem, most SSL methods focus only on global structure information, ignoring the key distinguishing features of tumor regions: local intensity variation and large size distribution. In this paper, we propose Scale-Aware Restoration (SAR), a SSL method for 3D tumor segmentation. Specifically, a novel proxy task, i.e. scale discrimination, is formulated to pre-train the 3D neural network combined with the self-restoration task. Thus, the pre-trained model learns multi-level local representations through multi-scale inputs. Moreover, an adversarial learning module is further introduced to learn modality invariant representations from multiple unlabeled source datasets. We demonstrate the effectiveness of our methods on two downstream tasks: i) Brain tumor segmentation, ii) Pancreas tumor segmentation. Compared with the state-of-the-art 3D SSL methods, our proposed approach can significantly improve the segmentation accuracy. Besides, we analyze its advantages from multiple perspectives such as data efficiency, performance, and convergence speed.

翻译:医疗图象上的自动和准确肿瘤分解是帮助医生诊断和治疗的高需求,然而,很难获得深学习模型所需的大量附加说明的培训数据,因为人工划定过程往往乏味,需要专门知识。尽管为解决这一问题,已经广泛采用了自我监督的学习(SSL)计划,但大多数SSL方法只侧重于全球结构信息,忽视肿瘤区域的主要特征:局部强度变化和大面积分布。本文提出SOSL(SAR),这是3D肿瘤分解的一种SSL方法。具体地说,设计了一个新的代用任务,即规模歧视,以预先将3D神经网络与自我重置任务结合起来。因此,预先培训的模型通过多尺度投入学习多层次的地方代表性。此外,还引入了一个对抗性学习模块,以学习多种无标签来源数据集的变异表达模式。我们展示了两种下游任务的方法的有效性:i)脑肿瘤分解、ii)Pancreas-剖析(SLA)的精度、3SL(SL)的精度分析方法,以及我们提议的SL(SL)的精度分析方法。