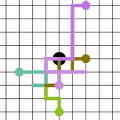

In recent years, graph neural networks (GNNs) have gained increasing popularity and have shown very promising results for data that are represented by graphs. The majority of GNN architectures are designed based on developing new convolutional and/or pooling layers that better extract the hidden and deeper representations of the graphs to be used for different prediction tasks. The inputs to these layers are mainly the three default descriptors of a graph, node features $(X)$, adjacency matrix $(A)$, and edge features $(W)$ (if available). To provide a more enriched input to the network, we propose a random walk data processing of the graphs based on three selected lengths. Namely, (regular) walks of length 1 and 2, and a fractional walk of length $\gamma \in (0,1)$, in order to capture the different local and global dynamics on the graphs. We also calculate the stationary distribution of each random walk, which is then used as a scaling factor for the initial node features ($X$). This way, for each graph, the network receives multiple adjacency matrices along with their individual weighting for the node features. We test our method on various molecular datasets by passing the processed node features to the network in order to perform several classification and regression tasks. Interestingly, our method, not using edge features which are heavily exploited in molecular graph learning, let a shallow network outperform well known deep GNNs.

翻译:近年来,图形神经网络(GNNS)越来越受欢迎,并展示了以图表表示的数据非常有希望的结果。GNN大多数结构的设计基础是开发新的进化和(或)集合层,以更好地提取用于不同预测任务的图表的隐藏和更深的表达面。对这些层的投入主要是一个图形的三个默认描述符,即节点特征$(X)美元、相近矩阵$(A)美元和边缘特征$(W)美元(如果有的话)。为了向网络提供更丰富的投入,我们建议对三个选定长度的图表进行随机步行数据处理。也就是说,(定期)长1和2行走,以及一个长度为$\gamma\ in (0,1,1美元)的分行行,以便捕捉图表上不同的本地和全球动态。我们还计算每次随机行走的固定分布,然后作为初始节点特征的缩放系数 $(X$) 。对于每个图表来说,我们建议以三个选定长度长度长度长度长度长度长度的图形进行随机流动数据处理。 网络将采用多种测量方法,我们用一些深度的深度的平面结构来测试数据顺序,我们用不同的平整方法来进行测试。