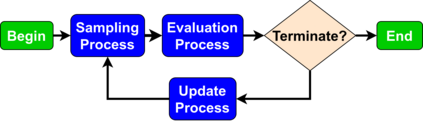

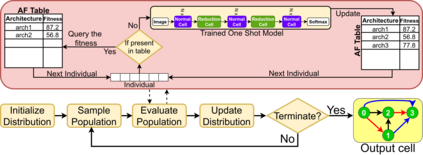

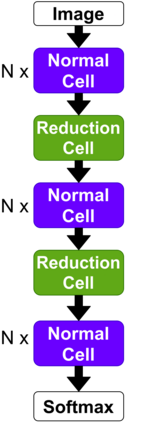

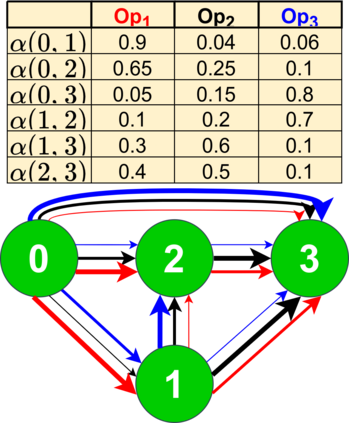

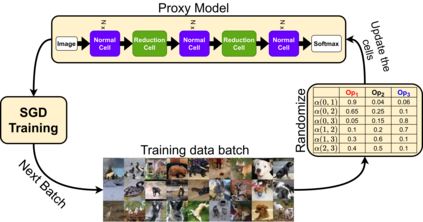

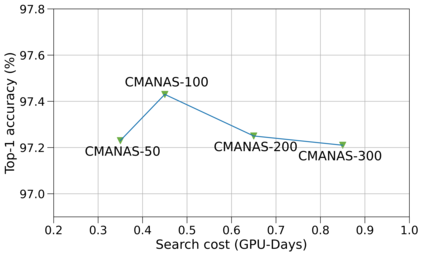

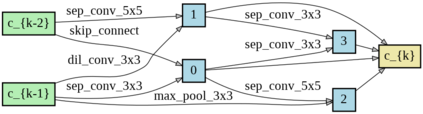

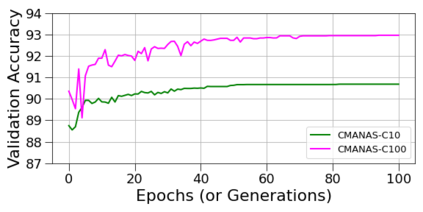

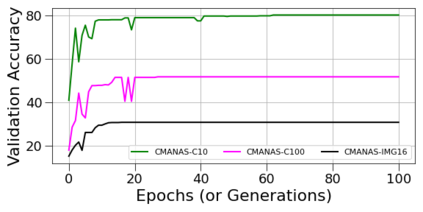

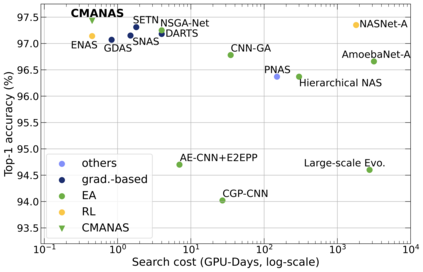

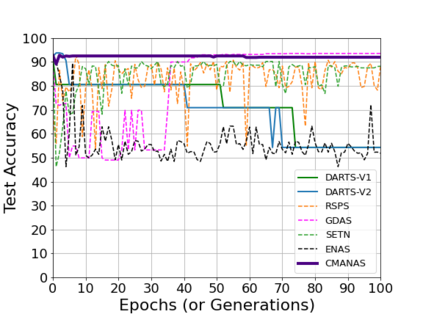

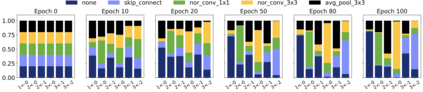

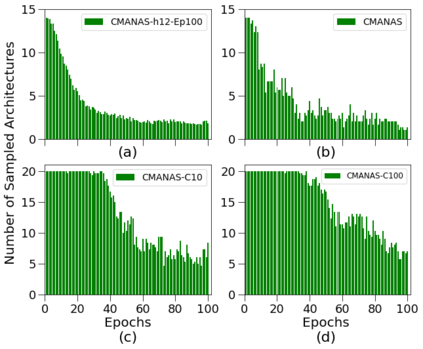

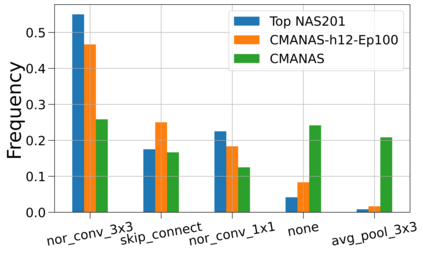

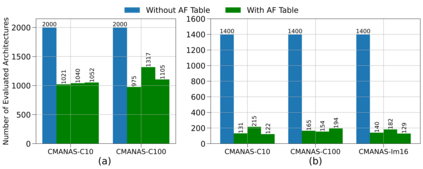

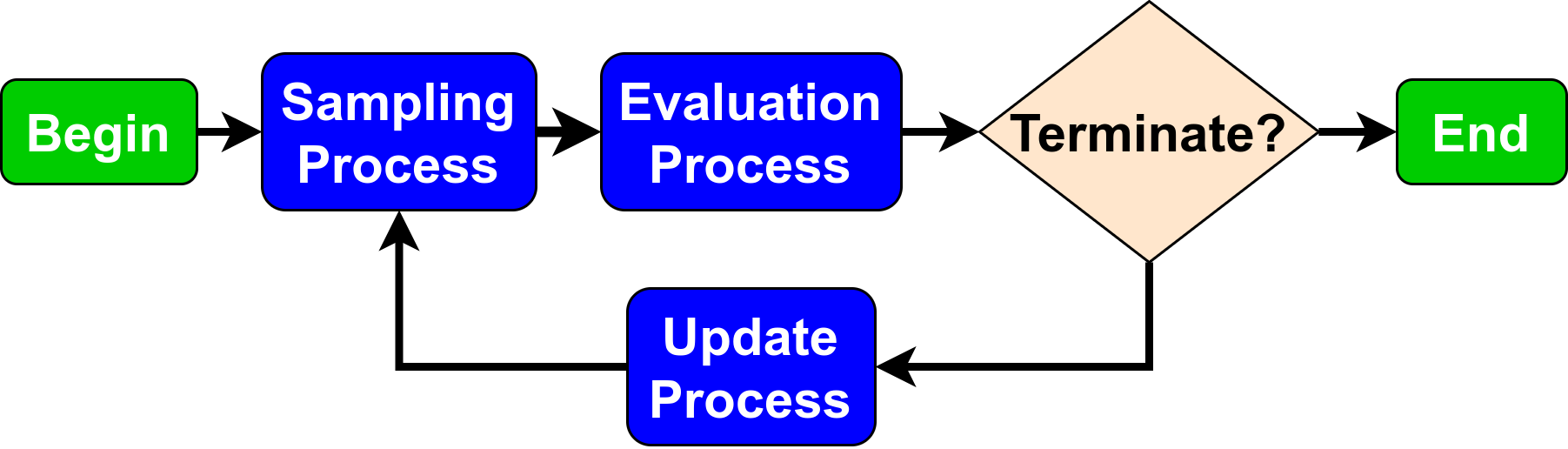

Evolution-based neural architecture search requires high computational resources, resulting in long search time. In this work, we propose a framework of applying the Covariance Matrix Adaptation Evolution Strategy (CMA-ES) to the neural architecture search problem called CMANAS, which achieves better results than previous evolution-based methods while reducing the search time significantly. The architectures are modelled using a normal distribution, which is updated using CMA-ES based on the fitness of the sampled population. We used the accuracy of a trained one shot model (OSM) on the validation data as a prediction of the fitness of an individual architecture to reduce the search time. We also used an architecture-fitness table (AF table) for keeping record of the already evaluated architecture, thus further reducing the search time. CMANAS finished the architecture search on CIFAR-10 with the top-1 test accuracy of 97.44% in 0.45 GPU day and on CIFAR-100 with the top-1 test accuracy of 83.24% for 0.6 GPU day on a single GPU. The top architectures from the searches on CIFAR-10 and CIFAR-100 were then transferred to ImageNet, achieving the top-5 accuracy of 92.6% and 92.1%, respectively.

翻译:基于进化的神经结构搜索需要大量计算资源,从而导致长时间的搜索时间。在这项工作中,我们提议了一个框架,将“共变矩阵适应进化战略”适用于神经结构搜索问题,称为“CMANAAS”,其结果优于先前的进化方法,同时大大缩短搜索时间。这些建筑采用正常分布模型,根据抽样人口是否适合,使用CMA-ES进行更新。我们使用经培训的验证数据中的一个测试模型(OSM)的准确性,作为个人结构是否适合的预测,以减少搜索时间。我们还使用一个适合建筑的表(AF)保存已经评估过的建筑结构的记录,从而进一步缩短了搜索时间。CMANAS完成了对CIFAR-10的建筑搜索,其上一级-1测试精确度为97.44%,0.45 GPU日为97.44%,CIFAR-100的上一级测试精度为83.24%,单一GPU日0.6的GPU日为83.24%。随后,对CIFAR-10和CIFAR-100的搜索的顶级结构结构被转移到了图像网络,分别达到92-5 %。