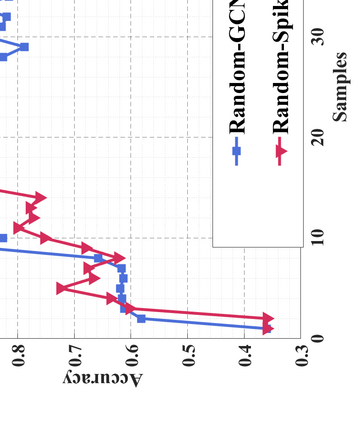

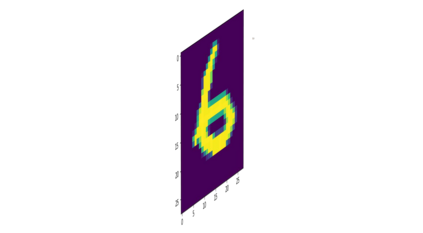

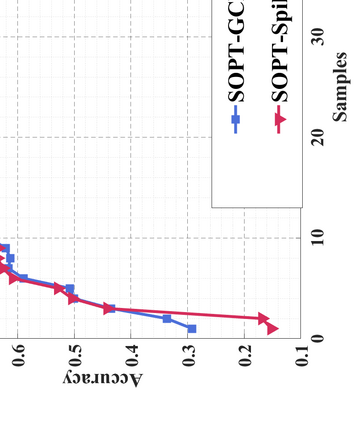

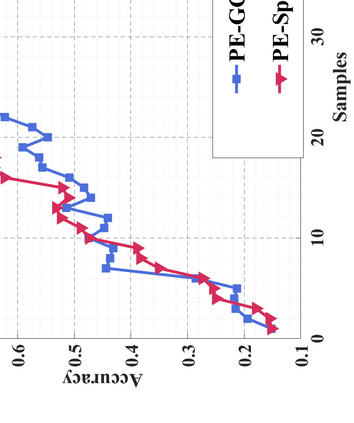

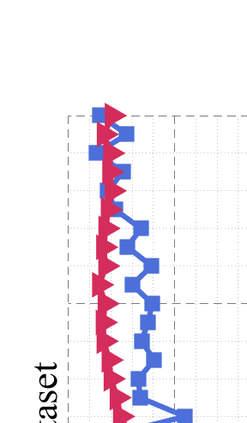

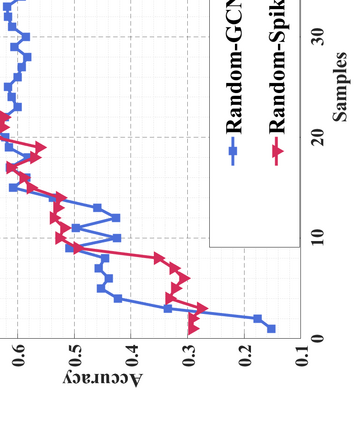

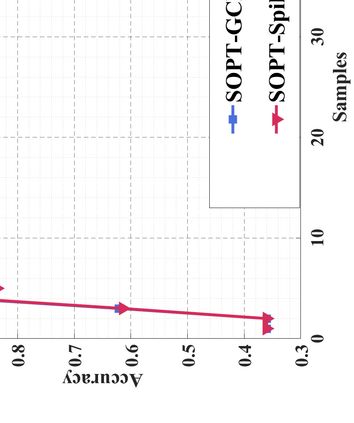

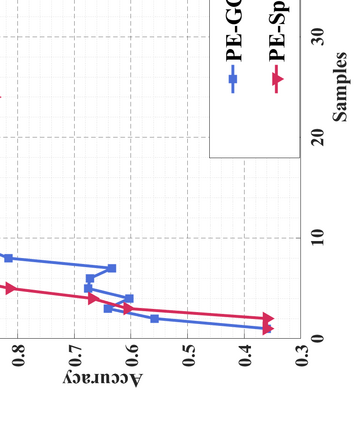

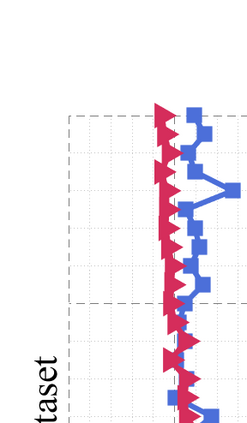

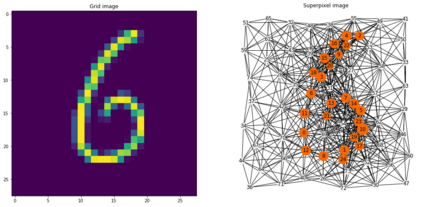

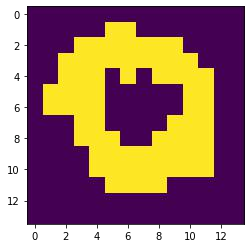

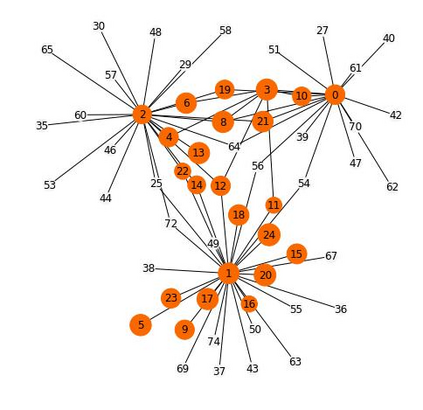

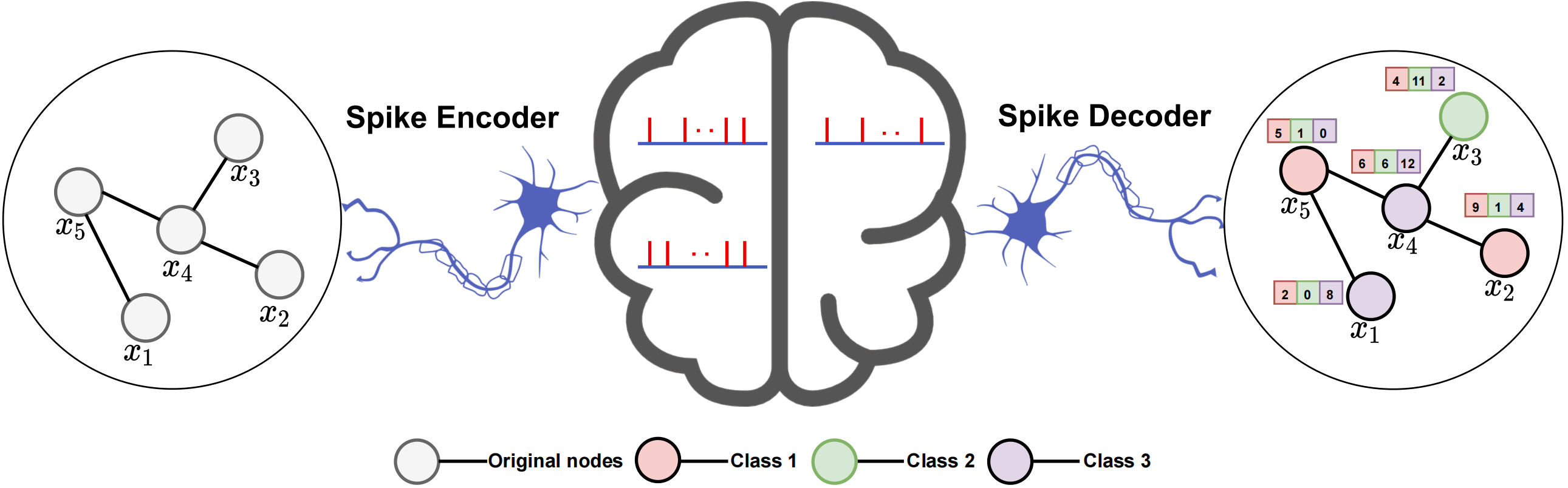

Graph Convolutional Networks (GCNs) achieve an impressive performance due to the remarkable representation ability in learning the graph information. However, GCNs, when implemented on a deep network, require expensive computation power, making them difficult to be deployed on battery-powered devices. In contrast, Spiking Neural Networks (SNNs), which perform a bio-fidelity inference process, offer an energy-efficient neural architecture. In this work, we propose SpikingGCN, an end-to-end framework that aims to integrate the embedding of GCNs with the biofidelity characteristics of SNNs. The original graph data are encoded into spike trains based on the incorporation of graph convolution. We further model biological information processing by utilizing a fully connected layer combined with neuron nodes. In a wide range of scenarios (e.g. citation networks, image graph classification, and recommender systems), our experimental results show that the proposed method could gain competitive performance against state-of-the-art approaches. Furthermore, we show that SpikingGCN on a neuromorphic chip can bring a clear advantage of energy efficiency into graph data analysis, which demonstrates its great potential to construct environment-friendly machine learning models.

翻译:由于在学习图表信息方面表现能力惊人,革命网络(GCNs)取得了令人印象深刻的成绩。然而,GCNs在深网络上实施时,需要昂贵的计算能力,使其难以被安装在电池动力装置上。相比之下,Spiking神经网络(SNNS)是一个生物纤维化推断过程,它提供了一个节能的神经结构。在这项工作中,我们提议SpikingGCN(SpikingGCN)是一个端到端框架,目的是将GCN与SNNS的生物纤维特性相结合。原始的图表数据在纳入图变变变模型的基础上被编码成顶峰值列列。我们进一步利用一个与神经节点相结合的完全相连的层来模拟生物信息处理。在广泛的情景中(例如:引力网络、图像图解分类和建议系统),我们的实验结果表明,拟议的方法可以取得竞争性表现。此外,我们显示SpikingGCN(SpikingGCN)能够将神经形态变形芯片的模型带来巨大的优势,从而将其潜在的数据模型转化为模型。