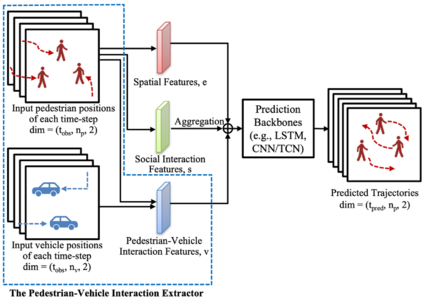

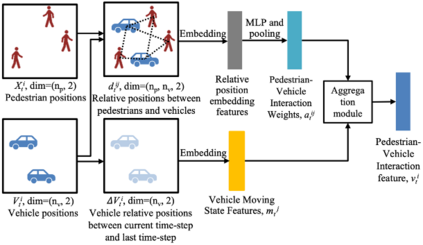

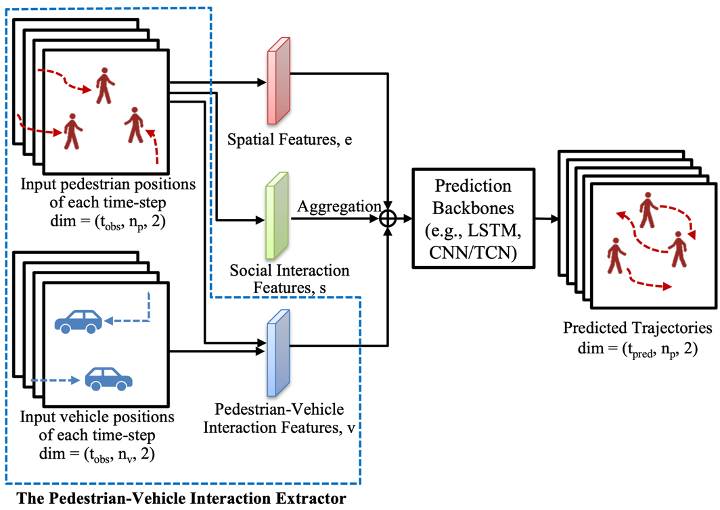

In this paper, we study the interaction between pedestrians and vehicles and propose a novel neural network structure called the Pedestrian-Vehicle Interaction (PVI) extractor for learning the pedestrian-vehicle interaction. We implement the proposed PVI extractor on both sequential approaches (long short-term memory (LSTM) models) and non-sequential approaches (convolutional models). We use the Waymo Open Dataset that contains real-world urban traffic scenes with both pedestrian and vehicle annotations. For the LSTM-based models, our proposed model is compared with Social-LSTM and Social-GAN, and using our proposed PVI extractor reduces the average displacement error (ADE) and the final displacement error (FDE) by 7.46% and 5.24%, respectively. For the convolutional-based models, our proposed model is compared with Social-STGCNN and Social-IWSTCNN, and using our proposed PVI extractor reduces the ADE and FDE by 2.10% and 1.27%, respectively. The results show that the pedestrian-vehicle interaction influences pedestrian behavior, and the models using the proposed PVI extractor can capture the interaction between pedestrians and vehicles, and thereby outperform the compared methods.

翻译:在本文中,我们研究了行人和车辆之间的互动,并提出了名为Pedestrian-Veclicultive(PVI)提取器的新型神经网络结构,以学习行人和车辆的互动。我们在相继方法(长短期内存模型)和非顺序方法(进化模型)上实施拟议的PVI提取器。我们使用Waymo Open数据集,该数据集包含真实的世界城市交通场以及行人和车辆的批注。对于基于LSTM的模型,我们提议的模型与社会-LSTM和社会-GAN比较,使用我们提议的PVI提取器将平均迁移错误(ADE)和最后迁移错误(FDE)分别减少7.46 %和5.24%。对于以革命为基础的模型,我们提议的模型与社会-STGCNNN和社交-IWESTCNNN进行了比较,并使用我们提议的PVI提取器将ADE和FDE分别减少2.10%和1.27%。结果显示,行人与行人行为的影响,以及使用拟议的机动车和车辆格式的模型。