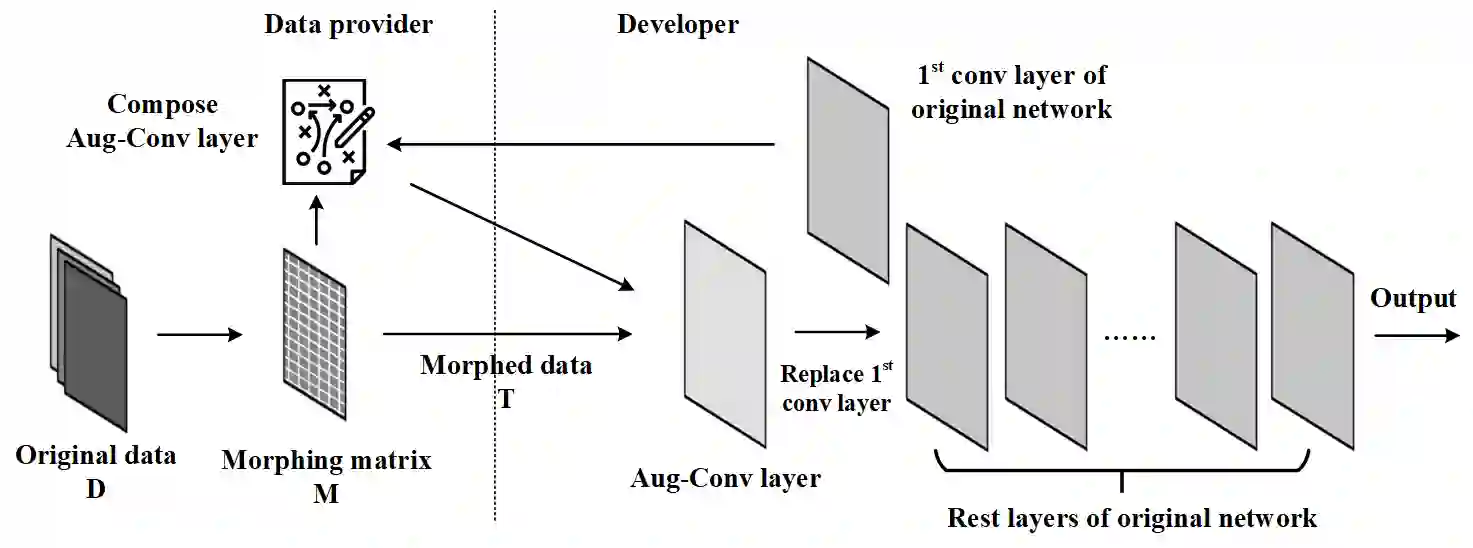

Privacy recently emerges as a severe concern in deep learning, that is, sensitive data must be prohibited from being shared with the third party during deep neural network development. In this paper, we propose Morphed Learning (MoLe), an efficient and secure scheme to deliver deep learning data. MoLe has two main components: data morphing and Augmented Convolutional (Aug-Conv) layer. Data morphing allows data providers to send morphed data without privacy information, while Aug-Conv layer helps deep learning developers to apply their networks on the morphed data without performance penalty. MoLe provides stronger security while introducing lower overhead compared to GAZELLE (USENIX Security 2018), which is another method with no performance penalty on the neural network. When using MoLe for VGG-16 network on CIFAR dataset, the computational overhead is only 9% and the data transmission overhead is 5.12%. As a comparison, GAZELLE has computational overhead of 10,000 times and data transmission overhead of 421,000 times. In this setting, the attack success rate of adversary is 7.9 x 10^{-90} for MoLe and 2.9 x 10^{-30} for GAZELLE, respectively.

翻译:最近,隐私作为深层学习中的一个严重关切,即敏感数据必须被禁止在深神经网络开发过程中与第三方共享。在本文中,我们提议采用摩菲学习(Mole),这是一个高效和安全的提供深层学习数据的办法。莫莱有两个主要组成部分:数据变形和增强革命(Aug-Conv)层。数据变形使数据提供者能够在没有隐私信息的情况下发送变形数据,而Aug-Conv层则帮助深层学习开发者在变形数据上应用其网络而无性能处罚。莫莱提供较强的安全,同时采用比GAZELLLL(USENIX Security 2018)低的顶部,这是神经网络上无性能处罚的另一种方法。如果在CIFAR数据集中使用摩莱用于VGG-16网络时,计算间接费用仅为9%,数据传输管理费为5.12 %。相比之下,GAZELLE的计算管理费为10 000次,数据传输管理费为421,000次。在这种环境下,敌方攻击成功率分别为7.9x10-90},而GALE x0.9xxx30}。