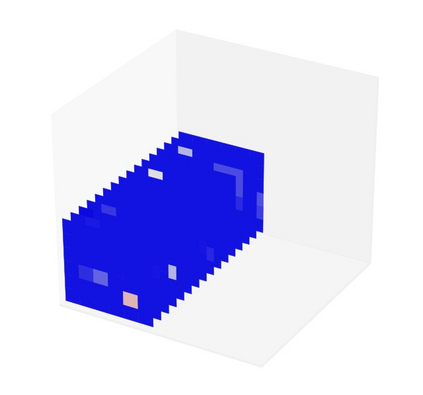

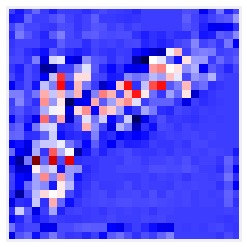

Many machine learning (ML) techniques suffer from the drawback that their output (e.g., a classification decision) is not clearly and intuitively connected to their input (e.g., an image). To cope with this issue, several explainable ML techniques have been proposed to, e.g., identify which pixels of an input image had the strongest influence on its classification. However, in distributed scenarios, it is often more important to connect decisions with the information used for the model training and the nodes supplying such information. To this end, in this paper we focus on federated learning and present a new methodology, named node liability in federated learning (NL-FL), which permits to identify the source of the training information that most contributed to a given decision. After discussing NL-FL's cost in terms of extra computation, storage, and network latency, we demonstrate its usefulness in an edge-based scenario. We find that NL-FL is able to swiftly identify misbehaving nodes and to exclude them from the training process, thereby improving learning accuracy.

翻译:许多机器学习(ML)技术的缺点是,它们的输出(如分类决定)与其输入(如图像)没有明确和直觉的联系。为了解决这一问题,提出了几种可解释的ML技术,例如,确定输入图像的哪些像素对其分类影响最大。但在分布式假设中,将决定与用于示范培训的信息和提供这种信息的节点联系起来往往更为重要。为此,我们在本文件中侧重于联合学习,并提出了一种新方法,在联合学习(NL-FL)中命名为节点责任,这种方法可以确定对某项决定贡献最大的培训信息来源。在讨论NL-FL在额外计算、储存和网络拉长方面的成本之后,我们展示了它在边缘情景中的用处。我们发现NL-FL能够迅速发现错误节点,并将它们排除在培训过程之外,从而提高学习的准确性。