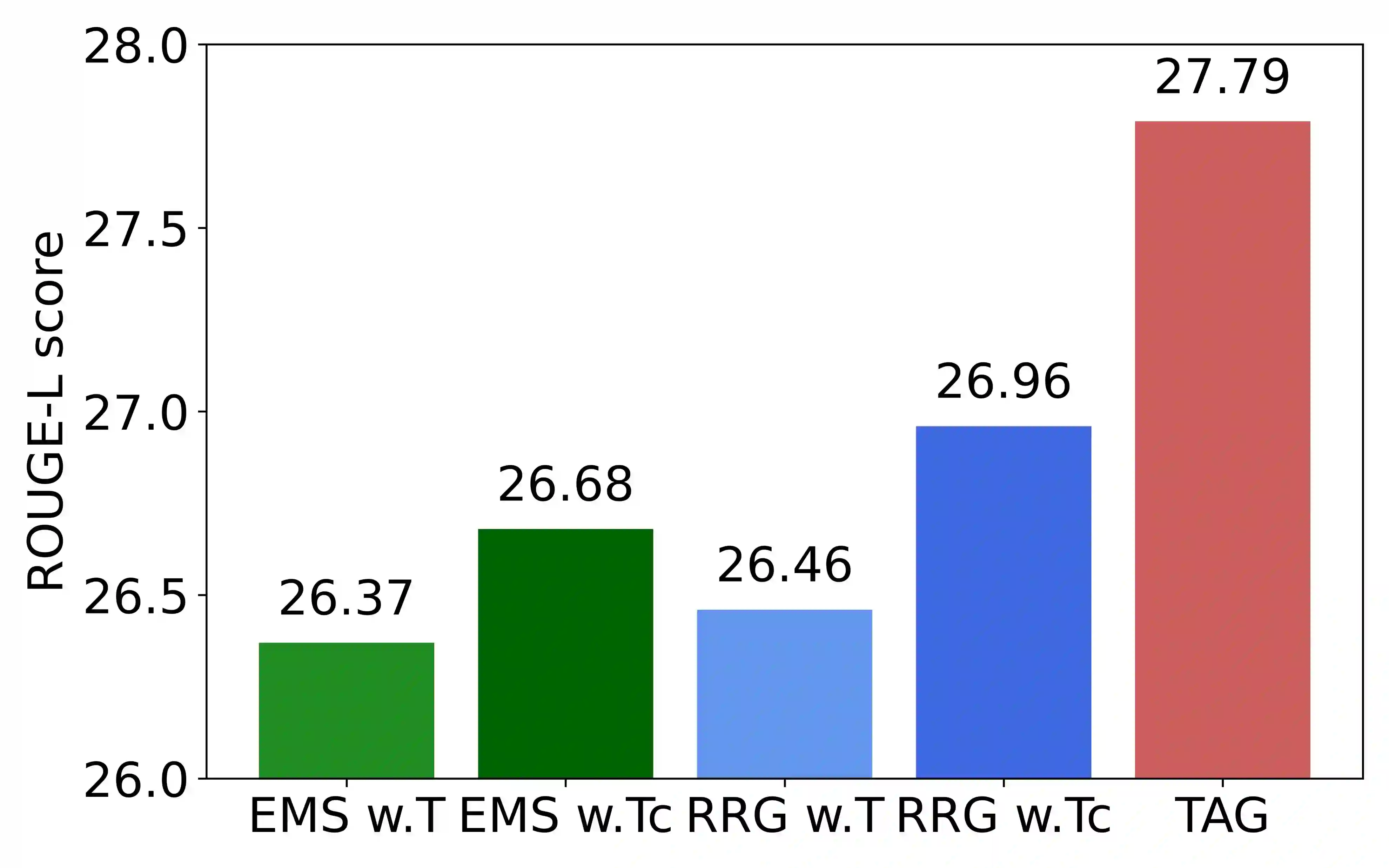

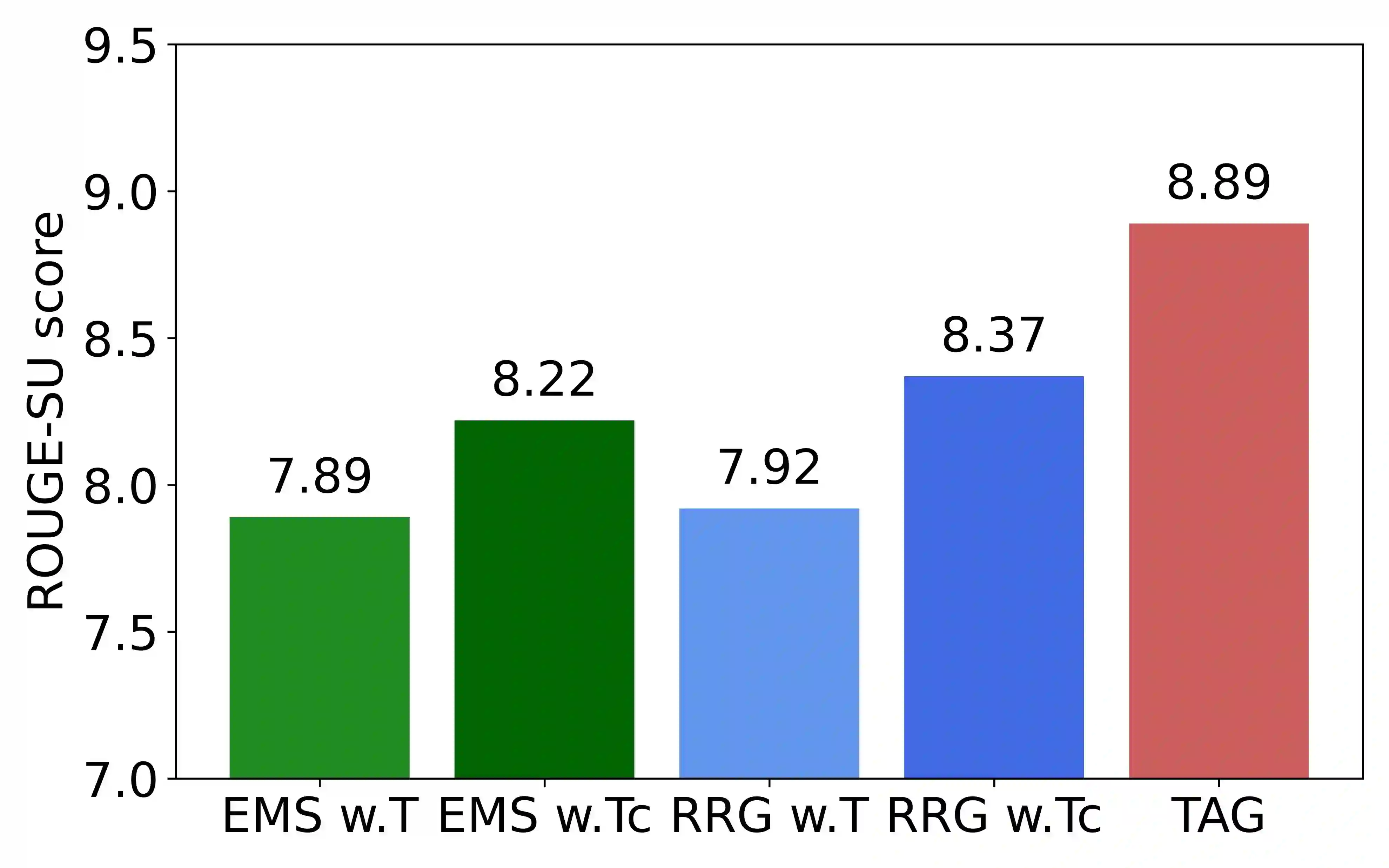

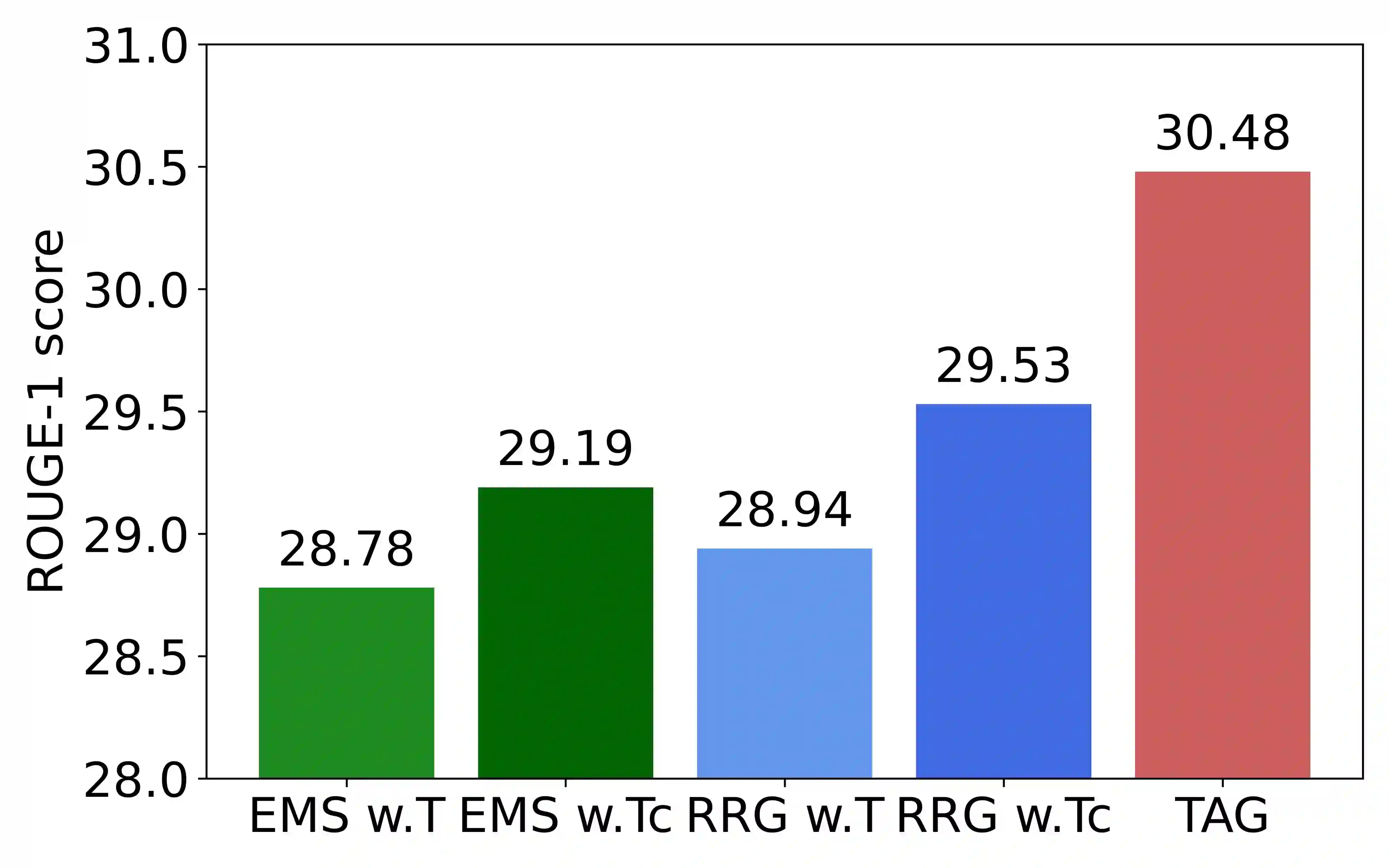

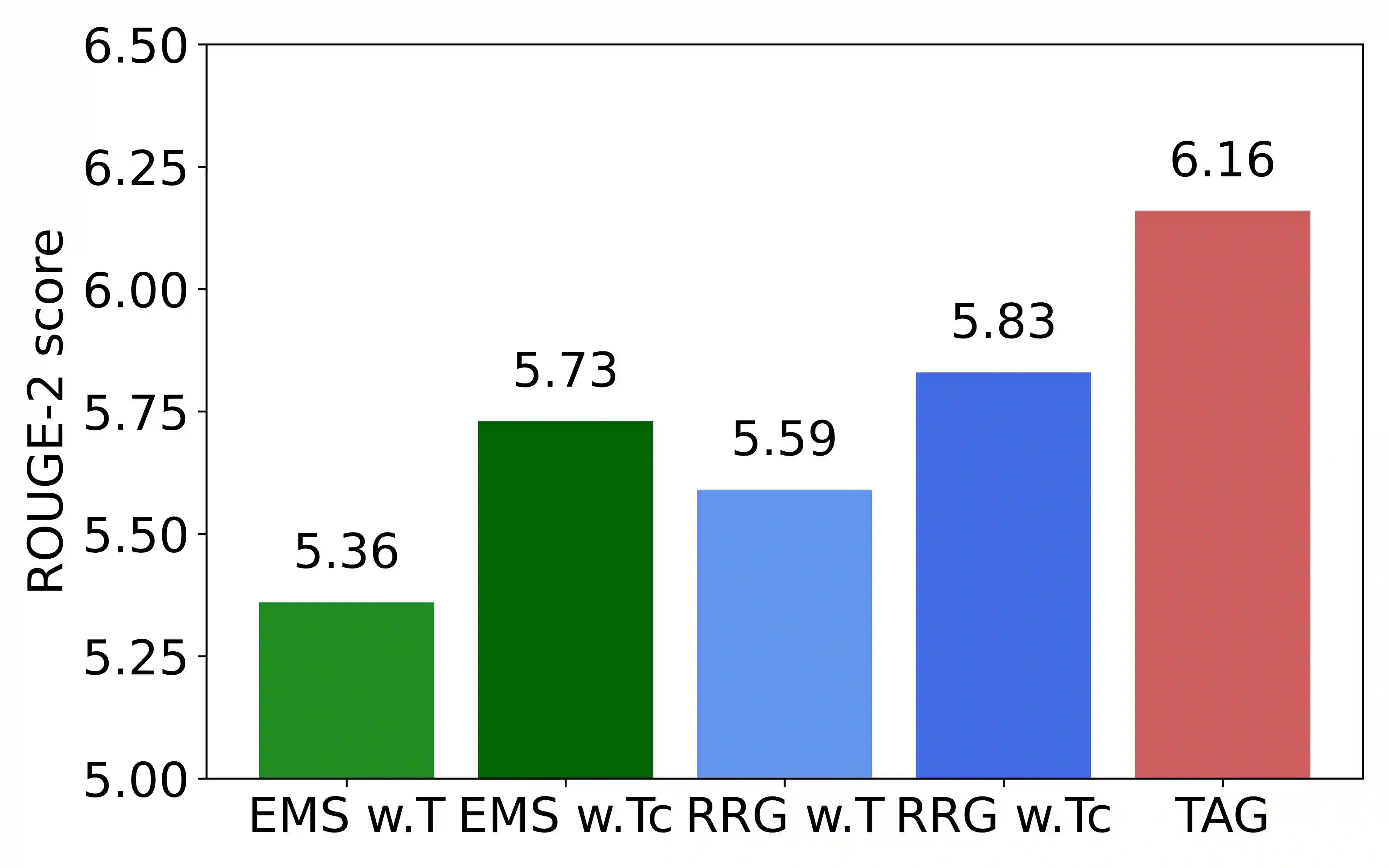

The related work section is an important component of a scientific paper, which highlights the contribution of the target paper in the context of the reference papers. Authors can save their time and effort by using the automatically generated related work section as a draft to complete the final related work. Most of the existing related work section generation methods rely on extracting off-the-shelf sentences to make a comparative discussion about the target work and the reference papers. However, such sentences need to be written in advance and are hard to obtain in practice. Hence, in this paper, we propose an abstractive target-aware related work generator (TAG), which can generate related work sections consisting of new sentences. Concretely, we first propose a target-aware graph encoder, which models the relationships between reference papers and the target paper with target-centered attention mechanisms. In the decoding process, we propose a hierarchical decoder that attends to the nodes of different levels in the graph with keyphrases as semantic indicators. Finally, to generate a more informative related work, we propose multi-level contrastive optimization objectives, which aim to maximize the mutual information between the generated related work with the references and minimize that with non-references. Extensive experiments on two public scholar datasets show that the proposed model brings substantial improvements over several strong baselines in terms of automatic and tailored human evaluations.

翻译:相关工作部分是一份科学文件的一个重要组成部分,该文件强调了目标文件在参考文件方面的贡献。作者们通过将自动生成的相关工作部分用作完成最终相关工作的草案,可以节省时间和精力。大多数现有相关工作部分的生成方法依靠提取现成的句子,对目标工作和参考文件进行比较讨论。然而,这些句子需要事先写成,在实践中很难获得。因此,我们在本文件中提议了一个抽象的目标感知相关工作生成器(TAG),它可以产生由新句组成的相关工作部分。具体地说,我们首先提出一个目标觉察图编码器,用以模拟参考文件和目标文件与目标中心关注机制的目标文件之间的关系。在解码过程中,我们建议一个等级解码器,用于图表中不同层次的节点,以关键词作为语句作为语义性指标。最后,我们提出一个多层次对比优化目标,目的是尽可能扩大所生成的、有目标觉察力的图表编码编码器。我们首先提出两个相关实验的相互信息,然后用最强的实验形式展示了相关基线的参考,并尽可能缩小了拟议中的若干基础性研究范围。