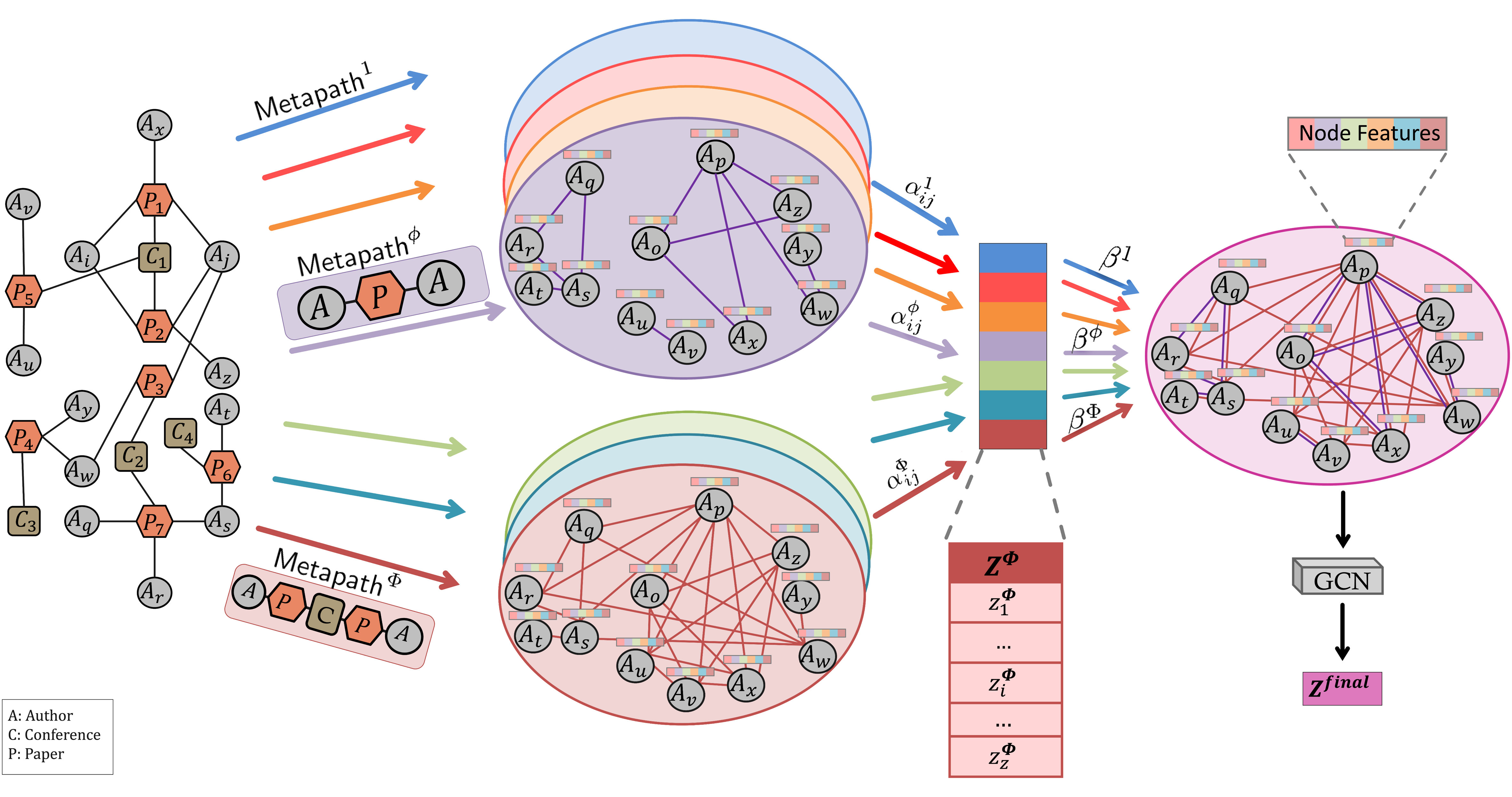

A large number of real-world networks include multiple types of nodes and edges. Graph Neural Network (GNN) emerged as a deep learning framework to utilize node features on graph-structured data showing superior performance. However, popular GNN-based architectures operate on one homogeneous network. Enabling them to work on multiple networks brings additional challenges due to the heterogeneity of the networks and the multiplicity of the existing associations. In this study, we present a computational approach named GRAF utilizing GNN-based approaches on multiple networks with the help of attention mechanisms and network fusion. Using attention-based neighborhood aggregation, GRAF learns the importance of each neighbor per node (called node-level attention) followed by the importance of association (called association-level attention) in a hierarchical way. Then, GRAF processes a network fusion step weighing each edge according to learned node- and association-level attention, which results in a fused enriched network. Considering that the fused network could be a highly dense network with many weak edges depending on the given input networks, we included an edge elimination step with respect to edges' weights. Finally, GRAF utilizes Graph Convolutional Network (GCN) on the fused network and incorporates the node features on the graph-structured data for the prediction task or any other downstream analysis. Our extensive evaluations of prediction tasks from different domains showed that GRAF outperformed the state-of-the-art methods. Utilization of learned node-level and association-level attention allowed us to prioritize the edges properly. The source code for our tool is publicly available at https://github.com/bozdaglab/GRAF.

翻译:大量实际网络包括多个类型的节点和边。基于图神经网络(GNN)的方法作为一种利用具有图形结构的数据节点特征的深度学习框架,表现出卓越的性能。然而,流行的基于GNN的架构仅操作一个均质网络。使它们在多个网络上工作带来额外的挑战,由于网络的异构性和现有关联的多样性。在本研究中,我们提出了一种名为GRAF的计算方法,利用基于GNN的方法在多个网络上,结合注意力机制和网络融合。利用基于注意力的邻域聚合,GRAF学习每个节点每个邻居的重要性(称为节点级别注意力),然后按层次结构学习关联(称为关联级别注意力)的重要性。然后,GRAF通过加权每个边的方式处理网络融合步骤,根据学习的节点级别和关联级别的注意力,得到融合丰富的网络。由于融合网络可以是高度密集的网络,具有许多弱边,这取决于给定的输入网络,因此我们包括一个边缘消除步骤来考虑边权重。最后,GRAF利用图卷积网络(GCN)在融合网络上,并将节点特征纳入基于图形结构的数据的预测任务或任何其他下游分析中。我们在不同领域的预测任务的广泛评估中表明,GRAF优于最先进的方法。利用学习的节点级和关联级别注意力,允许我们适当地优先考虑边缘。我们的工具源代码可在 https://github.com/bozdaglab/GRAF 上公开获得。