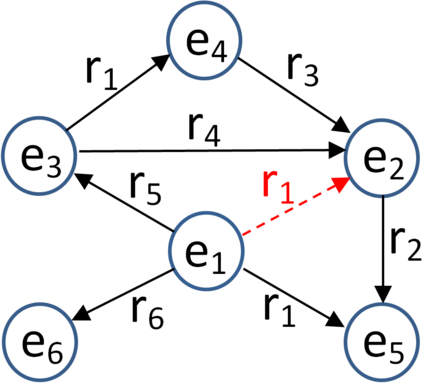

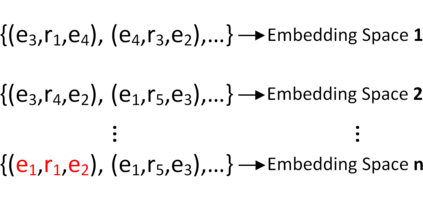

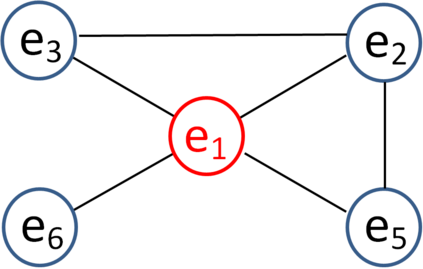

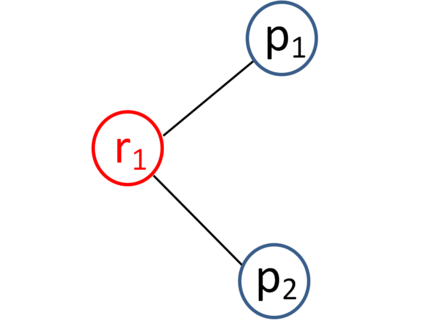

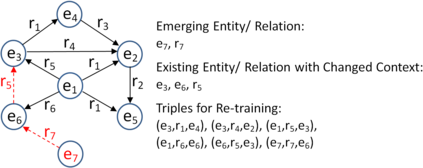

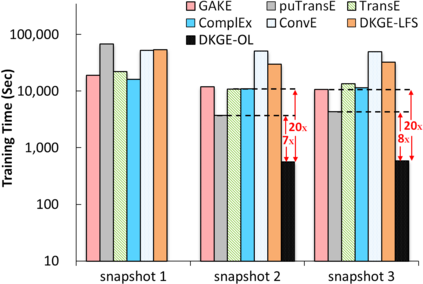

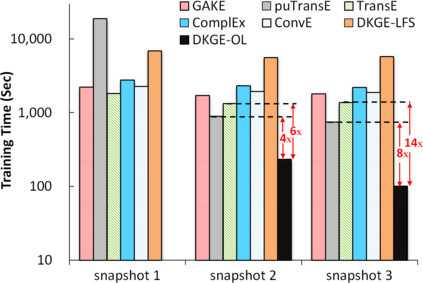

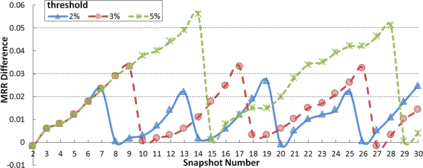

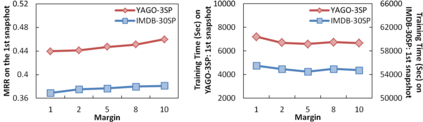

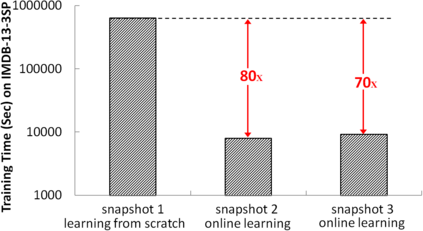

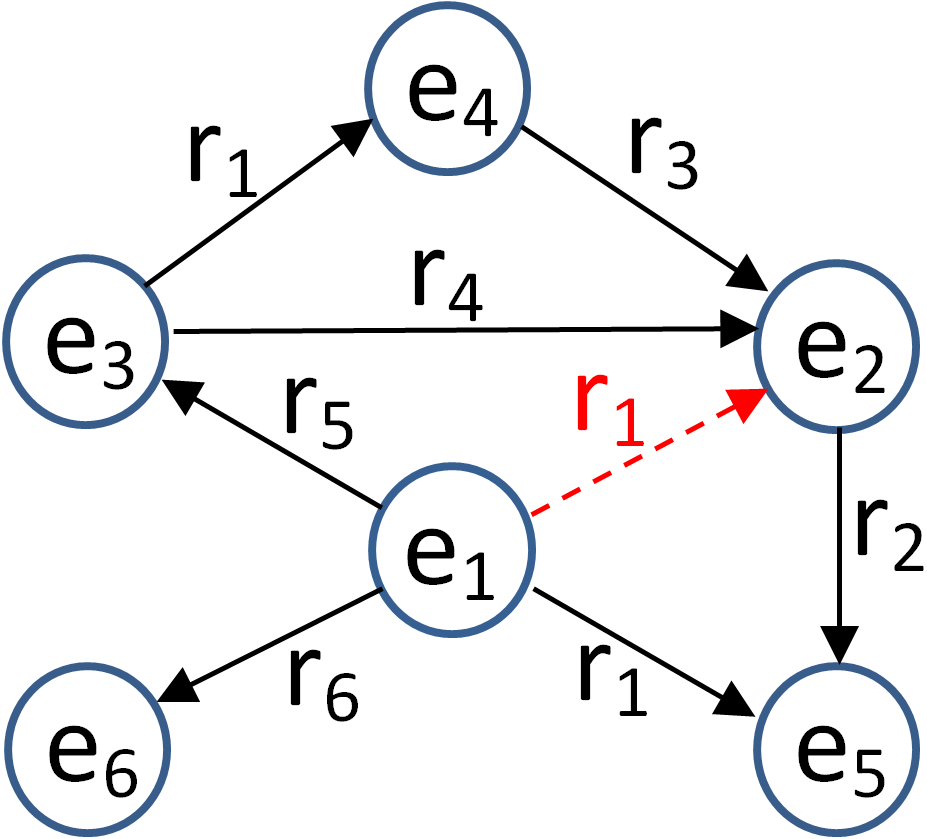

Knowledge graph (KG) embedding encodes the entities and relations from a KG into low-dimensional vector spaces to support various applications such as KG completion, question answering, and recommender systems. In real world, knowledge graphs (KGs) are dynamic and evolve over time with addition or deletion of triples. However, most existing models focus on embedding static KGs while neglecting dynamics. To adapt to the changes in a KG, these models need to be re-trained on the whole KG with a high time cost. In this paper, to tackle the aforementioned problem, we propose a new context-aware Dynamic Knowledge Graph Embedding (DKGE) method which supports the embedding learning in an online fashion. DKGE introduces two different representations (i.e., knowledge embedding and contextual element embedding) for each entity and each relation, in the joint modeling of entities and relations as well as their contexts, by employing two attentive graph convolutional networks, a gate strategy, and translation operations. This effectively helps limit the impacts of a KG update in certain regions, not in the entire graph, so that DKGE can rapidly acquire the updated KG embedding by a proposed online learning algorithm. Furthermore, DKGE can also learn KG embedding from scratch. Experiments on the tasks of link prediction and question answering in a dynamic environment demonstrate the effectiveness and efficiency of DKGE.

翻译:知识图形( KG) 嵌入将实体和关系从 KG 嵌入到低维矢量空间的知识图形( KG), 以支持 KG 完成、 问答、 推荐系统等各种应用。 在现实世界中, 知识图形( KG) 是动态的, 并随着时间的增加或删除而演变。 然而, 大多数现有模型侧重于嵌入静态的 KG, 同时忽略动态。 为了适应KG 的变化, 这些模型需要在整个 KG 上重新接受培训, 花费很高的时间。 在本文中, 为了解决上述问题, 我们提出了一种新的有环境觉悟的动态知识图形嵌入式( DKGE) 方法, 支持以在线方式嵌入学习。 在实体和关系联合建模时, 这些模型侧重于嵌入静态的 KGGG 和背景, 需要使用两个细微的图形革命网络、 门端策略和翻译操作。 这有效地帮助限制 KGG 更新了某些区域的K 更新影响, 而不是在整个图表中嵌入 。 因此, DGEGE 快速地学习了 K 快速的K 快速的定位, 学习了 K 。