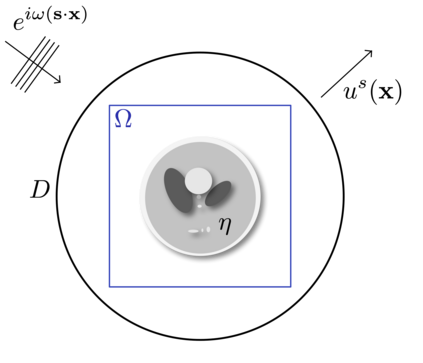

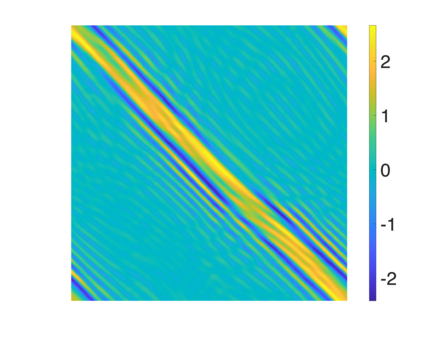

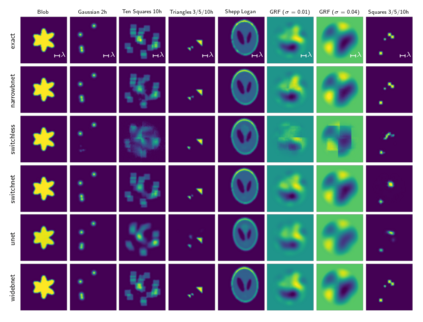

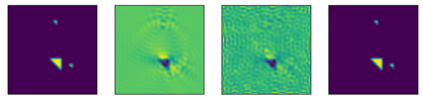

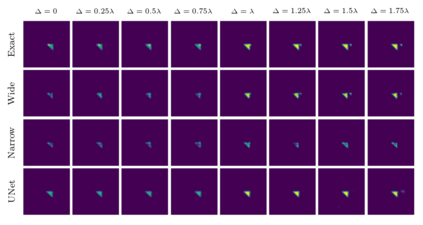

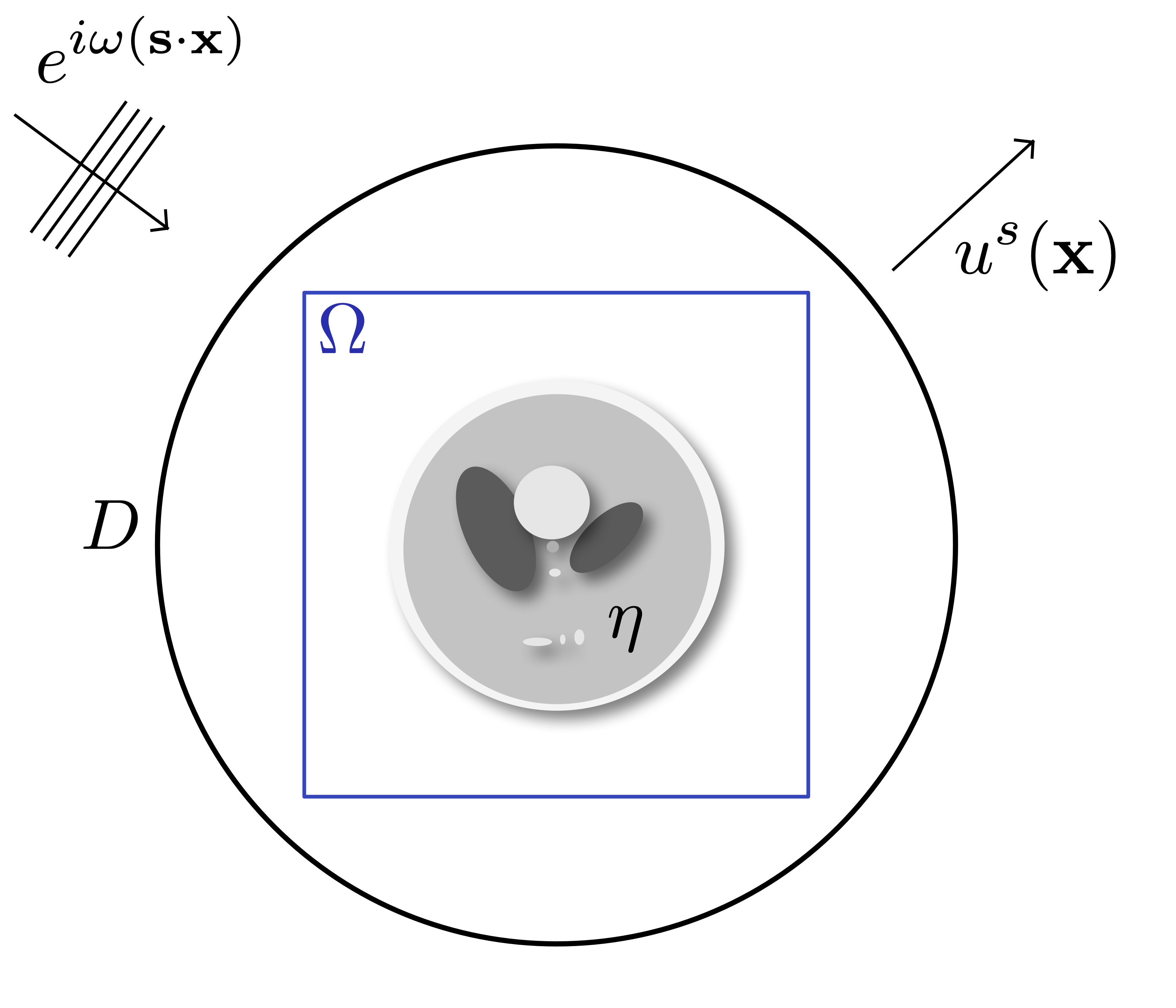

We propose an end-to-end deep learning framework that comprehensively solves the inverse wave scattering problem across all length scales. Our framework consists of the newly introduced wide-band butterfly network coupled with a simple training procedure that dynamically injects noise during training. While our trained network provides competitive results in classical imaging regimes, most notably it also succeeds in the super-resolution regime where other comparable methods fail. This encompasses both (i) reconstruction of scatterers with sub-wavelength geometric features, and (ii) accurate imaging when two or more scatterers are separated by less than the classical diffraction limit. We demonstrate these properties are retained even in the presence of strong noise and extend to scatterers not previously seen in the training set. In addition, our network is straightforward to train requiring no restarts and has an online runtime that is an order of magnitude faster than optimization-based algorithms. We perform experiments with a variety of wave scattering mediums and we demonstrate that our proposed framework outperforms both classical inversion and competing network architectures that specialize in oscillatory wave scattering data.

翻译:我们建议一个端到端深学习框架,全面解决各长尺度的反波散射问题。我们的框架包括新引入的宽频蝴蝶网络,以及一个简单的培训程序,在培训期间动态地注入噪音。虽然我们受过训练的网络在古典成像系统中提供了竞争性的结果,最显著的是在其他类似方法失败的超分辨率系统中也取得成功。这包括:(一)重建具有亚波长几何特征的散射器,以及(二)精确的成像,如果两个或两个以上的散射器被少于古典散射限隔开。我们证明这些特性即使在有强烈的噪音的情况下也保留下来,并扩大到培训成套中未曾见过的散射器。此外,我们的网络直截了当培训不需要重新启动,而且有一个在线运行时间比优化式算法要快得多的规模。我们用各种波散射介质进行实验,我们证明我们提议的框架超越了典型的反向和相互竞争的网络结构,这些结构是专门用于流波散射数据的。