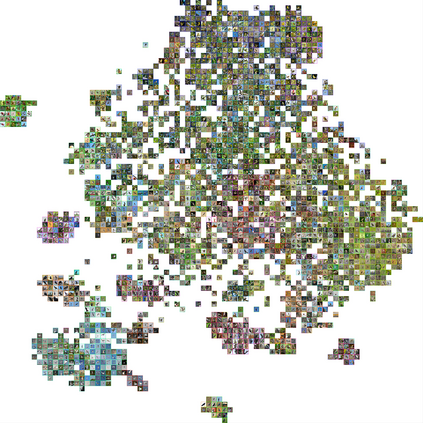

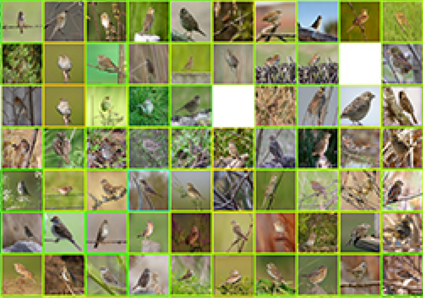

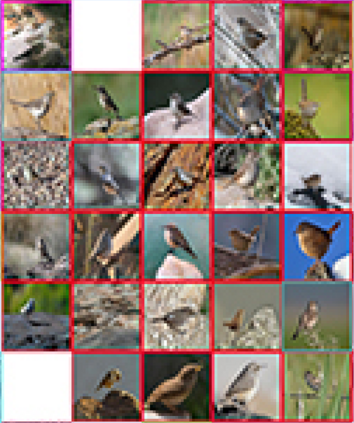

This paper presents a hardness-aware deep metric learning (HDML) framework. Most previous deep metric learning methods employ the hard negative mining strategy to alleviate the lack of informative samples for training. However, this mining strategy only utilizes a subset of training data, which may not be enough to characterize the global geometry of the embedding space comprehensively. To address this problem, we perform linear interpolation on embeddings to adaptively manipulate their hard levels and generate corresponding label-preserving synthetics for recycled training, so that information buried in all samples can be fully exploited and the metric is always challenged with proper difficulty. Our method achieves very competitive performance on the widely used CUB-200-2011, Cars196, and Stanford Online Products datasets.

翻译:本文介绍了一个硬度认知深度衡量学习(HDML)框架。以往的多数深度衡量学习方法都采用硬度负面采矿战略来缓解缺乏信息丰富的培训样本的情况。然而,这一采矿战略只使用一组培训数据,这些数据可能不足以全面描述嵌入空间的全球几何特征。为解决这一问题,我们在嵌入中进行线性内插,以适应性地操纵其硬度,并生成相应的贴标签合成材料用于再生培训,以便所有样品中埋藏的信息都能得到充分利用,衡量标准总是有适当的困难。我们的方法在广泛使用的CUB-200-2011、Cars196和斯坦福在线产品数据集上取得了非常有竞争力的业绩。