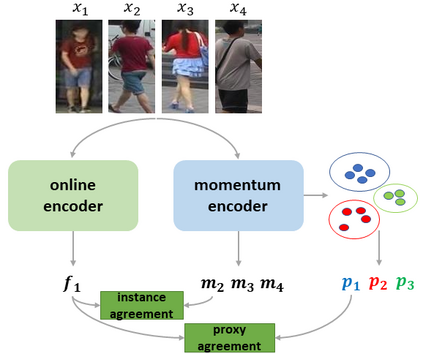

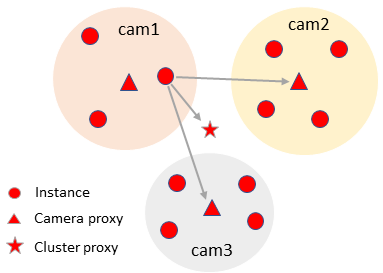

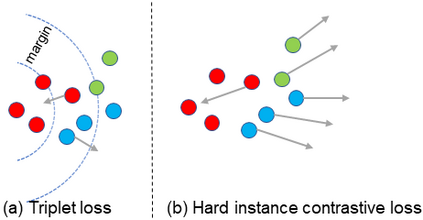

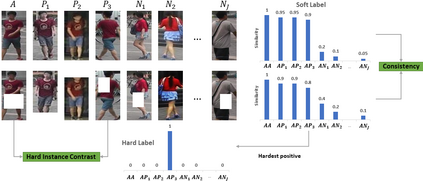

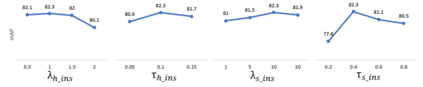

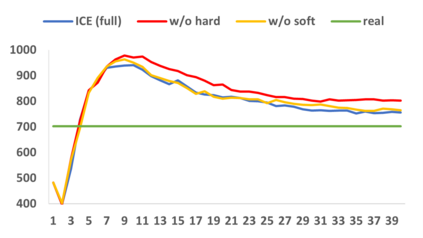

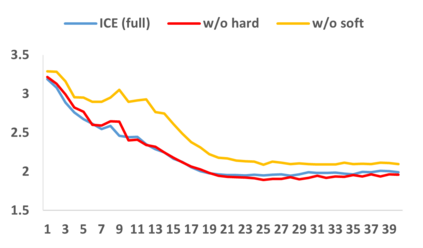

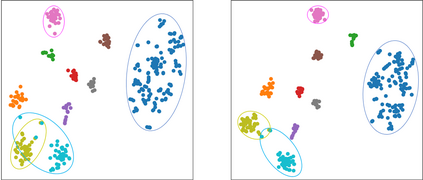

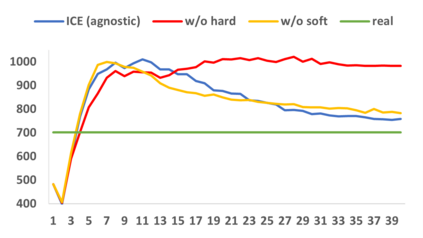

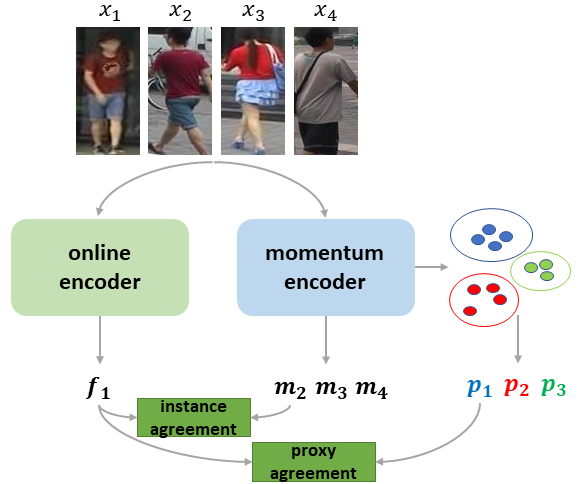

Unsupervised person re-identification (ReID) aims at learning discriminative identity features without annotations. Recently, self-supervised contrastive learning has gained increasing attention for its effectiveness in unsupervised representation learning. The main idea of instance contrastive learning is to match a same instance in different augmented views. However, the relationship between different instances of a same identity has not been explored in previous methods, leading to sub-optimal ReID performance. To address this issue, we propose Inter-instance Contrastive Encoding (ICE) that leverages inter-instance pairwise similarity scores to boost previous class-level contrastive ReID methods. We first use pairwise similarity ranking as one-hot hard pseudo labels for hard instance contrast, which aims at reducing intra-class variance. Then, we use similarity scores as soft pseudo labels to enhance the consistency between augmented and original views, which makes our model more robust to augmentation perturbations. Experiments on several large-scale person ReID datasets validate the effectiveness of our proposed unsupervised method ICE, which is competitive with even supervised methods.

翻译:未经监督的人重新身份识别( ReID) 旨在学习没有附加说明的歧视性身份特征。 最近, 自我监督的对比性学习在未经监督的演示学习中提高了对其有效性的关注度。 实例对比性学习的主要理念是在不同扩大的观点中匹配同一实例。 但是, 先前的方法没有探讨同一身份的不同实例之间的关系, 导致次优的 ReID性表现。 为了解决这个问题, 我们提议利用 Internance 相匹配编码(ICE) 来利用 Internance 相近性分数来提升先前的等级对比性 ReID方法。 我们首先将相似性排序配对为用于硬性对比的单热硬假标签, 目的是减少类内部差异。 然后, 我们用类似性评分作为软假标签, 来增强增强增强强化和原始观点的一致性, 这使得我们的模型更加强大到增强性扰动性。 实验了几个大型的人 ReID 数据设置验证了我们提议的未经监督的ICE方法的有效性, 这种方法甚至具有竞争性 。