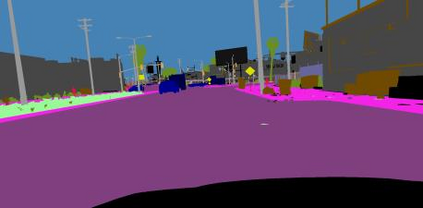

Unsupervised domain adaptation in semantic segmentation has been raised to alleviate the reliance on expensive pixel-wise annotations. It leverages a labeled source domain dataset as well as unlabeled target domain images to learn a segmentation network. In this paper, we observe two main issues of the existing domain-invariant learning framework. (1) Being distracted by the feature distribution alignment, the network cannot focus on the segmentation task. (2) Fitting source domain data well would compromise the target domain performance. To address these issues, we propose DecoupleNet that alleviates source domain overfitting and enables the final model to focus more on the segmentation task. Furthermore, we put forward Self-Discrimination (SD) and introduce an auxiliary classifier to learn more discriminative target domain features with pseudo labels. Finally, we propose Online Enhanced Self-Training (OEST) to contextually enhance the quality of pseudo labels in an online manner. Experiments show our method outperforms existing state-of-the-art methods, and extensive ablation studies verify the effectiveness of each component. Code is available at https://github.com/dvlab-research/DecoupleNet.

翻译:为了减轻对昂贵的像素域域数据集和未贴标签的目标域图的依赖,在语义分区中提出了不受监督的域适应办法,以缓解对昂贵的像素界别说明的依赖。它利用了一个标签源域数据集和未贴标签的目标域图来学习分割网。在本文件中,我们观察了现有的域-异性学习框架的两个主要问题。(1)由于特性分布对齐,网络无法专注于分层任务。(2) 匹配源域数据将很好地影响目标域域的性能。为解决这些问题,我们建议DecoupleNet减轻对源域的过度配置,并使最终模型能够更加注重分层任务。此外,我们提出自我歧视(SD),并引入一个辅助分类器,以学习带有假标签的更具有歧视性的目标域特性。最后,我们提议在线增强自我训练(OEST)以在线方式从环境角度提高伪标签的质量。实验显示我们的方法超越了现有的艺术状态方法,并广泛进行对比研究,以核实每个组成部分的有效性。代码可在https://githbub.com/devlab-de-degralation/Decreasearch.