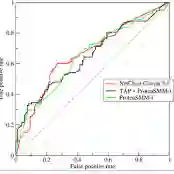

A common yet challenging scenario in periocular biometrics is cross-spectral matching - in particular, the matching of visible wavelength against near-infrared (NIR) periocular images. We propose a novel approach to cross-spectral periocular verification that primarily focuses on learning a mapping from visible and NIR periocular images to a shared latent representational subspace, and supports this effort by simultaneously learning intra-spectral image reconstruction. We show the auxiliary image reconstruction task (and in particular the reconstruction of high-level, semantic features) results in learning a more discriminative, domain-invariant subspace compared to the baseline while incurring no additional computational or memory costs at test-time. The proposed Coupled Conditional Generative Adversarial Network (CoGAN) architecture uses paired generator networks (one operating on visible images and the other on NIR) composed of U-Nets with ResNet-18 encoders trained for feature learning via contrastive loss and for intra-spectral image reconstruction with adversarial, pixel-based, and perceptual reconstruction losses. Moreover, the proposed CoGAN model beats the current state-of-art (SotA) in cross-spectral periocular recognition. On the Hong Kong PolyU benchmark dataset, we achieve 98.65% AUC and 5.14% EER compared to the SotA EER of 8.02%. On the Cross-Eyed dataset, we achieve 99.31% AUC and 3.99% EER versus SotA EER of 4.39%.

翻译:透视生物测定中常见但具有挑战性的情景是跨光谱匹配,特别是可见波长与近红外(NIR)透视图像相匹配。我们提出跨光谱透视核查的新办法,主要侧重于从可见和NIR透视图像到共享潜在代表子空间的映射,支持这一努力,同时学习光谱内图像重建。我们展示了辅助图像重建任务(特别是高层次、语义特征的重建),结果与基线相比,学习了更具有歧视性的、域性变化的子空间,而测试时则没有产生额外的计算或记忆成本。拟议的双光谱透视透视透视系统(CoGAN)结构使用配对式发电机网络(一个在可见图像上运行,另一个在NIR),这些网络由ResNet-18电图解码组成,通过对比性损失学习特征,以及光谱内图象重建与对等、平流基和感知性重建损失。此外,拟议的COAN-ER-ER-ER-99在测试时没有额外的计算或存储ER-ER-ER-ER-ER-IL ER-C-I-I-C-C-C-IL-IL 5A数据,在目前状态数据中,在SBA-IB-IB-I-IB-IB-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I-I