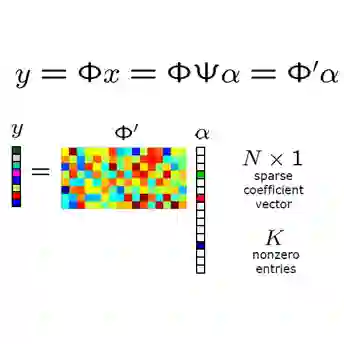

Mapping a truncated optimization method into a deep neural network, deep unfolding network (DUN) has attracted growing attention in compressive sensing (CS) due to its good interpretability and high performance. Each stage in DUNs corresponds to one iteration in optimization. By understanding DUNs from the perspective of the human brain's memory processing, we find there exists two issues in existing DUNs. One is the information between every two adjacent stages, which can be regarded as short-term memory, is usually lost seriously. The other is no explicit mechanism to ensure that the previous stages affect the current stage, which means memory is easily forgotten. To solve these issues, in this paper, a novel DUN with persistent memory for CS is proposed, dubbed Memory-Augmented Deep Unfolding Network (MADUN). We design a memory-augmented proximal mapping module (MAPMM) by combining two types of memory augmentation mechanisms, namely High-throughput Short-term Memory (HSM) and Cross-stage Long-term Memory (CLM). HSM is exploited to allow DUNs to transmit multi-channel short-term memory, which greatly reduces information loss between adjacent stages. CLM is utilized to develop the dependency of deep information across cascading stages, which greatly enhances network representation capability. Extensive CS experiments on natural and MR images show that with the strong ability to maintain and balance information our MADUN outperforms existing state-of-the-art methods by a large margin. The source code is available at https://github.com/jianzhangcs/MADUN/.

翻译:将悬浮优化方法映射成一个深度神经网络,深处的网络(DUN)由于其可读性和高性能,在压缩感应中日益引起人们的注意。 DUN的每个阶段都对应一个优化的迭代。通过从人类大脑记忆处理的角度理解DUN,我们发现现有DUN存在两个问题。一个是每个相邻阶段之间的信息,可被视为短期记忆,通常会严重丢失。另一个不是确保前几个阶段影响当前阶段的明确机制,这意味着记忆很容易被遗忘。为了解决这些问题,在本文件中提议了一个具有CS持久记忆的新DUN, 以优化方式进行。通过将高通量短期内存(HSM)和跨阶段长期内存(CLMMM)合并,我们设计了一个记忆强化的准度绘图模块(MAMMM),让DDDD(D)能够持续记忆的新的DUNUNDUN(D), 将多层内存/多层内存的MDRM(M) 功能传递到多层内存的多层内存。