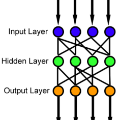

In this work, a non-gradient descent learning (NGDL) scheme was proposed for deep feedforward neural networks (DNN). It is known that an autoencoder can be used as the building blocks of the multi-layer perceptron (MLP) DNN, the MLP is taken as an example to illustrate the proposed scheme of pseudoinverse learning algorithm for autoencoder (PILAE) in this paper. The PILAE with low rank approximation is a NGDL algorithm, and the encoder weight matrix is set to be the low rank approximation of the pseudoinverse of the input matrix, while the decoder weight matrix is calculated by the pseudoinverse learning algorithm. It is worth to note that only very few network structure hyper-parameters need to be tuned compared with classical gradient descent learning algorithm. Hence, the proposed algorithm could be regarded as a quasi-automated training algorithm which could be utilized in automated machine learning field. The experimental results show that the proposed learning scheme for DNN could achieve better performance on considering the tradeoff between training efficiency and classification accuracy.

翻译:在这项工作中,为深向神经网络(DNN)提出了一个非梯度下层学习(NGDL)计划。已知一个自动编码器可以用作多层光谱(MLP)DNN(DNN)的构件,以MLP为例来说明本文件中拟议的自动下层光谱仪(PILAE)假反向学习算法(PILAE)计划。低级近似的PILAE是一种NGDL算法,编码器重量矩阵被设定为输入矩阵的伪伪面的低级近似值,而脱coder重量矩阵则由伪反向学习算法计算。值得注意的是,与经典梯度下层学习算法相比,只需要极少数网络结构超参数加以调整。因此,拟议的算法可被视为一种准自动培训算法,可用于自动机学习领域。实验结果表明,拟议的DNNN的学习计划在考虑培训效率和分类准确性之间取舍值方面可以取得更好的业绩。