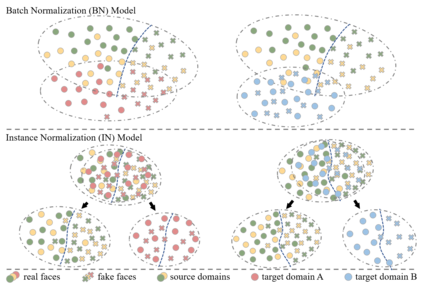

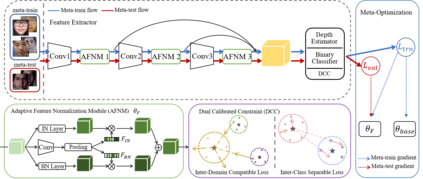

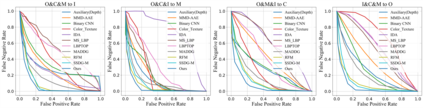

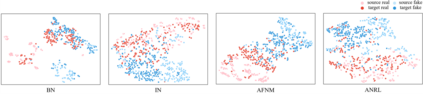

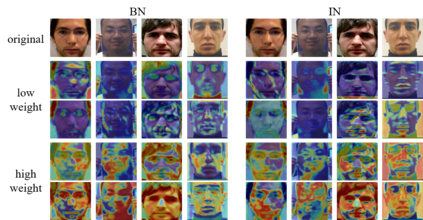

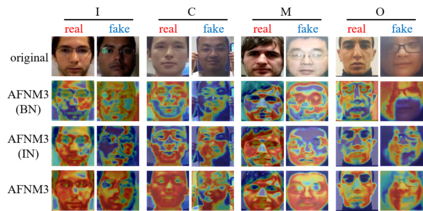

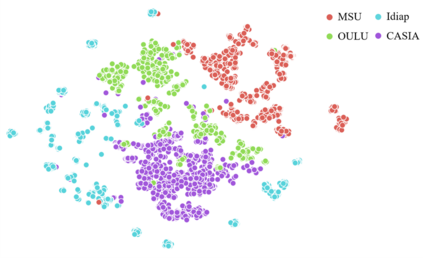

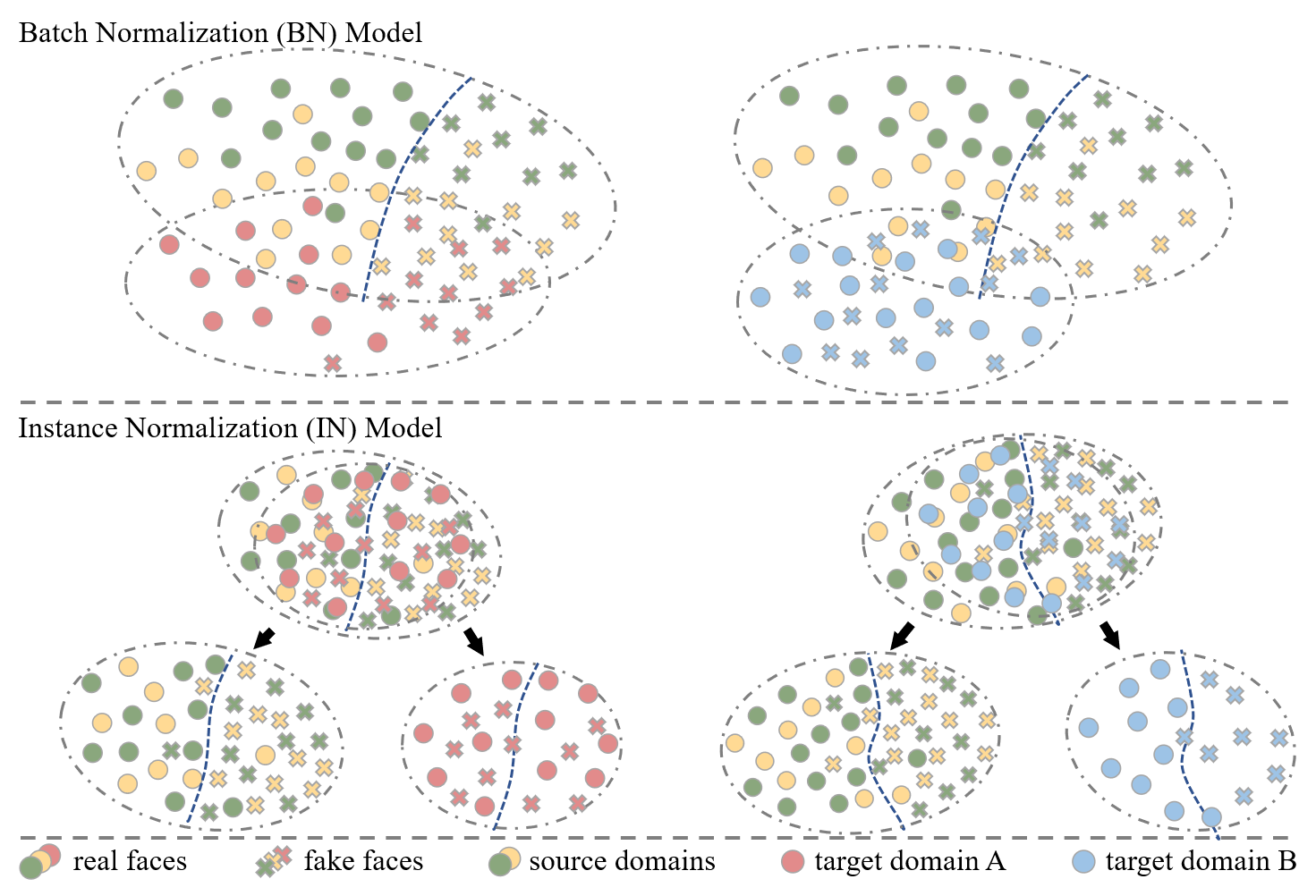

With various face presentation attacks arising under unseen scenarios, face anti-spoofing (FAS) based on domain generalization (DG) has drawn growing attention due to its robustness. Most existing methods utilize DG frameworks to align the features to seek a compact and generalized feature space. However, little attention has been paid to the feature extraction process for the FAS task, especially the influence of normalization, which also has a great impact on the generalization of the learned representation. To address this issue, we propose a novel perspective of face anti-spoofing that focuses on the normalization selection in the feature extraction process. Concretely, an Adaptive Normalized Representation Learning (ANRL) framework is devised, which adaptively selects feature normalization methods according to the inputs, aiming to learn domain-agnostic and discriminative representation. Moreover, to facilitate the representation learning, Dual Calibration Constraints are designed, including Inter-Domain Compatible loss and Inter-Class Separable loss, which provide a better optimization direction for generalizable representation. Extensive experiments and visualizations are presented to demonstrate the effectiveness of our method against the SOTA competitors.

翻译:由于在不为人知的情景下出现了各种面貌攻击,基于领域一般化(DG)的反排版(FAS)日益引起人们的注意。大多数现有方法都利用DG框架来调整特征,以寻求一个紧凑和普遍性的特征空间。然而,对FAS任务的特征提取过程,尤其是正常化的影响,没有给予多少注意,这也对所学代表性的普遍化产生了很大影响。为了解决这一问题,我们提出了一个面面部反排版的新视角,侧重于特征提取过程中的正常化选择。具体地说,设计了一个适应性标准化代表性学习(ANRL)框架,根据投入,适应性地选择了正常化方法,目的是学习域上性和歧视性代表。此外,为了便利代表性学习,设计了双重校准限制,包括互为可比较的损失和不同类别间可分解损失,为可实现的通用代表提供了更好的优化方向。介绍了广泛的实验和可视化,以展示我们对付SOTA竞争者的方法的有效性。