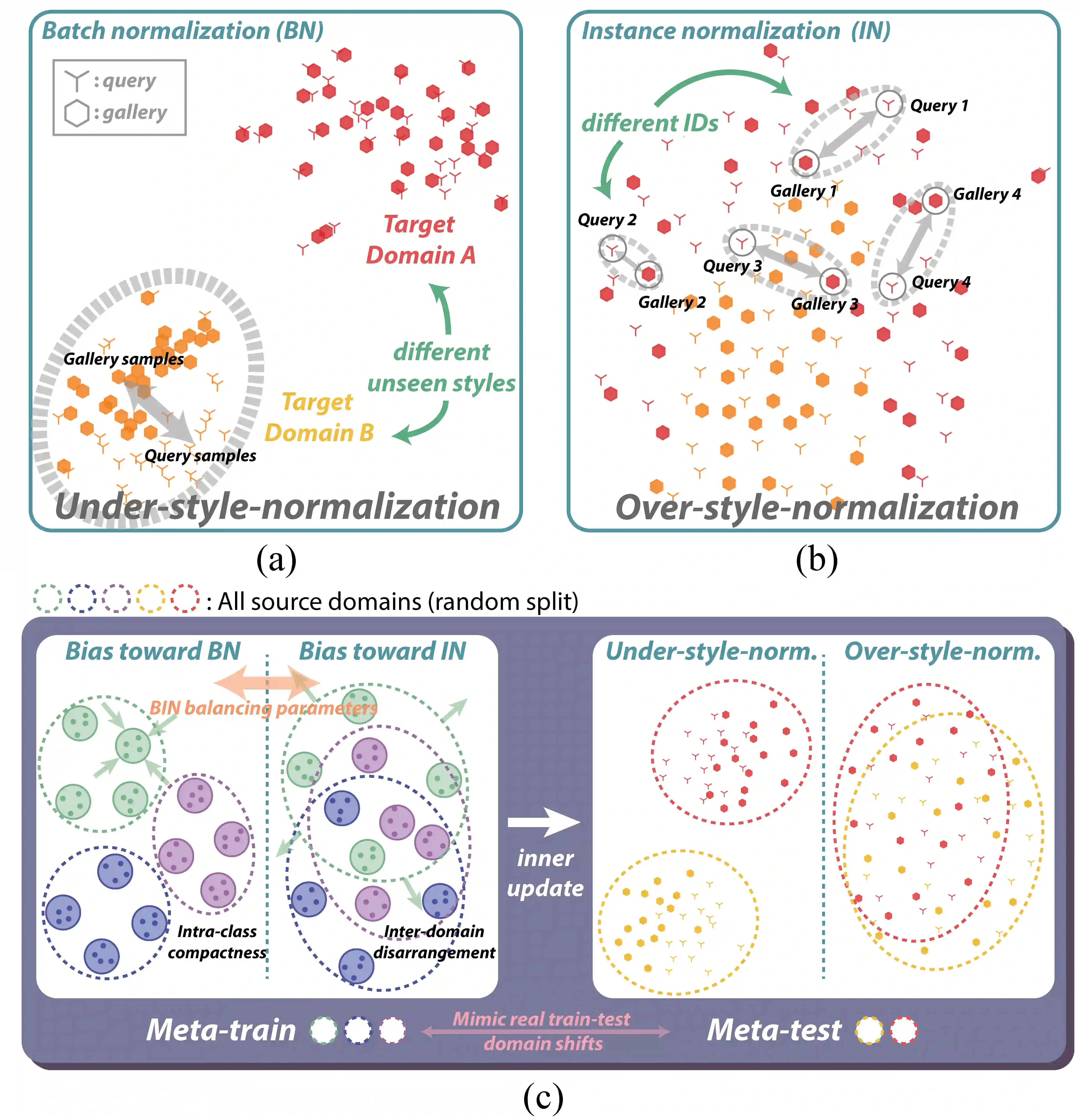

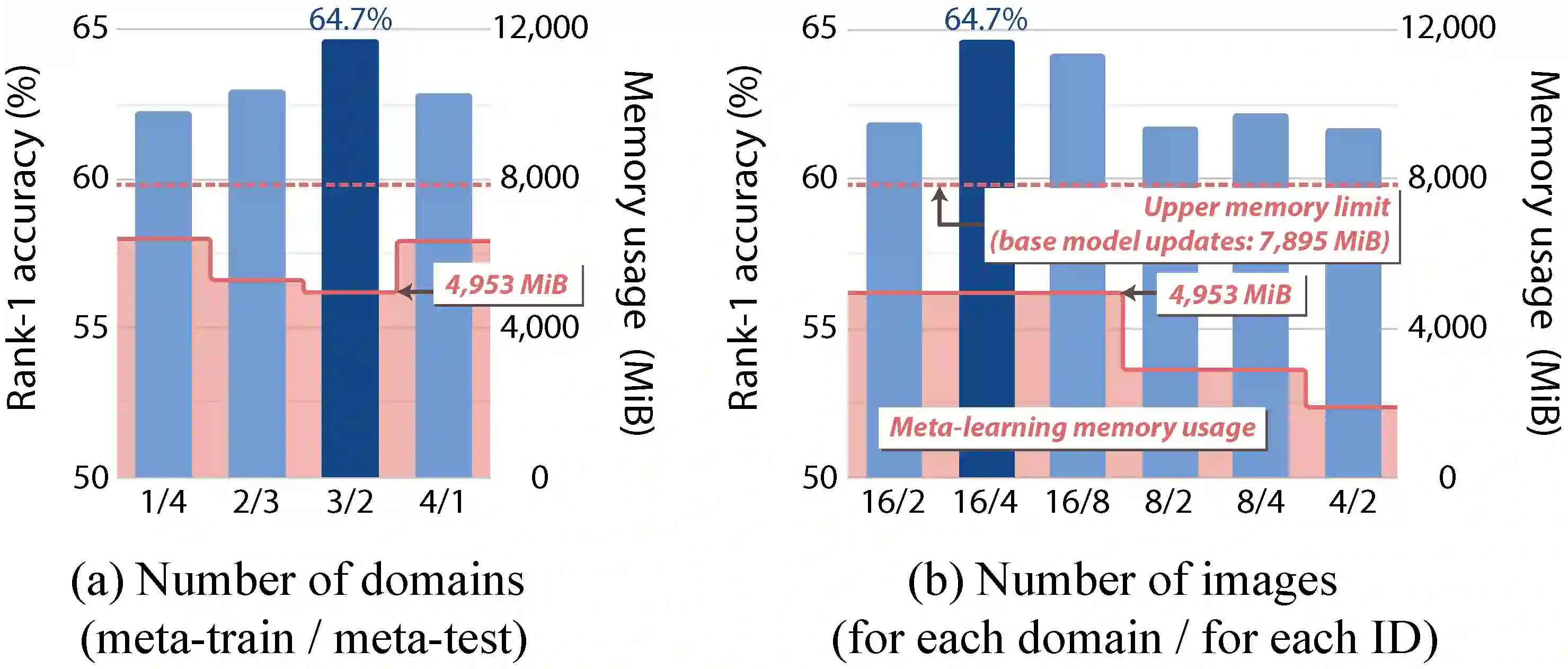

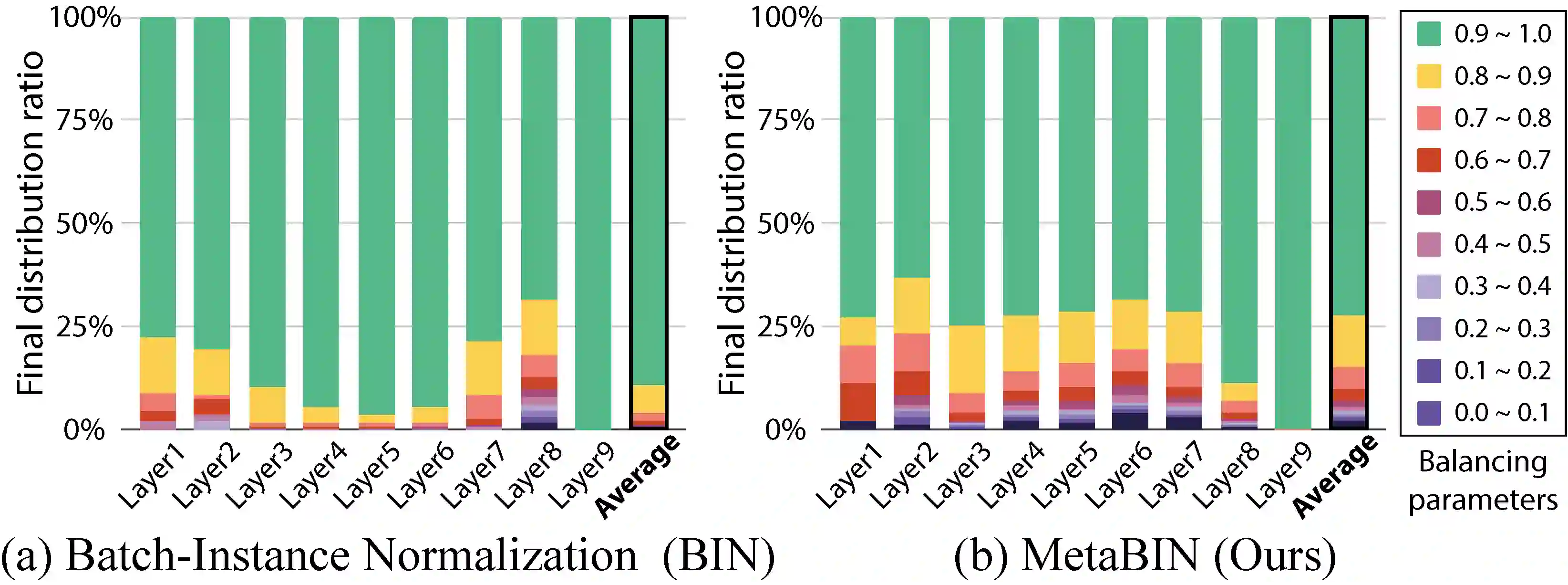

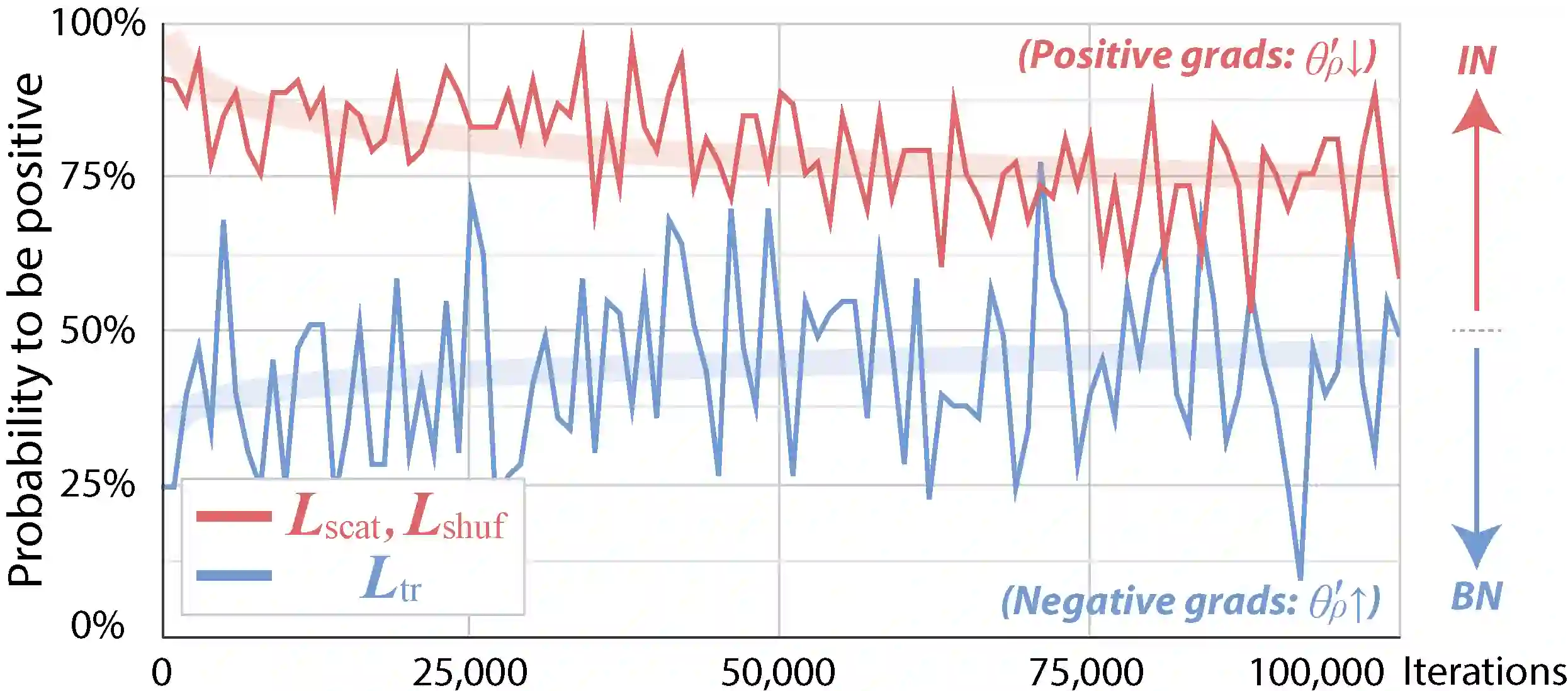

Although supervised person re-identification (Re-ID) methods have shown impressive performance, they suffer from a poor generalization capability on unseen domains. Therefore, generalizable Re-ID has recently attracted growing attention. Many existing methods have employed an instance normalization technique to reduce style variations, but the loss of discriminative information could not be avoided. In this paper, we propose a novel generalizable Re-ID framework, named Meta Batch-Instance Normalization (MetaBIN). Our main idea is to generalize normalization layers by simulating unsuccessful generalization scenarios beforehand in the meta-learning pipeline. To this end, we combine learnable batch-instance normalization layers with meta-learning and investigate the challenging cases caused by both batch and instance normalization layers. Moreover, we diversify the virtual simulations via our meta-train loss accompanied by a cyclic inner-updating manner to boost generalization capability. After all, the MetaBIN framework prevents our model from overfitting to the given source styles and improves the generalization capability to unseen domains without additional data augmentation or complicated network design. Extensive experimental results show that our model outperforms the state-of-the-art methods on the large-scale domain generalization Re-ID benchmark and the cross-domain Re-ID problem. The source code is available at: https://github.com/bismex/MetaBIN.

翻译:虽然监督人员的重新身份鉴定(Re-ID)方法表现出了令人印象深刻的成绩,但它们在隐蔽领域普遍化能力方面表现不佳,因此,普遍可实现的重新身份鉴定最近引起了越来越多的注意。许多现有方法都采用了例常化技术来减少样式变异,但歧视性信息的损失是无法避免的。在本文件中,我们提出了一个新的通用的重新身份鉴定框架,名为Meta Batch-Instance 正常化(MetaBIN)。我们的主要想法是通过在元学习管道之前模拟不成功的概括化情景,从而将正常化层普遍化。为此,我们将可学习的批量化正常化层与元化学习结合起来,并调查分批和实例正常化层造成的具有挑战性的案例。此外,我们通过我们的元培训损失使虚拟模拟多样化,并伴以循环的内置式内置方式提高一般化能力。毕竟,MetaBIN框架使我们的模型无法过度适应给定源模式,并在不增加数据增强或复杂网络设计的情况下改进隐蔽域的普及能力。广泛的实验结果显示,我们的模型超越了分级/跨域码法。