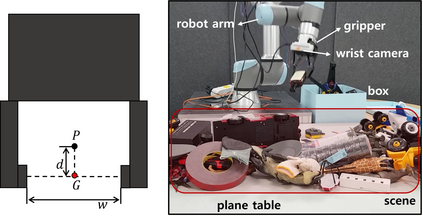

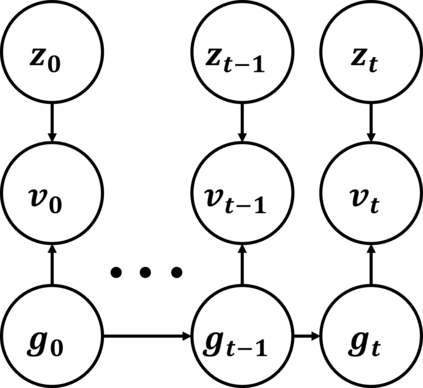

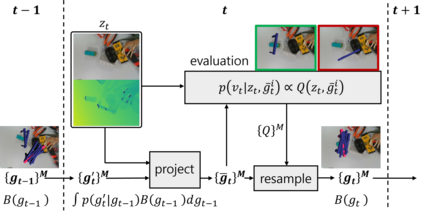

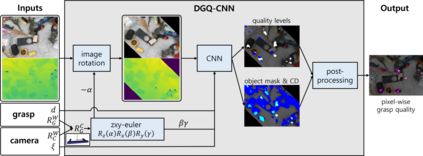

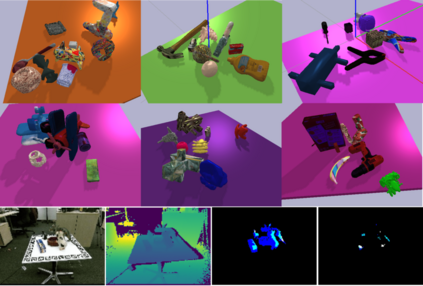

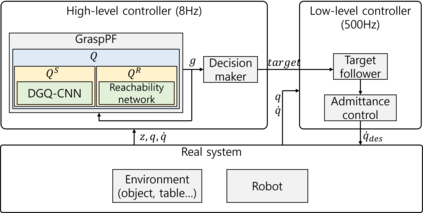

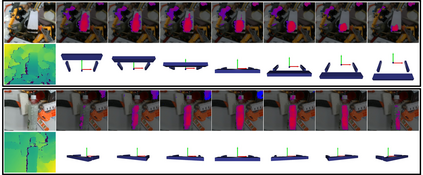

Although, in the task of grasping via a data-driven method, closed-loop feedback and predicting 6 degrees of freedom (DoF) grasp rather than conventionally used 4DoF top-down grasp are demonstrated to improve performance individually, few systems have both. Moreover, the sequential property of that task is hardly dealt with, while the approaching motion necessarily generates a series of observations. Therefore, this paper synthesizes three approaches and suggests a closed-loop framework that can predict the 6DoF grasp in a heavily cluttered environment from continuously received vision observations. This can be realized by formulating the grasping problem as Hidden Markov Model and applying a particle filter to infer grasp. Additionally, we introduce a novel lightweight Convolutional Neural Network (CNN) model that evaluates and initializes grasp samples in real-time, making the particle filter process possible. The experiments, which are conducted on a real robot with a heavily cluttered environment, show that our framework not only quantitatively improves the grasping success rate significantly compared to the baseline algorithms, but also qualitatively reacts to a dynamic change in the environment and cleans up the table.

翻译:虽然在通过数据驱动的方法掌握信息的任务中,封闭环路反馈和预测6度自由(DoF)捕捉而不是传统使用的4DoF自上而下地捕捉被证明可以提高个人性能,但很少有两种系统。此外,这项任务的顺序属性很少处理,而接近运动必然会产生一系列观测结果。因此,本文件综合了三种方法,并提出了一个封闭环框架,从不断收到的视觉观测中可以在一个极为模糊的环境中预测6DoF捕捉。这可以通过将捕捉问题作为隐藏Markov模型,并应用粒子过滤器来加以实现。此外,我们引入了一种新的轻量级神经网络(CNN)模型,实时评估和初始采集样本,使粒子过滤过程成为可能。实验是在一个真实的机器人上进行的,其环境极为混乱,实验表明我们的框架不仅在数量上大大改进了与基线算法相比的成功率,而且还在质量上对环境的动态变化作出反应,并清理了表。