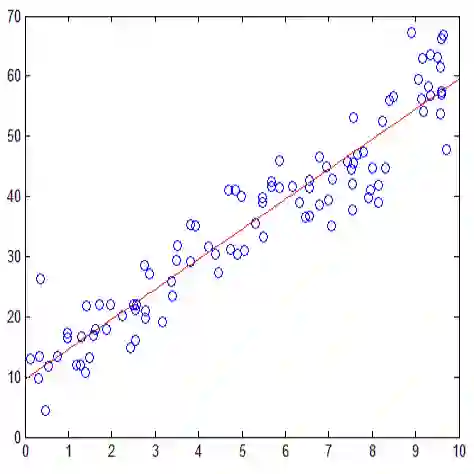

We prove theorems about the Gaussian asymptotics of an empirical bridge built from linear model regressors with multiple regressor ordering. We study the testing of the hypothesis of a linear model for the components of a random vector: one of the components is a linear combination of the others up to an error that does not depend on the other components of the random vector. The results of observations of independent copies of a random vector are sequentially ordered in ascending order of several of its components. The result is a sequence of vectors of higher dimension, consisting of induced order statistics (concomitants) corresponding to different orderings. For this sequence of vectors, without the assumption of a linear model for the components, we prove a lemma of weak convergence of the distributions of an appropriately centered and normalized process to a centered Gaussian process with almost surely continuous trajectories. Assuming a linear relationship of the components, standard least squares estimates are used to compute regression residuals -- the differences between response values and the predicted ones by the linear model. We prove a theorem of weak convergence of the process of regression residuals under the necessary normalization to a centered Gaussian process.

翻译:我们证明关于由线性模型递减器和多个递减器订购的实验桥的Gaussian 零点设置的实验桥的理论。 我们研究对随机矢量组成部分的线性模型假设的测试: 其中一个组件是其他矢量组成部分的线性组合, 最终是一个不取决于随机矢量其他组成部分的错误。 随机矢量独立副本的观测结果按其若干组成部分的升序顺序顺序顺序顺序排列。 结果是一个更高尺寸矢量的矢量序列, 包括与不同顺序对应的诱发顺序统计( comitants) 。 对于这个矢量序列, 没有假设组件的线性模型的线性模型, 我们证明, 一个适当的中心化和正常化进程分布到一个中心点的高斯进程, 几乎可以肯定连续的轨迹。 假设各组成部分的线性关系, 标准的最小方估计用于对回归残余物进行折算 -- -- 响应值和直线性模型预测值之间的差异。 我们证明, 在一个基本回归进程下, 渐趋的回归中心, 渐趋一致。