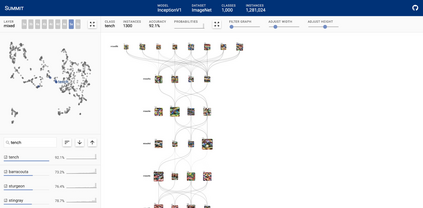

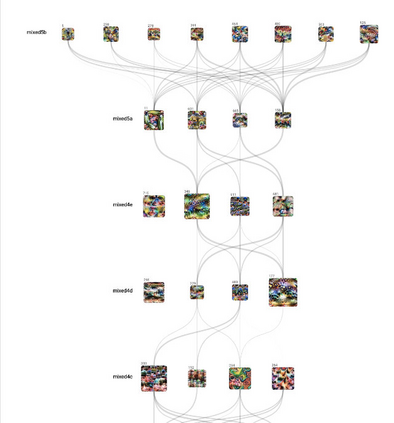

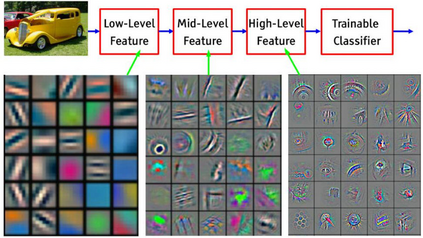

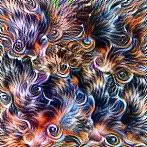

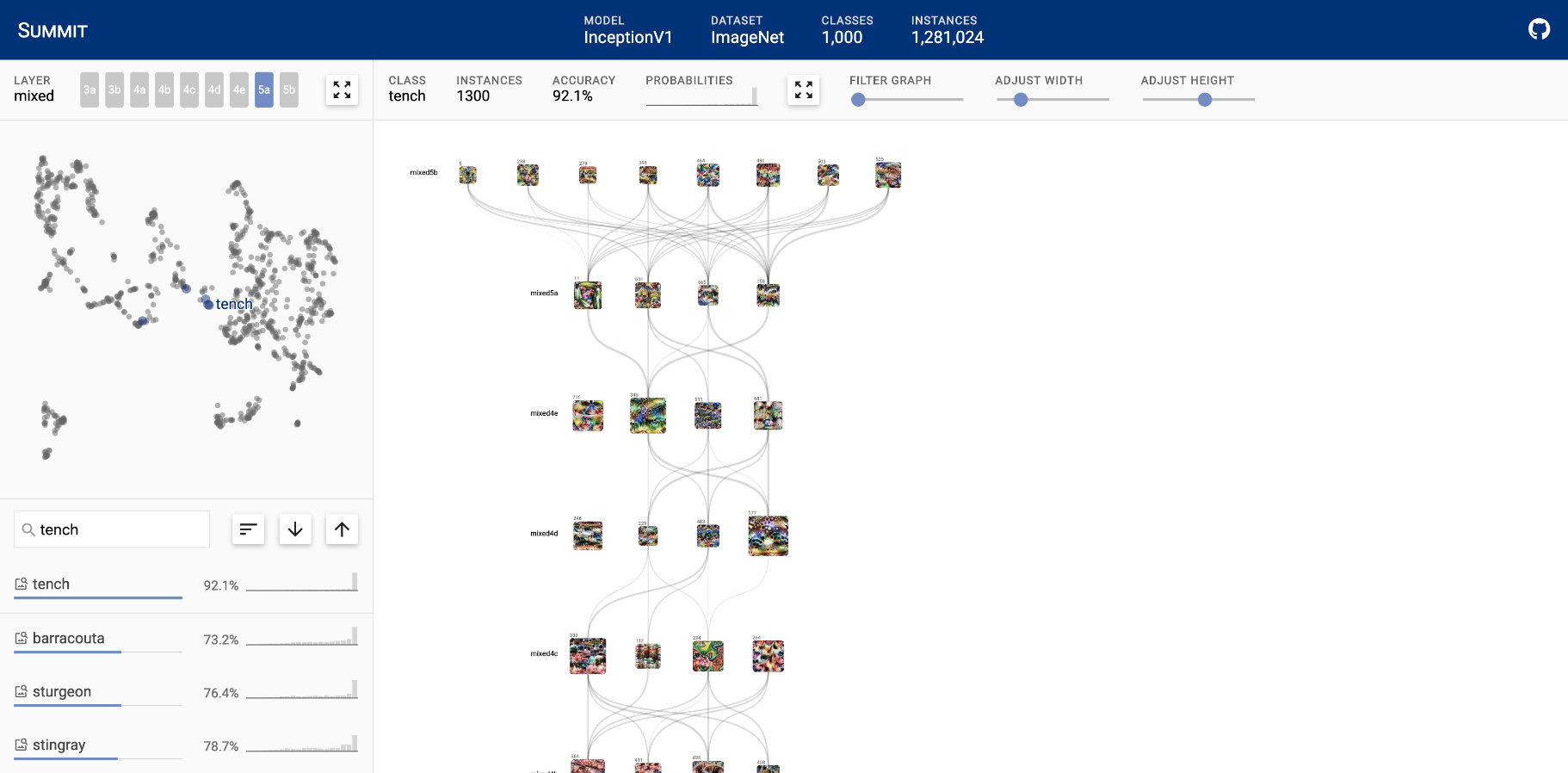

Deep learning is increasingly used in decision-making tasks. However, understanding how neural networks produce final predictions remains a fundamental challenge. Existing work on interpreting neural network predictions for images often focuses on explaining predictions for single images or neurons. As predictions are often computed based off of millions of weights that are optimized over millions of images, such explanations can easily miss a bigger picture. We present Summit, the first interactive system that scalably and systematically summarizes and visualizes what features a deep learning model has learned and how those features interact to make predictions. Summit introduces two new scalable summarization techniques: (1) activation aggregation discovers important neurons, and (2) neuron-influence aggregation identifies relationships among such neurons. Summit combines these techniques to create the novel attribution graph that reveals and summarizes crucial neuron associations and substructures that contribute to a model's outcomes. Summit scales to large data, such as the ImageNet dataset with 1.2M images, and leverages neural network feature visualization and dataset examples to help users distill large, complex neural network models into compact, interactive visualizations. We present neural network exploration scenarios where Summit helps us discover multiple surprising insights into a state-of-the-art image classifier's learned representations and informs future neural network architecture design. The Summit visualization runs in modern web browsers and is open-sourced.

翻译:深度学习越来越多地用于决策任务。然而,了解神经网络如何产生最终预测仍然是一个根本性的挑战。关于对图像解释神经网络预测的现有工作往往侧重于解释单一图像或神经元的预测。由于预测往往以数百万个图像优化的数以百万计的重量为基础进行计算,因此这种解释很容易错失一个大图象。我们介绍了峰会,这是第一个可调整和系统地总结和直观地显示深层次学习模型所学特征以及这些特征如何互动以作出预测的互动式系统。峰会引入了两种新的可缩放的合成技术:(1)激活集发现重要的神经元,(2)神经影响汇总发现这些神经元之间的关系。峰会将这些技术结合起来,创建新的属性图,显示和汇总有助于模型结果的关键神经关联和亚结构。峰会的尺度是大型数据,例如图像网络数据集,并利用神经网络的开放和数据集集示例,帮助用户将大型复杂的神经网络模型转化为紧凑、交互式可视化的可视化和数据集集集,我们将这些技术结合起来,在峰会上展示了一个令人惊讶的图像集成的图像集成图象。我们展示了峰会的图像集,从而了解了峰会的图像集。