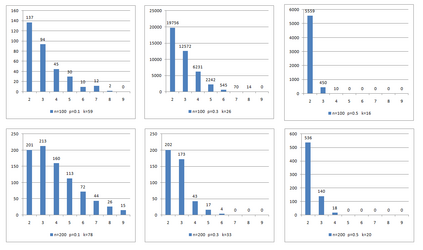

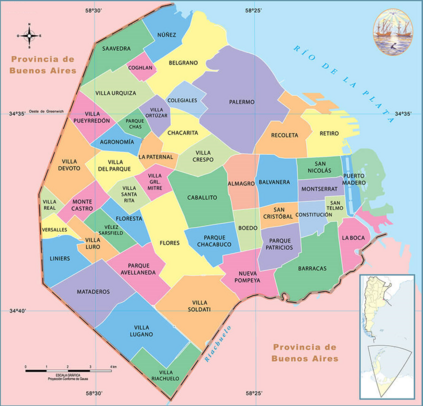

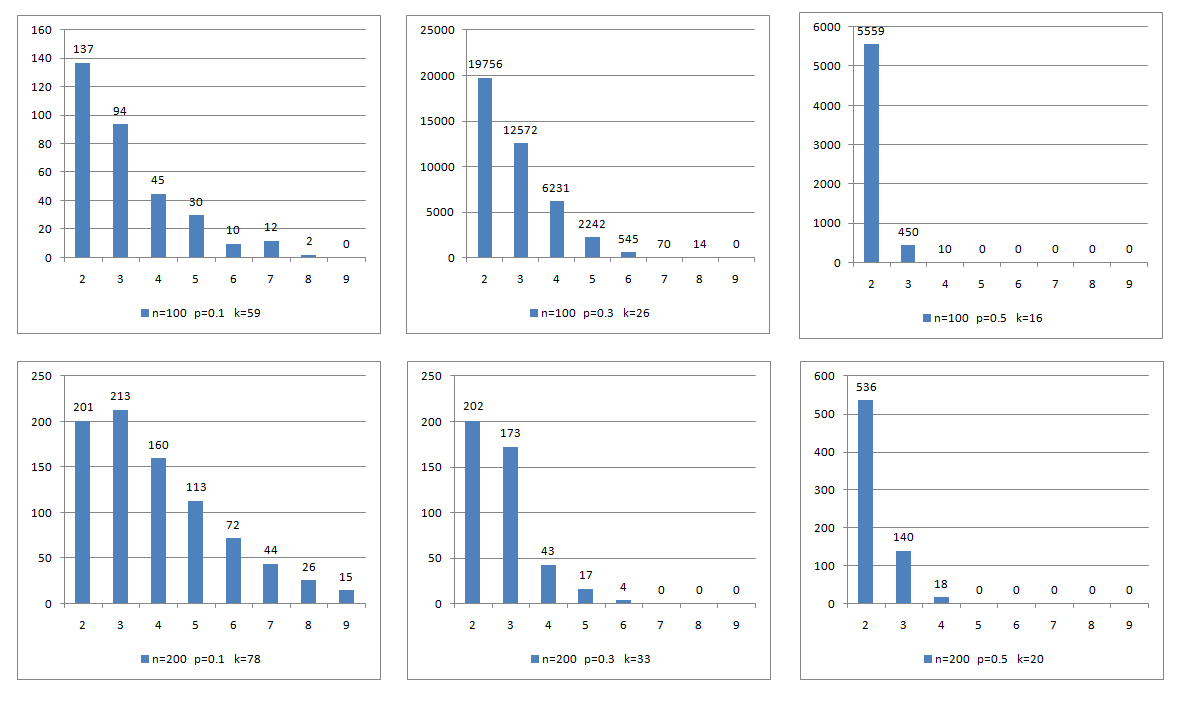

A sequence of vertices in a graph is called a legal dominating sequence if every vertex in the sequence dominates at least one vertex not dominated by those that precede it, and at the end all vertices of the graph are dominated. The Grundy domination number of a graph is the size of a largest legal dominating sequence. In this work, we introduce a generalized version of the Grundy domination problem. We explicitly calculate the corresponding parameter for paths and web graphs. We propose integer programming formulations for the new problem, find families of valid inequalities and perform extensive computational experiments to compare the formulations as well as to test these inequalities as cuts in a branch-and-cut framework. We also design and evaluate the performance of a heuristic for finding good initial lower and upper bounds and a tabu search that improves the initial lower bound. The test instances include randomly generated graphs, structured graphs, classical benchmark instances and two instances from a real application. Our approach is exact for graphs with 20-50 vertices and provides good solutions for graphs up to 10000 vertices.

翻译:图形中的顶端序列被称为法律支配序列。 如果每个顶端序列的顶端都支配至少一个顶端, 而不是其前端的顶端, 而图中的所有顶端都占主导地位。 图形的格伦迪支配数是最大的法律支配序列的大小。 在此工作中, 我们引入了格伦迪统治问题的普遍版本。 我们明确计算路径和网络图的相应参数。 我们为新问题提出了整数编程配方。 我们为20- 50个顶端的图表提供了精确的公式, 并进行了广泛的计算实验, 以比较这些配方, 以及测试分支和切割框架中的裁量。 我们还设计并评估了用于查找良好的初始下层和上层图的超能力, 以及用于改进初始下层的塔布搜索 。 测试实例包括随机生成的图形、 结构图、 经典基准实例 和两个真实应用的例子 。 我们的方法对20- 50 顶端的图表十分精确, 并为10 000 顶端的图表提供良好的解决方案 。