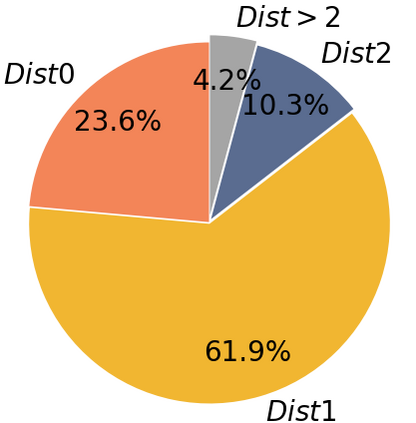

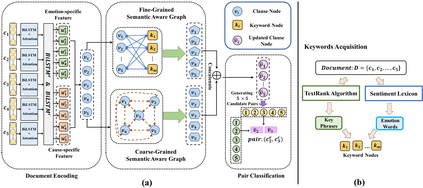

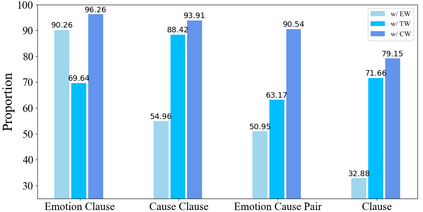

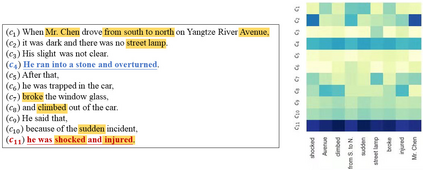

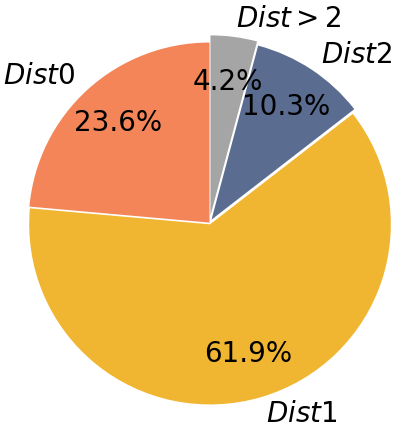

The Emotion-Cause Pair Extraction (ECPE) task aims to extract emotions and causes as pairs from documents. We observe that the relative distance distribution of emotions and causes is extremely imbalanced in the typical ECPE dataset. Existing methods have set a fixed size window to capture relations between neighboring clauses. However, they neglect the effective semantic connections between distant clauses, leading to poor generalization ability towards position-insensitive data. To alleviate the problem, we propose a novel \textbf{M}ulti-\textbf{G}ranularity \textbf{S}emantic \textbf{A}ware \textbf{G}raph model (MGSAG) to incorporate fine-grained and coarse-grained semantic features jointly, without regard to distance limitation. In particular, we first explore semantic dependencies between clauses and keywords extracted from the document that convey fine-grained semantic features, obtaining keywords enhanced clause representations. Besides, a clause graph is also established to model coarse-grained semantic relations between clauses. Experimental results indicate that MGSAG surpasses the existing state-of-the-art ECPE models. Especially, MGSAG outperforms other models significantly in the condition of position-insensitive data.

翻译:情感- 原因 Pair 提取( ECPE) 任务旨在从文档中提取情感和原因。 我们观察到情绪和原因的相对距离分布在典型的 ECPE 数据集中极不平衡。 现有方法设置了一个固定的大小窗口, 以捕捉相邻条款之间的关系。 但是, 它们忽略了遥远条款之间有效的语义联系, 导致对位置不敏感数据的概括性能力差。 为了缓解问题, 我们提议了一个新型的\ textbf{ Multi- textb{G}ranality\ textbf{S} mantic \ textbf{A} key offraph 模型( MGSAG), 以将精细和粗粗的语义化的语义性特征联合纳入其中, 而不考虑距离限制 。 特别是, 我们首先探索从传达精细的语义敏感特征的文件中提取的条款和关键词之间的语义依赖性关系, 获取强化的条款演示。 此外, 还将一个条款图表设置为模型的混微的语义- 结构- 模型在 EC- SAGA 现有磁性 实验 模型中显示其他的磁性模型 。