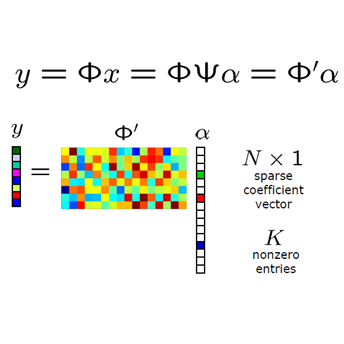

Deep Learning (DL) based Compressed Sensing (CS) has been applied for better performance of image reconstruction than traditional CS methods. However, most existing DL methods utilize the block-by-block measurement and each measurement block is restored separately, which introduces harmful blocking effects for reconstruction. Furthermore, the neuronal receptive fields of those methods are designed to be the same size in each layer, which can only collect single-scale spatial information and has a negative impact on the reconstruction process. This paper proposes a novel framework named Multi-scale Dilated Convolution Neural Network (MsDCNN) for CS measurement and reconstruction. During the measurement period, we directly obtain all measurements from a trained measurement network, which employs fully convolutional structures and is jointly trained with the reconstruction network from the input image. It needn't be cut into blocks, which effectively avoids the block effect. During the reconstruction period, we propose the Multi-scale Feature Extraction (MFE) architecture to imitate the human visual system to capture multi-scale features from the same feature map, which enhances the image feature extraction ability of the framework and improves the performance of image reconstruction. In the MFE, there are multiple parallel convolution channels to obtain multi-scale feature information. Then the multi-scale features information is fused and the original image is reconstructed with high quality. Our experimental results show that the proposed method performs favorably against the state-of-the-art methods in terms of PSNR and SSIM.

翻译:与传统的 CS 方法相比,基于深层学习(DL) 的压缩压缩(CS) 已经应用了比传统 CS 方法更好的图像重建表现。然而,大多数现有的DL 方法都使用逐条测量,每个测量区被分别恢复,这给重建带来有害的阻塞效应。此外,这些方法神经可接受领域的设计每个层的规模相同,只能收集单一尺度的空间信息,对重建进程产生消极影响。本文件提出了一个新的框架,名为“多规模闭路的革命神经网络”,用于CS 的测量和重建。在测量期间,我们直接从一个经过培训的测量网络中获取所有测量数据,该网络完全采用同流结构,并且从输入图像图像图像图像图像的网络中联合培训。这些方法不需要切入各个区,从而有效地避免了区效应。在重建期间,我们提出了“多规模的地貌提取(MFE) ” 架构,以仿照人类的拟议视觉系统,从同一特征地图中获取多规模的有利于性特征,从而增强框架的图像提取能力,改进图像质量的绩效。MFS-S-S-S-S-S-S-S-S-S-S-C-S-S-S-S-S-S-S-S-S-S-S-S-Simal-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-D-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-S-