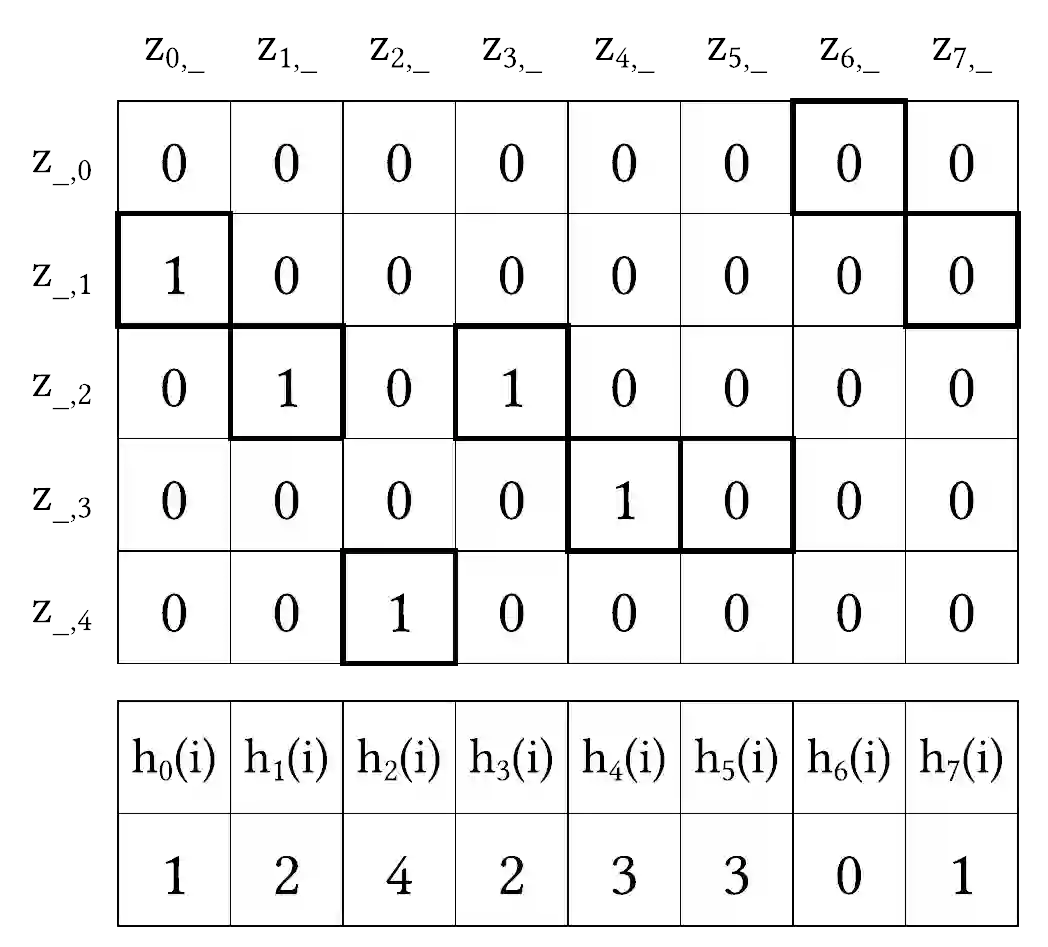

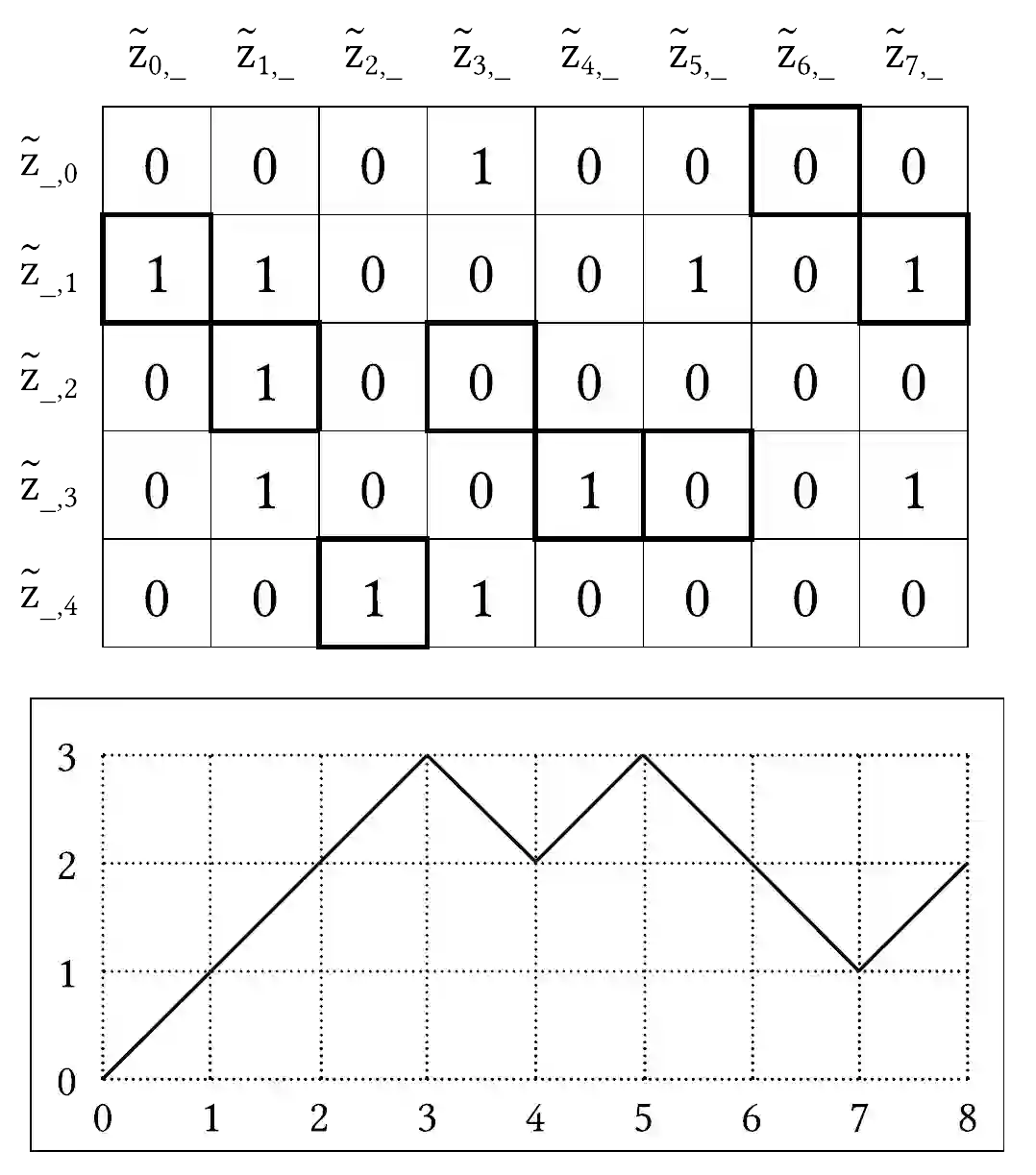

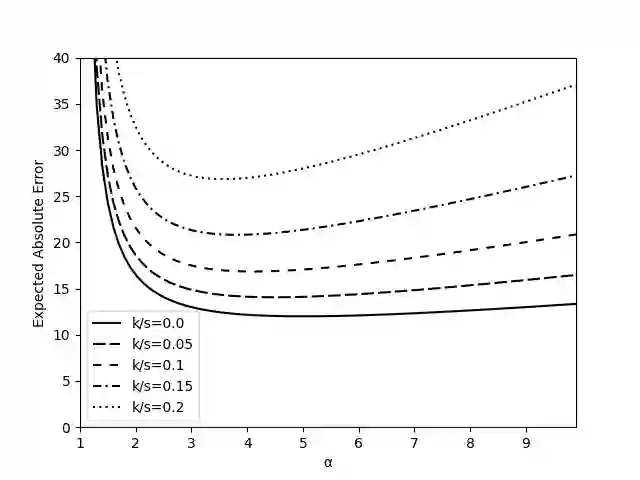

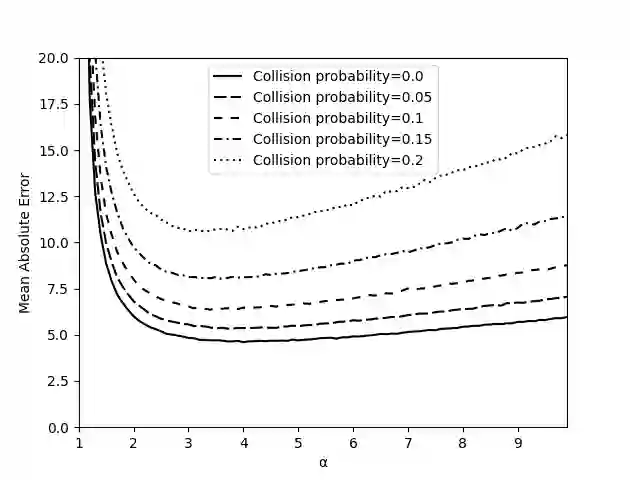

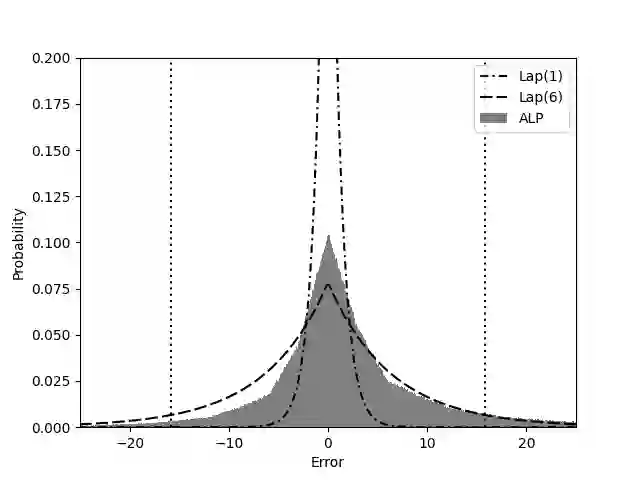

Representing a sparse histogram, or more generally a sparse vector, is a fundamental task in differential privacy. An ideal solution would use space close to information-theoretical lower bounds, have an error distribution that depends optimally on the desired privacy level, and allow fast random access to entries in the vector. However, existing approaches have only achieved two of these three goals. In this paper we introduce the Approximate Laplace Projection (ALP) mechanism for approximating k-sparse vectors. This mechanism is shown to simultaneously have information-theoretically optimal space (up to constant factors), fast access to vector entries, and error of the same magnitude as the Laplace-mechanism applied to dense vectors. A key new technique is a unary representation of small integers, which is shown to be robust against ``randomized response'' noise. This representation is combined with hashing, in the spirit of Bloom filters, to obtain a space-efficient, differentially private representation. Our theoretical performance bounds are complemented by simulations which show that the constant factors on the main performance parameters are quite small, suggesting practicality of the technique.

翻译:代表一种稀薄的直方图,或更一般地代表一种稀疏的矢量,是不同隐私中的一项基本任务。理想的解决方案将使用接近信息理论下限的空间,使用最理想的偏差分布,以理想的隐私水平为最理想,并允许快速随机访问矢量中的条目。但是,现有方法只达到了这三项目标中的两项。在本文中,我们引入了近似 Laplace 投影( ALP) 机制, 以适应 k- sparse 矢量。 这个机制显示同时拥有信息- 理论最佳空间( 以恒定系数为限 ), 快速访问矢量条目, 以及与对密度矢量矢量应用的 Laplace- 机械性能相同大小的错误。 一种关键的新技术是小整数的单数, 显示它能抵御“ 调整响应” 的噪音。 这个表达方式结合了“ ”, 以Bloom 过滤器的精神, 获得空间高效的、 差异的私人代表。我们的理论性能约束得到了模拟的补充, 它的模拟显示主要性能参数参数参数非常小, 意味着技术的实际性。