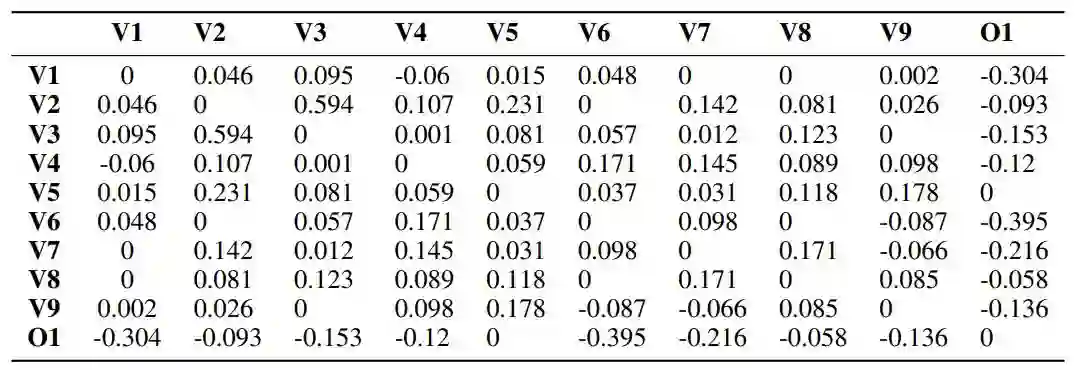

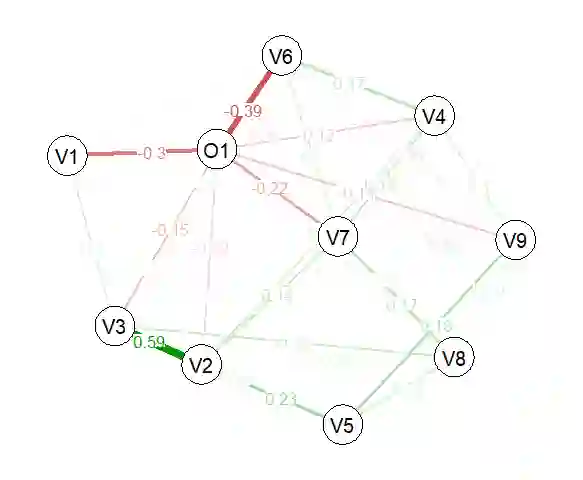

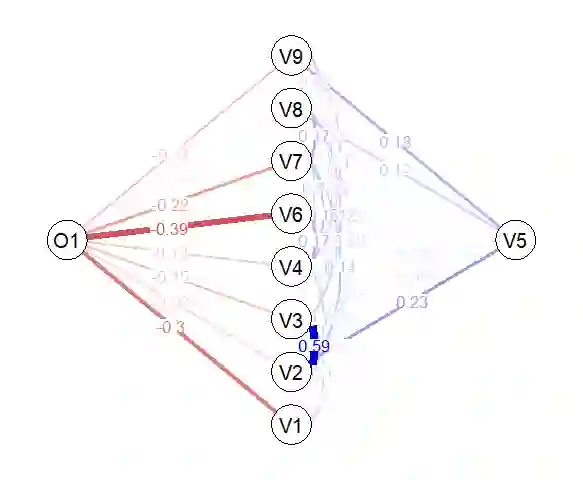

Explainable artificial intelligence (XAI) is an emerging new domain in which a set of processes and tools allow humans to better comprehend the decisions generated by black box models. However, most of the available XAI tools are often limited to simple explanations mainly quantifying the impact of individual features to the models' output. Therefore, human users are not able to understand how the features are related to each other to make predictions, whereas the inner workings of the trained models remain hidden. This paper contributes to the development of a novel graphical explainability tool that not only indicates the significant features of the model but also reveals the conditional relationships between features and the inference capturing both the direct and indirect impact of features to the models' decision. The proposed XAI methodology, termed as gLIME, provides graphical model-agnostic explanations either at the global (for the entire dataset) or the local scale (for specific data points). It relies on a combination of local interpretable model-agnostic explanations (LIME) with graphical least absolute shrinkage and selection operator (GLASSO) producing undirected Gaussian graphical models. Regularization is adopted to shrink small partial correlation coefficients to zero providing sparser and more interpretable graphical explanations. Two well-known classification datasets (BIOPSY and OAI) were selected to confirm the superiority of gLIME over LIME in terms of both robustness and consistency over multiple permutations. Specifically, gLIME accomplished increased stability over the two datasets with respect to features' importance (76%-96% compared to 52%-77% using LIME). gLIME demonstrates a unique potential to extend the functionality of the current state-of-the-art in XAI by providing informative graphically given explanations that could unlock black boxes.

翻译:可解释的人工智能(XAI)是一个新兴领域,在这个领域,一套流程和工具使人类能够更好地理解黑盒模型产生的决定。然而,大多数可用的 XAI 工具往往局限于简单解释,主要量化模型输出的单个特性的影响。因此,人类用户无法理解这些特性是如何相互联系来作出预测的,而受过训练的模型的内部功能仍然隐藏着。本文件有助于开发一个新的图形解释工具,它不仅能显示模型的重要特点,而且能揭示功能和推断之间的有条件关系,从而捕捉模型决定的特性的直接和间接影响。拟议的 XAI 方法,称为 gLIME, 提供了全球(整个数据集)或本地规模(具体数据点)的图形模型解释。它依赖于当地可解释的模式解释(LIME)的组合,它不仅能显示模型的绝对缩小和选择操作者(GLASSO),还能显示各种特性之间的有条件关系和推断关系,能够捕捉模型的特性的直接和间接影响。拟议的 XAI 方法,能够以小部分的模型解释方式,通过IMILILI 的精确性解释, 以精确性解释,将LI-ral-ral-li-lial-lial-lial-lial-lial-lial-lial-lial-lial-li-li-lial-lial-lial-lial-lial-lational-al-lational-lational-lational-lational-lational-l-l-l-l-lation-lational-lational-lational-lational-lational-lation-lation-lation-lation-lational-lational-lation-lation-lation-lation-lation-lation-lation-lation-l-l-l-l-l-l-l-l-lation-l-l-l-l-l-l-l-l-lation-lational-lation-lation-lation-lation-l-l-l-l-l-l-l-l-l-l-l-l-l-l-l-l-l-l-l-l-l-l-lation-l-l-l-l-l-l-l